En enero de 2022, investigadores de Google publicaron un artículo que cambió la forma en que la gente habla sobre la IA. Descubrieron que añadir una frase simple antes de pedirles a los modelos de lenguaje que resolvieran problemas podía disparar la precisión del 17,7% al 78,7% en problemas de matemáticas enunciados.

¿La frase? “Let’s think step by step.”

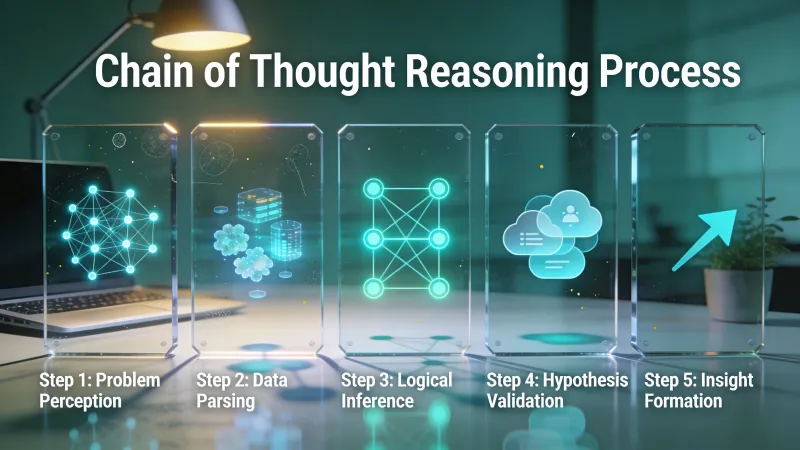

No era magia. Era el prompting con cadena de pensamiento, una técnica que le da a la IA algo parecido a un papel de borrador para ir resolviendo problemas.

La investigación detrás de esto

Jason Wei y sus colegas de Google Brain hicieron experimentos con tres modelos de lenguaje grandes. Probaron razonamiento aritmético, preguntas de sentido común y manipulación simbólica. El patrón se mantuvo en todas las categorías: cuando los modelos mostraban su trabajo, acertaban más.

En el benchmark matemático GSM8K, su modelo de 540 mil millones de parámetros llegó al 58% de precisión con prompting de cadena de pensamiento. ¿Prompts estándar? Ni de cerca. Un trabajo posterior usando self-consistency empujó esto al 74%.

El resultado más llamativo vino de Sports Understanding. PaLM 540B alcanzó 95% de precisión, superando a expertos humanos sin ayuda que sacaron 84%.

Unos meses después, investigadores de la Universidad de Tokio y Google publicaron “Large Language Models are Zero-Shot Reasoners.” Descubrieron que ni siquiera necesitas ejemplos. Solo añade “Let’s think step by step” y la precisión en MultiArith saltó de 17,7% a 78,7%. GSM8K pasó de 10,4% a 40,7%.

Eso son 61 puntos porcentuales de mejora por una sola frase.

¿Por qué funciona?

Un usuario de Hacker News llamado leobg explicó bien la mecánica:

“I think the idea is that the LLM cannot think internally. It’s output is its thinking process. Especially with an auto regressive architecture like GPT, where each output token becomes part of the input. I imagine it like handing the LLM a piece of scratch paper.”

Esto captura algo importante. Los modelos de lenguaje generan un token a la vez. Cada token se convierte en contexto para el siguiente. Cuando pides respuestas inmediatas, el modelo tiene que comprimir todo el razonamiento en elegir la primera palabra correcta. Pero cuando pides pasos, cada conclusión intermedia pasa a formar parte de la entrada de lo que viene después.

Considera este problema de matemáticas: “Roger tiene 5 pelotas de tenis. Compra 2 latas más de 3. ¿Cuántas pelotas de tenis tiene ahora?”

Resolverlo exige entender el enunciado, identificar las operaciones y calcular bien. Pedir la respuesta directamente obliga al modelo a hacer todo eso en el salto de pregunta a número.

Pedir pasos le permite fijar cada pieza. Roger empieza con 5. Compra 2 latas. Cada lata tiene 3 pelotas. Así que compra 6 pelotas. 5 más 6 son 11.

Cada oración restringe lo que viene después. El modelo construye hacia la respuesta en lugar de adivinarla.

La trampa que nadie menciona primero

Esto es lo que se saltan los artículos de moda: el prompting con cadena de pensamiento solo funciona con modelos grandes.

La investigación original encontró que esto es una «propiedad emergente de la escala del modelo». Por debajo de, aproximadamente, 100 mil millones de parámetros, pedir razonamiento paso a paso en realidad empeoró el rendimiento. Los modelos más pequeños producían lo que parecía una cadena de razonamiento, pero contenía errores lógicos. Los pasos, con tono seguro, llevaban a respuestas incorrectas más a menudo que simplemente preguntar de forma directa.

Si estás usando un modelo local más pequeño, esta técnica puede salirte al revés. Pruébala. Compara resultados con y sin la instrucción de paso a paso. No asumas que la investigación aplica a tu configuración específica.

Dos formas de hacerlo

Enfoque zero-shot: solo añade la frase. No hacen falta ejemplos.

“Un bate y una pelota cuestan $1.10 en total. El bate cuesta $1 más que la pelota. ¿Cuánto cuesta la pelota? Vamos a pensarlo paso a paso.”

Funciona sorprendentemente bien. No cuesta nada extra en longitud del prompt.

Enfoque few-shot: primero muestra al modelo cómo se ve un buen razonamiento.

Aquí tienes un problema de matemáticas y cómo resolverlo paso a paso:

Pregunta: Hay 15 árboles en la arboleda. Los trabajadores de la arboleda plantarán árboles hoy. Cuando terminen, habrá 21 árboles. ¿Cuántos árboles plantaron hoy los trabajadores?

Razonamiento: Empezamos con 15 árboles. Terminamos con 21 árboles. La diferencia es lo que se plantó. 21 menos 15 es 6.

Respuesta: 6

Ahora resuelve este de la misma manera: [tu pregunta real]

El few-shot usa más tokens, pero a menudo produce mejores resultados en tareas complejas. Los ejemplos enseñan formato y profundidad, no solo la idea general de mostrar el trabajo.

Tareas que se benefician

El prompting con cadena de pensamiento brilla en problemas con varios pasos donde los errores se acumulan. Problemas de matemáticas enunciados. Rompecabezas lógicos. Planificación en varios pasos. Cualquier cosa donde tú mismo usarías papel de borrador.

El análisis de IBM destaca aplicaciones prácticas: bots de atención al cliente desglosando problemas, tareas de investigación que requieren construir hipótesis, explicaciones educativas en matemáticas y ciencias. La técnica funciona mejor cuando la tarea realmente tiene pasos intermedios que informan la respuesta final.

Otro comentarista de Hacker News, travisjungroth, hizo una observación que se me quedó grabada:

“Most writing about anything difficult is product, not process. Articles get drafts before being published. People think about answers before writing them down. How to Solve It does a great job explaining this about math problems. The steps to the proof are not the steps to creating the proof. So when you go to solve a problem by mimicking the solutions to problems, something is missing.”

Esto importa. La solución publicada de un problema de matemáticas no se parece en nada al proceso real de resolverlo. Los modelos de lenguaje entrenados con respuestas finales ya “limpias” nunca vieron el trabajo desordenado que llevó ahí. Pedir pasos recrea algo que faltaba en el entrenamiento.

Tareas que no se benefician

Las búsquedas simples no ganan nada. Preguntar “¿Cuál es la capital de Francia?” con instrucciones paso a paso solo produce una salida más larga sin mejorar la precisión. El modelo ya tiene esta respuesta disponible.

Las tareas que requieren creatividad más que razonamiento mejoran menos. Escribir poesía, generar texto publicitario, proponer nombres. No tienen pasos lógicos que mostrar. Forzarlas dentro de un marco de razonamiento se siente raro y puede limitar la salida sin necesidad.

Una investigación reciente encontró que los beneficios no se generalizan tan ampliamente como sugería el entusiasmo inicial. Los prompts de CoT mejoran a los modelos en tareas de planificación específicas, pero no se transfieren bien entre dominios. Las mejoras son reales, pero más estrechas de lo que a veces se vende.

Tampoco hay garantía de que el razonamiento sea fiel. El modelo puede producir pasos plausibles que en realidad no reflejan cómo llegó a la respuesta. Esto crea un riesgo de falsa confianza. Ves una cadena lógica y asumes corrección, pero los pasos podrían ser una racionalización posterior en vez de razonamiento genuino.

El coste computacional importa

Más tokens significa más tiempo y dinero. Si estás llamando a una API, las respuestas con cadena de pensamiento cuestan más que las respuestas directas. En aplicaciones de alto volumen, esto se acumula rápido.

Piensa si la mejora de precisión justifica el coste. Un bot de atención al cliente respondiendo preguntas frecuentes simples probablemente no necesita cadenas de razonamiento. Un sistema haciendo cálculos financieros probablemente sí.

Cómo ponerlo en práctica

Para problemas de matemáticas y lógica, empieza con zero-shot. Añade “Vamos a pensar paso a paso” o “Resuélvelo paso a paso” a tu prompt. Compara resultados contra tu línea base.

Para tareas complejas de varios pasos, considera ejemplos few-shot que muestren la profundidad de razonamiento que quieres. Uno o dos buenos ejemplos a menudo superan al puro zero-shot en problemas más difíciles.

Para cualquier cosa que implique planificación, prueba a dividir la tarea en fases explícitas. Pide primero el plan y luego la ejecución. Esto es cadena de pensamiento aplicada a nivel de tarea, no de oración.

Si la precisión importa más que la velocidad, añade un paso de verificación. Después de que el modelo llegue a una respuesta, pídele que revise el trabajo. Esto atrapa algunos errores que se cuelan en el razonamiento inicial.

Aquí tienes un ejemplo que muestra la diferencia en la práctica:

Sin cadena de pensamiento:

“Los ingresos de una empresa crecieron 20% en el Q1 y luego bajaron 15% en el Q2. ¿Cuál fue el cambio neto?”

Modelo: “5% de crecimiento”

Esa respuesta es incorrecta. El modelo multiplicó en vez de calcular porcentajes compuestos.

Con cadena de pensamiento:

“Los ingresos de una empresa crecieron 20% en el Q1 y luego bajaron 15% en el Q2. ¿Cuál fue el cambio neto? Vamos a resolverlo paso a paso.”

Modelo: “Empezando con 100 como base. Después de un 20% de crecimiento: 100 x 1.20 = 120. Después de una caída del 15% desde esa nueva cantidad: 120 x 0.85 = 102. Cambio neto: 102 - 100 = 2, o sea 2% de crecimiento.”

El razonamiento forzado evita el error del atajo. El modelo no puede saltar a “20 menos 15” porque tiene que recorrer el cálculo real.

Variantes que conviene conocer

La técnica básica ha dado lugar a varias extensiones.

Self-consistency genera múltiples rutas de razonamiento y se queda con la respuesta mayoritaria. Si le pides al modelo que resuelva un problema cinco veces con cadena de pensamiento, y obtiene la misma respuesta cuatro veces, esa respuesta probablemente sea la correcta. Este enfoque subió la precisión de GSM8K del 58% al 74% en la investigación de seguimiento de Google.

Tree of Thoughts explora varias ramas de razonamiento a la vez, en lugar de comprometerse con una sola ruta. Útil cuando de verdad hay diferentes enfoques para un problema y quieres explorar varios antes de elegir.

Least-to-Most prompting divide problemas complejos en subproblemas, resuelve primero los más simples y usa esas soluciones para abordar las partes más difíciles. Va bien para problemas con jerarquías o dependencias naturales.

Estas variantes añaden complejidad. Domina primero la versión básica. La mayoría de la gente obtiene valor significativo con solo añadir “vamos a pensar paso a paso” y nunca necesita las opciones más elaboradas.

El panorama general

El prompting con cadena de pensamiento funciona porque aprovecha cómo funcionan de verdad estos modelos. Predicen el siguiente token. Cada palabra restringe la probabilidad de lo que viene después. Pedir razonamiento crea restricciones útiles que se acumulan hacia respuestas correctas.

Esto podría volverse obsoleto. Modelos entrenados específicamente para razonar, como los que traen modos integrados de “pensamiento”, pueden internalizar estos patrones. El prompt explícito podría dejar de ser necesario a medida que el comportamiento se “hornee” dentro de los pesos del modelo.

Pero por ahora, con los modelos actuales, la técnica sigue siendo valiosa. Cuesta una sola frase y puede multiplicar la precisión en las tareas correctas. La clave es saber cuáles son esas tareas.

¿Cómo sabrías si el razonamiento que un modelo te muestra es el razonamiento que realmente usó?