Nel giugno 2018, OpenAI pubblicò un paper che quasi nessuno notò. Il titolo era asciutto: “Improving Language Understanding by Generative Pre-Training.” Il modello descritto aveva 117 milioni di parametri. Poteva completare frasi e rispondere a domande di base su brani di testo.

Cinque anni dopo, GPT-4 scriveva memorie legali, faceva debug di software complessi e superava esami professionali che la maggior parte degli esseri umani fallisce. Il salto da quel paper del 2018 al sistema multimodale del 2023 rappresenta uno dei più rapidi balzi di capacità nella storia dell’informatica.

Ma il percorso non fu lineare. Ci fu una polemica sull’“IA pericolosa” che oggi sembra assurda, una scommessa sulla scala che molti ricercatori credevano sbagliata e un lancio di prodotto che nessuno aveva previsto sarebbe diventato l’app consumer in più rapida crescita mai costruita.

GPT-1: la prova che nessuno vide

Il paper originale su GPT arrivò in un momento tranquillo della ricerca sull’IA. I Transformer erano stati introdotti un anno prima. I ricercatori stavano ancora capendo cosa potesse fare quell’architettura.

Il contributo di OpenAI fu concettuale. Dimostrarono che potevi addestrare un modello linguistico su enormi quantità di testo non etichettato, e poi rifinirlo per compiti specifici con piccole quantità di dati etichettati. Prima addestri. Poi specializzi.

Questo conta perché i dati etichettati costano. Qualcuno deve leggere ogni esempio e segnare se esprime sentiment positivo o negativo, se contiene un’entità nominata, se risponde correttamente a una domanda. Ottenere milioni di esempi etichettati costa soldi veri e richiede tempo vero.

Il testo non etichettato, invece, è praticamente gratis. Internet ne produce in continuazione. GPT-1 dimostrò che potevi estrarre conoscenza utile da testo grezzo e poi applicarla a compiti successivi con un addestramento aggiuntivo minimo.

Il modello fece 72.8 su GLUE, un benchmark per la comprensione del linguaggio. Il record precedente era 68.9. Un miglioramento significativo, ma non tale da suggerire che la tecnologia avrebbe rimodellato interi settori nel giro di mezzo decennio.

La maggior parte dei ricercatori di IA, all’epoca, era concentrata su altri approcci. GPT-1 era interessante. Non era ovviamente destinato a cambiare il mondo.

GPT-2: la polemica invecchiata male

OpenAI rilasciò GPT-2 nel febbraio 2019. Aveva 1,5 miliardi di parametri. Circa tredici volte più di GPT-1. Il modello riusciva a generare paragrafi di testo coerenti su quasi qualsiasi argomento.

Poi successe qualcosa di insolito. OpenAI annunciò che non avrebbe rilasciato il modello completo. Il motivo: timori di abuso. La copertura stampa fu immediata. Un’IA troppo pericolosa per essere rilasciata? I titoli si scrivevano da soli.

La reazione della comunità tecnica fu mista e, guardando indietro anni dopo, lo scetticismo si rivelò fondato. Su Hacker News, l’utente empiko colse ciò che molti avrebbero finito per pensare: “I remember when GPT-2 was ‘too dangerous’ to release. I am confused why people still take these clown claims seriously.”

Altri sospettarono che l’inquadramento fosse strategico. L’utente sva_ notò: “The GPT2 weights have later been released which made some people suspect the ‘too dangerous to release’ stuff was mostly hype/marketing.”

OpenAI alla fine rilasciò il modello completo nel novembre 2019, nove mesi dopo l’annuncio iniziale. L’ondata prevista di disinformazione generata dall’IA non si materializzò. Almeno non a causa di GPT-2.

Ciò che conta di GPT-2 non è la polemica. La polemica è invecchiata male. Ciò che conta è che OpenAI dimostrò che aumentare la scala funzionava. Un modello tredici volte più grande performava molto meglio. Erano dati, non teoria. Avrebbero informato tutto ciò che venne dopo.

GPT-3: quando gli scettici si sbagliavano

GPT-3 arrivò nel giugno 2020. I numeri erano impressionanti. 175 miliardi di parametri. Addestrato su 570 gigabyte di testo. Il modello era più di cento volte più grande di GPT-2.

Molti ricercatori pensarono che fosse uno spreco. I modelli più grandi sono costosi da addestrare e costosi da eseguire. L’assunto era che i rendimenti sarebbero calati. Non puoi continuare a rendere tutto più grande e aspettarti miglioramenti proporzionali.

GPT-3 dimostrò che questo assunto era sbagliato.

Il modello mostrò un “apprendimento con pochi esempi” in modi che sorpresero persino i suoi creatori. Potevi dargli pochi esempi di un compito, e lui avrebbe capito lo schema senza alcun fine-tuning. Mostragli tre esempi di frasi inglesi tradotte in francese, e traduceva la quarta. Mostragli tre domande con risposte, e rispondeva alla quarta.

Quando OpenAI aprì l’API agli sviluppatori, le reazioni si divisero nettamente. Su Hacker News, l’utente denster catturò l’entusiasmo: “we were just blown away. Very cool!!”

Ma non tutti erano colpiti. L’utente Barrin92 ribatté: “All GPT-3 does is generate text…it doesn’t actually understand anything.”

Il CEO di OpenAI Sam Altman provò a moderare le aspettative. “The GPT-3 hype is way too much,” scrisse. “It’s impressive but it still has serious weaknesses.”

Aveva ragione sulle debolezze. Il modello allucinava con sicurezza. Non sapeva fare aritmetica di base in modo affidabile. Non aveva memoria persistente tra una sessione e l’altra. A volte generava contenuti tossici o distorti.

Ma la scommessa sulla scala aveva pagato. Modelli più grandi erano modelli più intelligenti. Questa intuizione avrebbe guidato i tre anni successivi di sviluppo dell’IA e miliardi di dollari di investimenti.

L’ingrediente mancante: renderlo usabile

GPT-3 esistette per due anni e mezzo prima del lancio di ChatGPT. Il modello sottostante non era drammaticamente diverso. Ciò che cambiò fu l’interfaccia.

GPT-3 richiedeva una chiave API. Dovevi sapere cos’era un prompt. Dovevi capire che il modello aveva bisogno di contesto ed esempi per funzionare bene. La barriera d’ingresso era reale.

ChatGPT eliminò tutto questo. Gratis. Conversazionale. Ottimizzato tramite apprendimento per rinforzo da feedback umano per essere utile e non dannoso. Tu scrivevi e lui rispondeva.

Cinque giorni dopo il lancio, un milione di utenti. Due mesi dopo, cento milioni. Nulla nella tecnologia consumer era mai cresciuto così in fretta.

Il modello che le persone potevano davvero usare cambiò tutto su come la gente pensava all’IA. Prima di ChatGPT, l’IA era qualcosa con cui lavoravano gli specialisti. Dopo ChatGPT, era qualcosa di cui tua zia ti chiedeva al Ringraziamento.

Questo conta per capire GPT-4. Il salto tecnologico fu reale, ma il salto nell’adozione arrivò dal rendere l’IA avanzata accessibile alle persone comuni, non solo dalla capacità grezza.

GPT-4: il salto che ha dato ragione

OpenAI annunciò GPT-4 il 14 marzo 2023. Il modello poteva ora elaborare immagini insieme al testo. Potevi caricare una foto e fare domande. Potevi mostrargli un diagramma e chiedere una spiegazione.

I miglioramenti di capacità furono sostanziali. GPT-4 superò l’esame di abilitazione forense con un punteggio nel 90º percentile. GPT-3.5 era nel 10º percentile. Non è un miglioramento incrementale. È un cambiamento qualitativo di capacità.

Su Hacker News, l’utente hooande notò ciò che entusiasmava gli sviluppatori: “The ability to dump 32k tokens into a prompt (25.000 words) seems like it will drastically expand the reasoning capability.”

L’adozione in azienda accelerò subito. Stripe integrò GPT-4 per riassumere siti web aziendali per il supporto clienti. Duolingo lo inserì in un nuovo livello di abbonamento. Morgan Stanley creò un sistema per servire gli analisti finanziari. Khan Academy sviluppò un tutor automatizzato.

La capacità multimodale era davvero nuova. I modelli linguistici precedenti elaboravano solo testo. GPT-4 poteva guardare una fotografia e descrivere cosa stava accadendo, identificare oggetti, leggere testo nelle immagini e ragionare su relazioni visive.

OpenAI trattenne dettagli tecnici sull’architettura e sui dati di addestramento di GPT-4. L’azienda che un tempo temeva che GPT-2 fosse troppo pericoloso da rilasciare era diventata molto più segreta su una tecnologia molto più potente. L’ironia non sfuggì agli osservatori.

Cosa è cambiato davvero tra le versioni

La progressione da GPT-1 a GPT-4 comportò tre cambiamenti fondamentali.

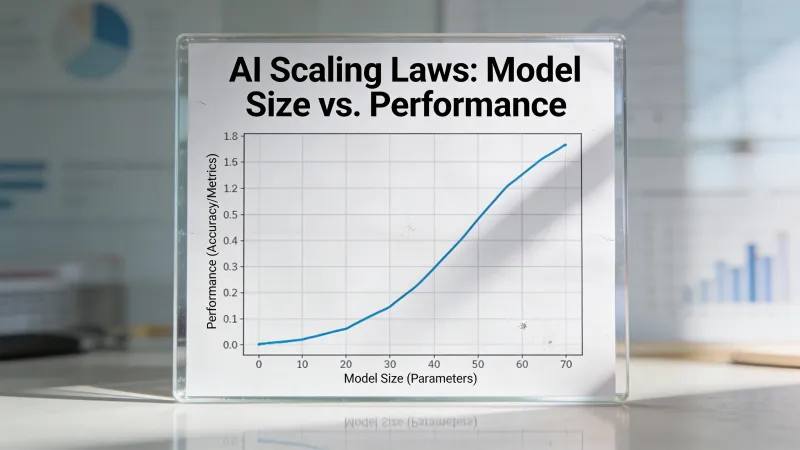

Scala. GPT-1 aveva 117 milioni di parametri. Il numero di parametri di GPT-4 non è mai stato confermato ufficialmente, ma stime credibili lo collocano oltre un trilione. È un aumento di circa diecimila volte in sei anni. Ogni salto di scala produsse capacità che non si potevano prevedere a partire da modelli più piccoli.

Dati di addestramento. GPT-1 si addestrò su libri. GPT-3 aggiunse Common Crawl, un’enorme raccolta del web. I dati di addestramento di GPT-4 restano non divulgati, ma il modello mostra conoscenze che possono arrivare solo da un’esposizione estesa a codice, paper accademici e domini specializzati.

Tecniche di allineamento. I modelli linguistici grezzi ottimizzano per la previsione. Generano qualunque testo sembri statisticamente probabile dato il prompt. L’apprendimento per rinforzo da feedback umano, introdotto tra GPT-3 e ChatGPT, insegnò ai modelli a ottimizzare invece per utilità e non dannosità. Questo rese la tecnologia utilizzabile da persone comuni che non avevano idea di come scrivere prompt.

I cambiamenti architetturali furono meno drastici di quanto si pensi spesso. GPT-4 usa ancora i Transformer. Il meccanismo di attenzione è riconoscibile dal paper del 2017 che ha avviato tutto. La rivoluzione venne da scala, dati e metodologia di addestramento, non da innovazioni architetturali fondamentali.

I numeri raccontano la storia

Ecco cosa sapeva fare ogni versione, misurato dai benchmark che contano:

GPT-1 fece 72.8 su GLUE. Superò il record precedente di 68.9. Progresso reale. Non trasformativo.

GPT-2 generava testo abbastanza coerente da ingannare lettori casuali. Non riusciva a seguire istruzioni in modo affidabile né a mantenere il contesto in conversazioni lunghe.

GPT-3 introdusse l’apprendimento con pochi esempi. Dagli esempi e capisce lo schema. Fu la prima versione che sembrò davvero utile per lavoro vero, anche se gli output richiedevano pesanti revisioni.

GPT-4 superò esami professionali. Esame di abilitazione: 90º percentile. GRE verbale: 90º percentile. Esami AP in più materie: punteggi di superamento. Fu la prima versione che superò con costanza l’essere umano medio su benchmark cognitivi.

Il divario tra “ricerca interessante” e “strumento utile” si è creato da qualche parte tra GPT-2 e GPT-3. Il divario tra “strumento utile” e “potenziale sostituto di parte del lavoro cognitivo umano” si è creato da qualche parte tra GPT-3 e GPT-4.

Perché GPT-2 fa più notizia di GPT-1

Nota che GPT-1 è quasi assente nella maggior parte delle ricostruzioni. Nessuno dibatte se GPT-1 avrebbe dovuto essere rilasciato. Nessuno ricorda cosa pensasse la prima volta che vide gli output di GPT-1.

GPT-2 è diverso. L’inquadramento del “troppo pericoloso” creò una narrativa. La gente aveva opinioni. La polemica generò copertura che il solo risultato tecnico non avrebbe ottenuto.

Questo conta perché rivela qualcosa su come la tecnologia entra nella coscienza pubblica. GPT-1 fu importante per ciò che dimostrò tecnicamente. GPT-2 fu importante per il dibattito che avviò. GPT-3 fu importante perché era utile. GPT-4 fu importante perché era abbastanza buono da far iniziare le persone a preoccuparsi dei lavori.

Ogni versione contò per ragioni diverse. Capire queste ragioni ti aiuta a capire cosa guida davvero l’adozione dell’IA e le preoccupazioni.

Lo schema che vale la pena capire

Ogni versione di GPT seguì un andamento. La capacità tecnica saltò. La reazione pubblica si divise tra entusiasmo e scetticismo. I danni previsti o non si materializzarono oppure si materializzarono in modi inattesi. Emersero applicazioni reali che nessuno aveva anticipato.

Le paure di fake news attorno a GPT-2 oggi sembrano quasi tenere. Il modello che era “troppo pericoloso da rilasciare” è superato con facilità da sistemi a cui chiunque può accedere gratis.

Le opinioni del tipo “GPT-3 non è poi così impressionante” sono invecchiate male. Il modello che alcuni liquidavano come autocompletamento glorificato è diventato la base per prodotti che centinaia di milioni di persone usano ogni giorno.

Le preoccupazioni su GPT-4 sono ancora irrisolte. Se rappresenti un progresso verso un’IA benefica o un passo verso sistemi che non possiamo controllare dipende da chi lo chiedi e dall’orizzonte temporale che consideri.

Quello che sembra chiaro è che ogni versione ha reso l’IA più capace e più accessibile. La tecnologia che nel 2018 iniziò come curiosità di ricerca oggi è incorporata nel modo in cui milioni di persone lavorano. Il divario tra GPT-1 e GPT-4 è il divario tra una prova di concetto accademica e un’infrastruttura da cui le organizzazioni dipendono.

Cosa viene dopo

Capire questa progressione conta perché continua. GPT-5 esiste. I modelli concorrenti di Anthropic, Google e Meta hanno spinto le capacità ancora più avanti. Il ritmo di miglioramento non mostra segnali di rallentamento.

La storia suggerisce che scommettere contro i miglioramenti di capacità è poco saggio. La storia suggerisce anche che gli impatti, sia positivi sia negativi, saranno diversi dalle previsioni.

L’unica previsione che ha tenuto con costanza: la prossima versione sarà migliore della precedente. Quanto migliore, e cosa significhi per come lavoriamo e viviamo, resta davvero sconosciuto.

Sei anni ci hanno portati da un paper che nessuno leggeva a una tecnologia che il 10% degli adulti usa ogni settimana. I prossimi sei anni probabilmente porteranno cambiamenti altrettanto drastici. Capire da dove veniamo è la miglior preparazione per capire dove stiamo andando.