A gennaio 2020, un team di OpenAI ha pubblicato un paper dal titolo asciutto: “Scaling Laws for Neural Language Models.” Il paper era denso di equazioni e grafici che la maggior parte delle persone non leggerebbe mai.

Ma le implicazioni erano sconvolgenti.

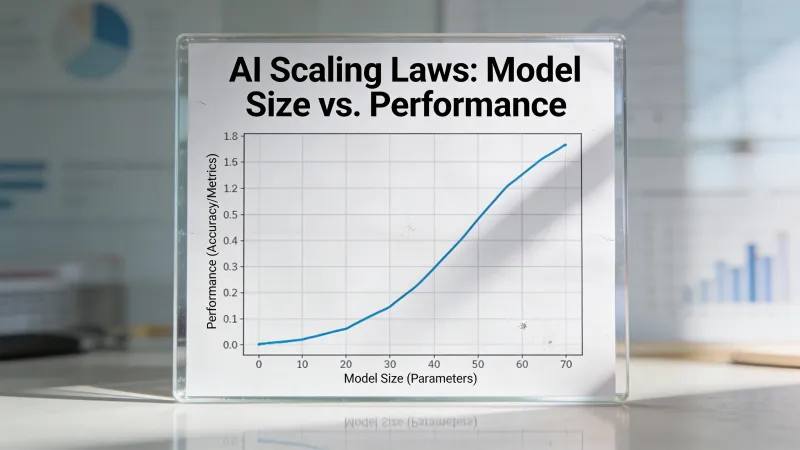

I ricercatori, guidati da Jared Kaplan, avevano scoperto qualcosa che sembrava quasi troppo pulito per essere vero: le prestazioni dell’IA seguono schemi matematici che reggono su sette ordini di grandezza. Non correlazioni grossolane. Non tendenze approssimative. Leggi di potenza con curve prevedibili.

Questa scoperta ha cambiato il modo in cui lavorano i laboratori di IA, dove finiscono miliardi di dollari, e quali futuri sembrano possibili.

La scoperta centrale

Le prestazioni migliorano in modo prevedibile. In quella frase c’è un’affermazione enorme, che il paper di OpenAI del 2020 è riuscito a sostenere con un’enorme mole di esperimenti.

I ricercatori hanno addestrato decine di modelli linguistici di dimensioni diverse, su quantità diverse di dati, usando quantità diverse di potenza di calcolo. Poi hanno tracciato i risultati. Ne è uscita una famiglia di curve lisce che seguiva relazioni matematiche precise.

Secondo il paper originale di Kaplan et al., “the loss scales as a power-law with model size, dataset size, and the amount of compute used for training.” Questa relazione teneva su modelli che andavano da milioni a miliardi di parametri.

Raddoppi il budget di calcolo? L’errore di previsione del tuo modello scende di una quantità costante e prevedibile. Lo raddoppi di nuovo? Stesso miglioramento proporzionale. Le curve restavano lisce fino in cima.

Non è così che ci si aspettava funzionasse l’apprendimento automatico. La maggior parte immaginava rendimenti decrescenti, plateau, strapiombi improvvisi dove tutto smetteva di funzionare. Invece, i grafici mostravano un miglioramento implacabile e prevedibile.

Perché ha cambiato tutto

Prima delle leggi di scalabilità, addestrare un modello di IA di punta era come lanciare un razzo senza sapere se hai abbastanza carburante per andare in orbita, e non lo avresti scoperto finché non avessi finito una corsa di addestramento durata mesi e costata decine di milioni di dollari.

Dopo le leggi di scalabilità, i laboratori potevano prevedere i risultati.

Vuoi sapere più o meno quanto sarà capace il tuo prossimo modello? Guarda il tuo budget di calcolo e consulta le curve. Stai pianificando la raccolta dati? Le leggi ti dicono di quanto hai bisogno. Decidere se costruire un cluster più grande? Puoi stimare i guadagni in capacità.

L’IA è diventata, in un certo senso, un problema di ingegneria più che un mistero scientifico. Non del tutto, non completamente, ma abbastanza da rendere gestibili scommesse da miliardi.

Le conseguenze si sono propagate. Le aziende potevano raccogliere capitali sulla base delle capacità previste dei modelli. I produttori di hardware potevano stimare la domanda. I ricercatori potevano pianificare roadmap pluriennali. Le leggi di scalabilità hanno dato a tutta l’industria un quadro di pianificazione che prima non esisteva.

La correzione Chinchilla

Le prime leggi di scalabilità non erano del tutto giuste.

Il paper di Kaplan suggeriva che la dimensione del modello contasse più della dimensione del dataset. Se hai calcolo limitato, investilo in un modello più grande. GPT-3, con i suoi 175 miliardi di parametri addestrati su “soli” 300 miliardi di token, rifletteva questa filosofia.

A marzo 2022, DeepMind ha pubblicato quello che è diventato noto come paper Chinchilla. Hanno addestrato oltre 400 modelli linguistici e hanno trovato qualcosa di diverso.

L’approccio ottimale era scalare insieme la dimensione del modello e i dati di addestramento, più o meno in proporzione. La loro conclusione: i modelli esistenti erano sotto-addestrati. Un modello più piccolo addestrato su più dati poteva superare un modello più grande addestrato su meno dati.

Chinchilla ha dimostrato il punto. Con 70 miliardi di parametri (meno della metà di GPT-3) addestrato su 1,4 trilioni di token (quasi cinque volte i dati di GPT-3), eguagliava o superava il modello molto più grande.

La nuova regola era circa 20 token per parametro per un addestramento ottimale in termini di calcolo. Questo rapporto è diventato un riferimento che ogni laboratorio di IA conosceva a memoria.

La realtà pratica della scala

Numeri come “175 miliardi di parametri” e “1,4 trilioni di token” sono difficili da visualizzare. Rendiamoli concreti.

Addestrare GPT-3 ha richiesto circa 3.14 x 10^23 operazioni in virgola mobile. Sono 314.000.000.000.000.000.000.000 calcoli individuali. La corsa di addestramento sarebbe costata tra 4 e 12 milioni di dollari solo in calcolo.

Il costo di addestramento di GPT-4 è stato stimato oltre i 100 milioni di dollari. I requisiti di calcolo crescono più velocemente dei miglioramenti nell’efficienza dell’hardware.

Questo crea una dinamica particolare nel settore. Su Hacker News, il commentatore bicepjai osservava: “as progress depends more on massive training runs, it becomes capital-intensive, less reproducible and more secretive; so you get a compute divide and less publication.”

I requisiti di capitale filtrano chi può partecipare. Un laboratorio universitario non può competere sulla scala pura con un’azienda che può spendere 100 milioni di dollari per una singola corsa di addestramento. Le leggi di scalabilità hanno creato un mondo in cui il progresso richiede risorse che pochi possiedono.

Cosa dicono le leggi (e cosa non dicono)

Le leggi di scalabilità ti dicono che la loss diminuisce in modo prevedibile. La loss, in questo contesto, è quanto il modello sbaglia quando predice la parola successiva. Una loss più bassa significa previsioni migliori.

Ma ecco cosa non ti dicono le leggi: cosa il modello sappia davvero fare.

Il rapporto tra loss e capacità è complesso. Un modello può migliorare a piccoli passi nel predire testo e poi, all’improvviso, acquisire la capacità di risolvere problemi di matematica che prima non risolveva. Queste capacità emergenti sono comparse a soglie di scala specifiche che le leggi non prevedevano.

Il few-shot learning, in cui un modello impara nuovi compiti da una manciata di esempi, è emerso intorno al traguardo dei 100 miliardi di parametri. Il ragionamento chain-of-thought è apparso su scale simili. Queste capacità non erano semplici miglioramenti quantitativi di abilità già esistenti. Erano qualitativamente nuove.

Le leggi di scalabilità descrivono una curva liscia. La realtà ha mostrato salti improvvisi.

Il problema di ricerca aperto

Non tutti hanno celebrato il paradigma della scalabilità.

Su Hacker News, il ricercatore gdiamos commentava: “I especially agree with your point that scaling laws really killed open research. That’s a shame and I personally think we could benefit from more research.”

La preoccupazione è strutturale. Se il progresso richiede calcolo enorme, solo i laboratori ben finanziati possono fare progressi. Se solo i laboratori ben finanziati fanno progressi, la maggior parte dei ricercatori non può contribuire alla frontiera. I dipartimenti universitari di informatica, storicamente fonte di idee di rottura, vengono messi ai margini.

gdiamos continuava: “If scaling is predictable, then you don’t need to do most experiments at very large scale. However, that doesn’t seem to stop researchers from starting there.”

C’è qualcosa di ironico qui. Le leggi di scalabilità, in teoria, ti permettono di prevedere i risultati su larga scala a partire da esperimenti su scala ridotta. In pratica, gli incentivi spingono tutti verso la scala comunque. Non puoi pubblicare sulle capacità a livello GPT-5 se non hai risorse a livello GPT-5.

Oltre il pre-addestramento: nuove frontiere

Le leggi di scalabilità originali si concentravano sul pre-addestramento, la fase iniziale in cui un modello impara a predire testo. Ma la pipeline di sviluppo dell’IA ha più fasi.

Ricerche recenti hanno identificato almeno tre regimi distinti di scalabilità:

Scalabilità del pre-addestramento segue le leggi originali di Kaplan e Chinchilla. Modelli più grandi addestrati su più dati predicono il testo meglio.

Scalabilità del post-addestramento copre la messa a punto e l’allineamento. La relazione tra il calcolo speso sul feedback umano e il comportamento del modello segue schemi propri, distinti dal pre-addestramento.

Scalabilità in inferenza è la scoperta più recente. Il modello o1 di OpenAI ha dimostrato che lasciare che un modello “pensi più a lungo” in fase di inferenza migliora le prestazioni di ragionamento. Questo suggerisce un’altra dimensione in cui più calcolo porta risultati migliori.

L’esistenza di più leggi di scalabilità implica percorsi di miglioramento continui anche se la scalabilità del pre-addestramento rallenta. Un modello può potenzialmente migliorare grazie a un post-addestramento più sofisticato o prendendosi più tempo per ragionare sui problemi.

Il muro dei dati

La correzione Chinchilla ha creato un nuovo problema.

Se l’addestramento ottimale richiede di scalare i dati insieme alla dimensione del modello, e i modelli di punta hanno già consumato gran parte del testo di alta qualità su internet, da dove arriva il prossimo dataset di addestramento?

Le stime suggeriscono che il web indicizzato contenga circa 510 trilioni di token. Sembra tantissimo finché non consideri che gran parte è di bassa qualità, ripetitivo o pura spazzatura. Il testo di qualità più alta, quello che insegna davvero a un modello a ragionare bene, è una piccola frazione.

Gli approcci attuali al muro dei dati includono:

Dati sintetici: far generare all’IA dati di addestramento per la prossima generazione di IA. Funziona fino a un certo punto, ma porta rischi di collasso del modello se lo fai senza attenzione.

Espansione multimodale: addestrare su immagini, video e audio insieme al testo apre nuove fonti di dati. Il mondo contiene molte più informazioni visive che testo scritto.

Curazione di qualità più alta: forse il problema non è la quantità ma la qualità. Filtri migliori potrebbero estrarre più segnale di apprendimento dai dati esistenti.

Creazione di nuovi dati: pare che alcuni laboratori stiano pagando per o creando contenuti proprietari appositamente per l’addestramento.

Nessuno di questi risolve chiaramente il problema. Il muro dei dati resta uno dei vincoli centrali sulla scalabilità continua.

Il dibattito sui rendimenti decrescenti

Alla fine del 2024 e nel 2025, sono emerse notizie secondo cui i miglioramenti dei modelli di punta stavano rallentando. Gli ultimi modelli non facevano più salti in avanti così drammatici come le generazioni precedenti.

Alcuni lo hanno interpretato come la morte della scalabilità. La festa era finita. Le leggi avevano fatto il loro corso.

Altri hanno fatto notare che le leggi di scalabilità originali prevedevano rendimenti decrescenti fin dall’inizio. Le curve sono logaritmiche, non esponenziali. Ogni raddoppio del calcolo compra un miglioramento assoluto più piccolo del precedente. Era sempre stato questo il pattern atteso.

Il dibattito ruota attorno a una domanda a cui nessuno può rispondere in modo definitivo: stiamo vedendo il rallentamento previsto da un miglioramento logaritmico, o un tetto fondamentale a ciò che la scalabilità può ottenere?

Osservatori diversi leggono gli stessi dati in modo diverso. Il progresso continua, ma a quale ritmo? E quel ritmo è sufficiente per le capacità che le persone vogliono?

Previsioni che hanno retto e previsioni che non hanno retto

Le leggi di scalabilità hanno fatto previsioni specifiche. Alcune hanno retto. Altre no.

Hanno retto: la relazione di base tra calcolo e loss è rimasta sorprendentemente coerente tra architetture e approcci diversi. Le curve fondamentali funzionano.

Hanno retto in parte: il rapporto ottimale di Chinchilla si è rivelato ottimale per l’efficienza di addestramento ma non per l’efficienza in produzione. Modelli moderni come Llama 3 si addestrano su 200 token per parametro, ben oltre l’ottimo di Chinchilla, perché i costi di inferenza contano più dei costi di addestramento per prodotti usati su larga scala.

Non hanno retto: la previsione del paper originale di Kaplan secondo cui la dimensione del modello contasse più della dimensione dei dati era semplicemente sbagliata. Chinchilla lo ha dimostrato in modo decisivo.

Non è chiaro: se la scalabilità continui a produrre capacità utili oltre le scale attuali resta irrisolto. Le leggi prevedono una riduzione continua della loss, ma non se quella riduzione si traduca in capacità a cui gli esseri umani tengono.

Cosa la scalabilità non può dirti

Le leggi di scalabilità tacciono su diverse domande critiche.

Non ti dicono se un modello allucinerà. Ridurre la loss non garantisce accuratezza fattuale.

Non ti dicono se un modello sarà sicuro o allineato ai valori umani. Un modello può predire testo molto bene ed essere utile, innocuo o pericoloso.

Non ti dicono se un modello sarà bravo in un compito specifico. Ridurre la loss in generale non garantisce prestazioni sul problema particolare che ti interessa.

Non ti dicono quando emergeranno capacità qualitativamente nuove. Le leggi descrivono curve lisce, ma le capacità appaiono in modo discontinuo.

Questi buchi contano. Significa che anche con una conoscenza perfetta delle leggi di scalabilità, non puoi prevedere fino in fondo com’è un modello. Le leggi vincolano lo spazio delle possibilità senza determinarlo.

L’enigma filosofico

C’è qualcosa di filosoficamente strano nelle leggi di scalabilità.

Perché la previsione linguistica dovrebbe seguire schemi matematici così puliti? I dati di addestramento sono un’istantanea disordinata e incoerente della scrittura umana. L’architettura è una serie di scelte ingegneristiche. Il processo di ottimizzazione è stocastico. Eppure, il risultato segue leggi di potenza su sette ordini di grandezza.

Alcuni lo vedono come prova che l’intelligenza abbia una struttura matematica in attesa di essere scoperta. Altri lo vedono come una coincidenza sospetta che potrebbe non reggere per sempre. Altri ancora sostengono che rifletta semplicemente le proprietà statistiche del linguaggio stesso.

Le leggi di scalabilità funzionano. Perché funzionino resta davvero poco chiaro.

Dove ci lascia tutto questo

Le leggi di scalabilità hanno dato all’industria dell’IA qualcosa di cui aveva disperatamente bisogno: un quadro di pianificazione. Hanno abilitato investimenti da miliardi, roadmap pluriennali e previsioni fiduciose sulle capacità future.

Ma i quadri possono diventare prigioni.

L’ossessione per la scalabilità potrebbe aver messo in ombra altri approcci. Il calcolo massiccio è diventato la soluzione predefinita anche quando esperimenti più piccoli avrebbero potuto rispondere alle stesse domande. La ricerca accademica è stata marginalizzata. Le architetture alternative hanno ricevuto meno attenzione.

Ora, mentre la scalabilità del pre-addestramento mostra segni di tensione, l’industria sta scoprendo altre strade. Scalabilità in inferenza. Dati sintetici. Algoritmi di addestramento migliori. Ottimizzazione post-addestramento. Questi approcci sono sempre esistiti, ma vivevano all’ombra della scalabilità.

Le leggi di scalabilità sono state una scoperta su come funziona l’IA. Sono state anche una scelta su come inseguire il progresso. Se quella scelta fosse ottimale, se oggi saremmo più avanti con approcci più diversi, è una domanda a cui nessuno può rispondere con certezza.

Quello che sappiamo: le curve continuano a scendere. Il calcolo continua ad aiutare. Le leggi continuano a reggere, anche se i guadagni diventano più difficili da catturare.

La prossima svolta potrebbe arrivare da più scala, o da qualcos’altro del tutto.