Passei três horas na semana passada escrevendo o prompt perfeito. Todo caso-limite coberto. Toda regra de formatação especificada. Doze parágrafos de instruções detalhadas para um simples modelo de e-mail.

O resultado foi pior do que um prompt de duas frases que eu tinha montado no dia anterior.

Isso acontece mais do que as pessoas admitem. A gente assume que mais detalhes significam uma saída melhor, que prompts mais longos demonstram mais expertise, que a minúcia sempre vence. Às vezes vence. Mas às vezes todo esse cuidado só confunde o modelo ou infla sua conta da API sem nenhum ganho.

A pergunta de verdade não é qual abordagem é a “certa”. É saber quando cada uma realmente ajuda.

O paradoxo do tamanho

É isso que a pesquisa segue encontrando: o tamanho do prompt e a qualidade da saída têm uma relação complicada.

Uma discussão no Hacker News sobre engenharia de prompts captou bem essa tensão. Pesquisadores tentando entender a conexão entre tamanho e desempenho descobriram algo contraintuitivo: “Prompt length would play a big factor in the performance of this approach. In practice, though, we discovered that it’s actually not as big a factor as we predicted.”

Um prompt de 410 tokens e um de 57 tokens tiveram um desempenho razoavelmente bom nos testes. Um prompt de 88 tokens foi pior. Só o tamanho não explicava quase nada.

O que realmente importava? Precisão. Os mesmos pesquisadores concluíram que “the relationship between performance of the estimation and the prompt structure is less about length, and more about ‘ambiguity.’” Formulações abertas pioravam os resultados, independentemente da contagem de palavras.

Isso bate com o que quem usa no dia a dia segue descobrindo. Segundo a análise de Ruben Hassid, “Prompts exceeding 500 words generally show diminishing returns in terms of output quality.” E piora quanto mais você estica: “For every 100 words added beyond the 500-word threshold, the model’s comprehension can drop by 12%.”

Esses números variam por modelo e por tarefa. Mas o princípio se mantém.

Como são, de verdade, os prompts longos

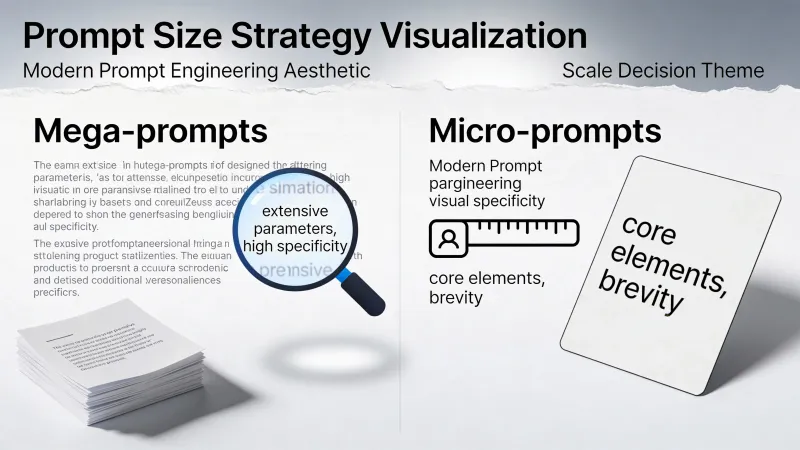

Andrew Ng e sua equipe na DeepLearning.AI chamam prompts detalhados de “mega-prompts.” Segundo a pesquisa deles sobre sofisticação de prompts, são instruções com “1 to 2 pages long” e orientação explícita cobrindo cada aspecto da tarefa.

Ng diz que a maioria das equipes ainda não vai longe o suficiente: “I still see teams not going far enough in terms of writing detailed instructions.”

Um mega-prompt bem feito pode incluir:

- Definição específica de papel e expertise

- Contexto de fundo sobre a situação

- Vários exemplos da saída desejada

- Regras explícitas de formatação

- Restrições e coisas a evitar

- Critérios de qualidade para a resposta

Aqui está como um deles fica na prática:

Você é um redator B2B sênior especializado em software corporativo.

Seu leitor-alvo é um VP de Marketing de uma empresa de médio porte que

já se queimou com fornecedores de IA que prometeram demais.

Escreva texto de produto para a DataSync, uma plataforma de integração de dados.

Diferencial principal: somos honestos sobre limitações. Nossa ferramenta

faz 80% das integrações perfeitamente, e somos transparentes sobre

os 20% que exigem trabalho sob medida.

Requisitos:

- Título com menos de 12 palavras, focado no benefício

- Subtítulo que reconheça o ceticismo do nosso público

- Três tópicos sobre capacidades

- Um tópico sobre limitações conhecidas (isso gera confiança)

- CTA focado em ver funcionando, não em comprar

Tom: confiante, mas nunca exagerado. Sem "revolucionar" ou "transformar".Esse prompt deixa pouco ao acaso. A IA sabe exatamente o que se espera.

Como são, de verdade, os prompts curtos

Do outro lado está o micro-prompt. Curto. Focado. Uma tarefa de cada vez.

Escreva um título para uma plataforma de integração de dados honesta. No máximo 10 palavras.Mesma tarefa geral. Uma fração das palavras. A IA preenche todo o resto com padrões razoáveis.

Um desenvolvedor no Hacker News descreveu sua evolução rumo à brevidade: “I’ve stopped writing well-formed requests/questions and now I just state things like: ‘sed to replace line in a text file?’”

Mesmo com a entrada seca, o modelo ainda entregou respostas úteis. Nem toda tarefa precisa de andaimes elaborados.

O custo escondido

Tem uma coisa que quase ninguém menciona quando discute tamanho de prompt: cada token custa dinheiro.

Usando os preços atuais da API da OpenAI, o GPT-4o cobra $2.50 por milhão de tokens de entrada e $10.00 por milhão de tokens de saída. Para uma requisição, parece troco. Agora escala isso.

Um prompt de 500 palavras dá mais ou menos 650 tokens. Um prompt de 50 palavras dá mais ou menos 65 tokens. Se você faz 10.000 chamadas de API por dia, a diferença entre mega e micro soma rápido:

- Prompts de 650 tokens: 6.5 milhões de tokens = $16.25/dia em custos de entrada

- Prompts de 65 tokens: 650.000 tokens = $1.63/dia em custos de entrada

Isso dá quase $5.300 por ano de economia só em tokens de entrada. E isso sem contar a saída maior que prompts detalhados costumam disparar.

E ainda tem a latência. Prompts mais longos demoram mais para serem processados. Se sua aplicação precisa responder rápido, aquele prompt de sistema de 500 palavras cria um atraso perceptível em toda requisição.

Para processamento em lote ou prompts de uso único, o custo pesa menos. Para sistemas em produção que fazem milhares de requisições, pesa demais.

Quando detalhe atrapalha de verdade

A suposição de que “mais é melhor” quebra de formas específicas e previsíveis.

Primeiro, tem o problema do perdido no meio. A análise de Ruben Hassid sobre tamanho de prompt diz isso na lata: “The single greatest threat to output quality is prompt bloat.” Quando os prompts ficam longos, informações no meio tendem a ser ignoradas. Requisitos críticos enterrados no oitavo parágrafo podem muito bem não existir.

Segundo, contradições aparecem. Escreva instruções suficientes e você inevitavelmente vai dizer “seja conciso, mas completo” ou “seja criativo, mas siga exatamente este formato”. O modelo não consegue satisfazer os dois. Ele escolhe um e ignora o outro, ou entrega uma saída confusa tentando ficar no meio do caminho.

Terceiro, tem a sobrecarga cognitiva. Um praticante em um fio do Hacker News sobre playbooks de prompts descreveu a experiência dele: “Sometimes I get the feeling that making super long and intricate prompts reduces the cognitive performance of the model.”

A solução? “My usage has converged to making very simple and minimalistic prompts and doing minor adjustments after a few iterations.”

O modelo não é um colega humano que “aprecia contexto”. É um reconhecedor de padrões. Padrões demais para casar significa casamento pior no geral.

Quando detalhe ajuda de verdade

Nada disso significa que mega-prompts estão errados. Eles resolvem problemas reais.

Quando a saída vai direto para clientes sem revisão, você precisa de controle. Um prompt solto que de vez em quando produz um texto fora do tom até serve para rascunhos. É desastroso para campanhas de e-mail automatizadas.

Quando você vai reutilizar o prompt centenas de vezes, o investimento compensa. Gastar duas horas aperfeiçoando um prompt que você vai rodar 5.000 vezes é matemática boa. Gastar duas horas em um pedido único não é.

Quando várias partes precisam de coerência, um prompt vence vários. Uma landing page precisa de título, subtítulo, corpo e CTA que funcionem juntos. Micro-prompts separados podem ser bons individualmente, mas bater cabeça quando você junta tudo.

Outro desenvolvedor no mesmo fio do Hacker News compartilhou a abordagem dele: “Some of my best system prompts are >20 lines of text, and all of them are necessary.”

O método dele para construir esses prompts dizia muito: “every time the model does something undesired, even minor I add an explicit rule in the system prompt to handle it.” O tamanho veio de necessidades reais, não de uma obsessão teórica por completude.

Essa é a distinção-chave. Prompts longos que crescem organicamente a partir de falhas reais funcionam. Prompts longos escritos para cobrir casos-limite hipotéticos normalmente só adicionam ruído.

A alternativa em cadeia

Existe um caminho do meio que evita a armadilha do mega-prompt, sem abrir mão do controle que você precisa.

Paul Shirer argumenta na análise dele sobre estratégias de prompt que prompts em cadeia vencem mega-prompts na maioria das tarefas. O raciocínio dele: “You aren’t stuck with the result of a mega prompt that might have gone astray due to an overlooked detail.”

Em cadeias, cada passo é uma instrução curta e focada:

- “Gere cinco conceitos de títulos para este produto.”

- “Pegue o conceito nº 3 e escreva três variações.”

- “Agora escreva o texto de apoio para a melhor variação.”

- “Adicione um CTA que combine com o tom do título.”

Cada saída alimenta a próxima. Se o passo dois sai do trilho, você corrige antes do passo três, não depois de rodar o mega-prompt inteiro. Como Shirer coloca: prompts em cadeia funcionam como “inching closer with each shot, adjusting your aim according to where the last arrow landed.”

A troca é velocidade. Cadeias exigem várias idas e voltas. Para uso interativo, ok. Para processamento em lote de milhares de itens, o custo operacional se acumula.

Lendo os sinais

Como você sabe se o seu prompt está longo demais ou curto demais?

Longo demais:

- A saída ignora instruções que você incluiu especificamente

- Você repete o mesmo ponto com palavras diferentes

- Você se pega se contradizendo em seções anteriores

- A maioria das frases é “só por garantia”, em vez de essencial

- A IA parece confusa sobre o que você realmente quer

Curto demais:

- A saída fica genérica quando você precisava de específico

- As mesmas correções de follow-up toda vez

- Suposições erradas sobre público, tom ou formato

- Você vive adicionando “também inclua…” como pós-pensamento

O padrão para a maioria das tarefas: comece curto, adicione só o necessário com base em falhas reais, pare quando a saída estiver boa o suficiente.

Um framework que funciona

Esqueça a briga mega vs micro. Em vez disso, faça estas perguntas.

Quão importante é essa saída? Saídas críticas que vão direto para produção justificam prompts mais detalhados. Rascunhos e explorações não precisam disso.

Quão reutilizável é esse prompt? Vinte usos justificam trinta minutos de escrita. Um uso justifica dois minutos.

Você pode iterar? Se dá para rodar de novo com ajustes, comece curto. Se é um trabalho em lote que precisa funcionar de primeira, antecipe os detalhes.

Qual é o contexto de custo? Uso alto de API significa que cada token importa. Em uma única requisição, a diferença é insignificante.

Você sabe exatamente o que quer? Certeza favorece prompts detalhados. Exploração favorece prompts curtos com iteração rápida.

O teste de relevância

A regra mais simples possível: olhe para cada frase do seu prompt e pergunte se removê-la mudaria a saída.

Se sim, mantenha. Contexto relevante melhora resultados.

Se não, corte. Enchimento irrelevante só dilui a atenção.

Um praticante em uma discussão sobre engenharia de prompts resumiu isso perfeitamente: “Irrelevant context is worse than no context, but it doesn’t mean a long prompt of relevant context is bad.”

Essa distinção importa mais do que qualquer guideline de contagem de palavras. Um prompt de 50 palavras cheio de enrolação funciona pior do que um de 300 palavras em que cada palavra merece estar ali. Um prompt de 300 palavras cheio de preenchimento funciona pior do que um de 50 palavras bem focado.

Meça por relevância, não por tamanho.

O que realmente muda o comportamento

Os prompts mais eficazes compartilham uma qualidade que não tem nada a ver com tamanho. Eles reduzem ambiguidade.

“Escreva algo bom” é curto, mas inútil. “Escreva uma descrição de produto de 100 palavras para uma garrafa de água de aço inoxidável, voltada para entusiastas de atividades ao ar livre, enfatizando durabilidade” é mais longo, mas cada palavra tem uma função.

A pesquisa confirma isso. Voltando àquela análise no Hacker News, o insight central foi que engenharia de prompts é sobre precisão linguística: “say what you mean in the most linguistically precise way possible.”

Não mais palavras. Nem menos palavras. As palavras certas.

Algumas tarefas precisam de muitas palavras certas. Outras precisam de poucas. A habilidade não é escolher um lado na briga mega vs micro. É aprender a escrever exatamente o suficiente para cada situação, e reconhecer em qual situação você realmente está.

Comece com o que a tarefa precisa. Adicione o que as suas falhas te ensinam. Pare quando a saída estiver boa o suficiente. O tamanho de prompt que sobra é o tamanho que era o certo.