Im Januar 2020 veröffentlichte ein Team bei OpenAI eine Arbeit mit einem spröden Titel: “Scaling Laws for Neural Language Models.” Das Paper selbst war vollgepackt mit Gleichungen und Diagrammen, die die meisten Menschen nie lesen würden.

Aber die Konsequenzen waren enorm.

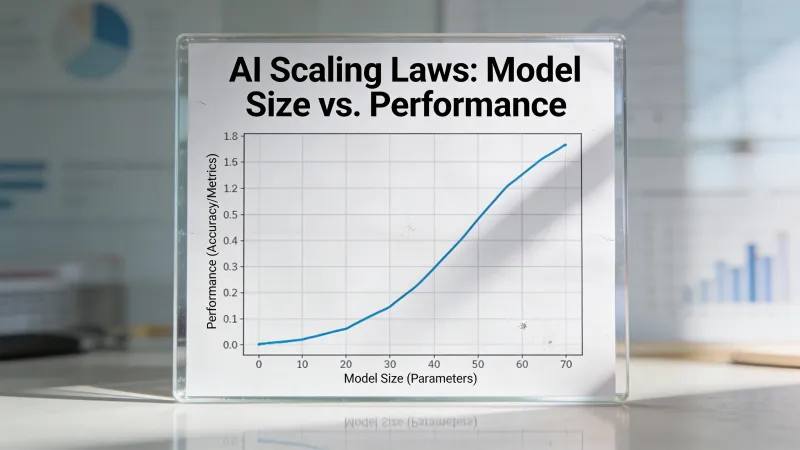

Die Forschenden um Jared Kaplan hatten etwas entdeckt, das fast zu sauber wirkte, um wahr zu sein: KI-Leistung folgt mathematischen Mustern, die über sieben Größenordnungen hinweg gelten. Keine groben Korrelationen. Keine ungefähren Trends. Potenzgesetze mit vorhersagbaren Kurven.

Diese Entdeckung veränderte, wie KI-Labore arbeiten, wohin Milliarden fließen und welche Zukünfte überhaupt plausibel wirken.

Das Kernergebnis

Leistung verbessert sich vorhersagbar. In diesem Satz steckt eine außergewöhnliche Behauptung, die das OpenAI-Paper von 2020 mit umfangreichen Experimenten untermauern konnte.

Die Forschenden trainierten Dutzende Sprachmodelle in unterschiedlichen Größen, mit unterschiedlichen Datenmengen und mit unterschiedlich viel Rechenleistung. Dann trugen sie die Ergebnisse auf. Was herauskam, war eine Familie glatter Kurven, die präzisen mathematischen Beziehungen folgten.

According to the original Kaplan et al. paper, “the loss scales as a power-law with model size, dataset size, and the amount of compute used for training.” Diese Beziehung hielt über Modelle hinweg, von Millionen bis Milliarden Parametern.

Du verdoppelst dein Rechenbudget? Der Vorhersagefehler deines Modells sinkt um einen konstanten, vorhersagbaren Betrag. Du verdoppelst noch einmal? Gleiche proportionale Verbesserung. Die Kurven blieben bis ganz nach oben glatt.

So hatte niemand erwartet, dass maschinelles Lernen funktioniert. Die meisten gingen von abnehmendem Nutzen aus, von Plateaus, von unerwarteten Klippen, an denen plötzlich nichts mehr geht. Stattdessen zeigten die Grafiken unnachgiebige, vorhersagbare Verbesserung.

Warum das alles verändert hat

Vor den Skalierungsgesetzen war das Training eines Spitzen-KI-Modells wie ein Raketenstart, ohne zu wissen, ob du genug Treibstoff für den Orbit hast – und du würdest es erst am Ende eines monatelangen Trainingslaufs erfahren, der zig Millionen Dollar kostet.

Nach den Skalierungsgesetzen konnten Labore Ergebnisse vorhersagen.

Willst du ungefähr wissen, wie leistungsfähig dein nächstes Modell sein wird? Schau auf dein Rechenbudget und konsultiere die Kurven. Planst du deine Datensammlung? Die Gesetze sagen dir, wie viel du brauchst. Entscheidest du, ob du einen größeren Cluster baust? Du kannst den Fähigkeitsgewinn abschätzen.

KI wurde in gewisser Weise zu einem Ingenieurproblem statt zu einem wissenschaftlichen Rätsel. Nicht vollständig, nicht komplett – aber genug, um Wetten in Milliardenhöhe handhabbar wirken zu lassen.

Die Folgen breiteten sich nach außen aus. Unternehmen konnten nun Geld einsammeln auf Basis projizierter Modellfähigkeiten. Hardwarehersteller konnten Nachfrage abschätzen. Forschende konnten mehrjährige Fahrpläne planen. Die Skalierungsgesetze gaben der gesamten Branche ein Planungsgerüst, das sie vorher nie hatte.

Die Chinchilla-Korrektur

Die ersten Skalierungsgesetze waren nicht ganz richtig.

Das Kaplan-Paper legte nahe, dass Modellgröße wichtiger sei als Datensatzgröße. Wenn du begrenzte Rechenleistung hast, steck sie in ein größeres Modell. GPT-3 mit seinen 175 Milliarden Parametern, trainiert auf “nur” 300 Milliarden Tokens, spiegelte diese Philosophie wider.

Im März 2022 veröffentlichte DeepMind das, was als Chinchilla-Paper bekannt wurde. Sie trainierten über 400 Sprachmodelle – und fanden etwas anderes.

Der optimale Ansatz war, Modellgröße und Trainingsdaten gemeinsam zu skalieren, ungefähr proportional. Ihr Fazit: Bestehende Modelle waren untertrainiert. Ein kleineres Modell, trainiert auf mehr Daten, kann ein größeres Modell schlagen, das auf weniger Daten trainiert wurde.

Chinchilla selbst bewies den Punkt. Mit 70 Milliarden Parametern (weniger als die Hälfte von GPT-3) und trainiert auf 1,4 Billionen Tokens (fast fünfmal so viele Daten wie GPT-3) erreichte es das Niveau des viel größeren Modells oder übertraf es.

Die neue Faustregel lag bei ungefähr 20 Tokens pro Parameter für compute-optimales Training. Dieses Verhältnis wurde zu einem Maßstab, den jedes KI-Labor im Schlaf kannte.

Die praktische Realität von Größe

Zahlen wie “175 Milliarden Parameter” und “1,4 Billionen Tokens” sind schwer zu greifen. Ich mache sie konkret.

Das Training von GPT-3 erforderte ungefähr 3,14 x 10^23 Gleitkommaoperationen. Das sind 314.000.000.000.000.000.000.000 einzelne Berechnungen. Der Trainingslauf soll allein an Rechenleistung zwischen 4 und 12 Millionen Dollar gekostet haben.

Die Trainingskosten von GPT-4 wurden auf über 100 Millionen Dollar geschätzt. Der Rechenbedarf wächst schneller als die Verbesserung der Hardwareeffizienz.

Das erzeugt eine bestimmte Dynamik in der Branche. Auf Hacker News stellte der Kommentator bicepjai fest: “as progress depends more on massive training runs, it becomes capital-intensive, less reproducible and more secretive; so you get a compute divide and less publication.”

Die Kapitalanforderungen filtern, wer mitmachen kann. Ein Unilabor kann auf roher Größe nicht mit einem Unternehmen konkurrieren, das 100 Millionen Dollar für einen einzigen Trainingslauf ausgeben kann. Die Skalierungsgesetze schufen eine Welt, in der Fortschritt Ressourcen verlangt, die nur wenige besitzen.

Was die Gesetze sagen (und was nicht)

Die Skalierungsgesetze sagen dir, dass der Loss (Verlustwert) vorhersagbar sinkt. Loss bedeutet in diesem Kontext: wie falsch das Modell liegt, wenn es das nächste Wort vorhersagt. Niedrigerer Loss heißt bessere Vorhersagen.

Aber hier ist, was die Gesetze dir nicht sagen: was das Modell tatsächlich kann.

Die Beziehung zwischen Loss und Fähigkeiten ist komplex. Ein Modell kann sich schrittweise darin verbessern, Text vorherzusagen – und plötzlich die Fähigkeit gewinnen, Matheaufgaben zu lösen, die es vorher nicht lösen konnte. Solche “emergent capabilities” tauchten bei bestimmten Skalenschwellen auf, die die Gesetze nicht vorhersagten.

Few-shot learning – wenn ein Modell neue Aufgaben aus einer Handvoll Beispiele lernt – tauchte ungefähr bei 100 Milliarden Parametern auf. Gedankenkette (Chain-of-thought) zeigte sich bei ähnlichen Größenordnungen. Diese Fähigkeiten waren nicht nur quantitative Verbesserungen bestehender Fähigkeiten. Sie waren qualitativ neu.

Die Skalierungsgesetze beschreiben eine glatte Kurve. Die Realität zeigte plötzliche Sprünge.

Das offene Forschungsproblem

Nicht alle feierten das Skalierungsparadigma.

Auf Hacker News kommentierte der Forscher gdiamos: “I especially agree with your point that scaling laws really killed open research. That’s a shame and I personally think we could benefit from more research.”

Die Sorge ist strukturell. Wenn Fortschritt massive Rechenleistung erfordert, können nur gut finanzierte Labore Fortschritt an der Spitze machen. Wenn nur gut finanzierte Labore dort Fortschritt machen, können die meisten Forschenden nicht zur Spitze beitragen. Informatik-Fakultäten an Universitäten, historisch eine Quelle von Durchbrüchen, werden an den Rand gedrängt.

gdiamos fuhr fort: “If scaling is predictable, then you don’t need to do most experiments at very large scale. However, that doesn’t seem to stop researchers from starting there.”

Daran ist etwas Ironisches. Die Skalierungsgesetze sollen dir theoretisch erlauben, Ergebnisse im großen Maßstab aus Experimenten im kleinen Maßstab vorherzusagen. In der Praxis drücken die Anreize trotzdem alle Richtung Größe. Du kannst nichts über Fähigkeiten auf GPT-5-Skala veröffentlichen, wenn du keine Ressourcen auf GPT-5-Skala hast.

Jenseits des Vortrainings: neue Grenzen

Die ursprünglichen Skalierungsgesetze konzentrierten sich auf das Vortraining, die Anfangsphase, in der ein Modell lernt, Text vorherzusagen. Aber die KI-Entwicklung hat mehr Schritte.

Neuere Forschung hat mindestens drei verschiedene Skalierungsregime identifiziert:

Vortraining-Skalierung folgt den ursprünglichen Kaplan- und Chinchilla-Gesetzen. Größere Modelle, trainiert auf mehr Daten, sagen Text besser voraus.

Nachtraining-Skalierung umfasst Feinabstimmung und Ausrichtung. Die Beziehung zwischen Rechenaufwand für menschliches Feedback und Modellverhalten folgt eigenen Mustern, getrennt vom Vortraining.

Inferenz-Skalierung ist die neueste Entdeckung. OpenAIs o1-Modell zeigte, dass es die Leistung beim Schlussfolgern verbessert, wenn man ein Modell zur Inferenzzeit “länger denken” lässt. Das deutet auf eine weitere Dimension hin, in der mehr Rechenleistung bessere Ergebnisse bringt.

Dass es mehrere Skalierungsgesetze gibt, impliziert weitere Pfade für Verbesserungen – selbst wenn Vortraining-Skalierung langsamer wird. Ein Modell kann potenziell besser werden durch ausgefeilteres Nachtraining oder indem es sich mehr Zeit nimmt, Probleme zu durchdenken.

Die Datenwand

Die Chinchilla-Korrektur erzeugte ein neues Problem.

Wenn compute-optimales Training erfordert, Daten zusammen mit der Modellgröße zu skalieren, und heutige Spitzenmodelle bereits den Großteil hochwertigen Textes im Internet konsumiert haben: Woher kommt dann der nächste Trainingsdatensatz?

Schätzungen zufolge enthält das indexierte Web ungefähr 510 Billionen Tokens. Das klingt nach viel – bis man bedenkt, dass das meiste davon minderwertig, repetitiv oder schlicht Müll ist. Der hochwertigste Text, der einem Modell wirklich beibringt, gut zu schlussfolgern, ist nur ein kleiner Anteil.

Aktuelle Ansätze gegen die Datenwand sind:

Synthetische Daten: KI erzeugt Trainingsdaten für die nächste KI-Generation. Das funktioniert bis zu einem Punkt, birgt aber Risiken eines Modellkollapses, wenn man es sorglos macht.

Multimodale Ausweitung: Training auf Bildern, Video und Audio neben Text erschließt neue Datenquellen. Die Welt enthält weit mehr visuelle Information als geschriebenen Text.

Höherwertige Kuratierung: Vielleicht ist das Problem nicht Menge, sondern Qualität. Bessere Filterung könnte mehr Lernsignal aus bestehenden Daten ziehen.

Neue Datenerzeugung: Manche Labore sollen dafür zahlen oder proprietäre Inhalte gezielt für Training erzeugen.

Nichts davon löst das Problem eindeutig. Die Datenwand bleibt eine der zentralen Grenzen für weitere Skalierung.

Die Debatte um abnehmenden Nutzen

Ende 2024 und 2025 tauchten Berichte auf, dass sich Verbesserungen bei Spitzenmodellen verlangsamen. Die neuesten Modelle sprangen nicht mehr so dramatisch nach vorn wie frühere Generationen.

Manche deuteten das als Tod der Skalierung. Die Party war vorbei. Die Gesetze hätten sich erschöpft.

Andere hielten dagegen: Die ursprünglichen Skalierungsgesetze sagten abnehmenden Nutzen von Anfang an voraus. Die Kurven sind logarithmisch, nicht exponentiell. Jede Verdopplung von Rechenleistung bringt einen kleineren absoluten Fortschritt als die vorherige. Genau dieses Muster war immer zu erwarten.

Die Debatte hängt an einer Frage, die niemand endgültig beantworten kann: Sehen wir die erwartete Verlangsamung durch logarithmische Verbesserung – oder eine grundsätzliche Decke dessen, was Skalierung erreichen kann?

Verschiedene Beobachter lesen dieselben Daten unterschiedlich. Fortschritt geht weiter, aber in welchem Tempo? Und ist dieses Tempo ausreichend für die Fähigkeiten, die Menschen wollen?

Vorhersagen, die sich bestätigt haben – und nicht

Die Skalierungsgesetze machten konkrete Vorhersagen. Einige hielten stand. Andere nicht.

Bestätigt: Die Grundbeziehung zwischen Rechenleistung und Loss blieb über verschiedene Architekturen und Ansätze hinweg bemerkenswert stabil. Die fundamentalen Kurven funktionieren.

Teilweise bestätigt: Das Chinchilla-Optimale Verhältnis erwies sich als optimal für Trainingseffizienz, aber nicht für Bereitstellungseffizienz. Moderne Modelle wie Llama 3 trainieren mit 200 Tokens pro Parameter, weit jenseits des Chinchilla-Optimums, weil Inferenzkosten für Produkte in großem Maßstab wichtiger sind als Trainingskosten.

Nicht bestätigt: Die Vorhersage des ursprünglichen Kaplan-Papers, dass Modellgröße wichtiger sei als Datengröße, war schlicht falsch. Chinchilla zeigte das eindeutig.

Unklar: Ob Skalierung über heutige Größen hinaus weiterhin nützliche Fähigkeiten produziert, bleibt offen. Die Gesetze sagen weitere Loss-Senkung voraus, aber nicht, ob diese Loss-Senkung sich in Fähigkeiten übersetzt, die Menschen wichtig sind.

Was Skalierung dir nicht sagen kann

Die Skalierungsgesetze schweigen zu mehreren entscheidenden Fragen.

Sie sagen dir nicht, ob ein Modell halluzinieren wird. Weniger Loss garantiert keine faktische Genauigkeit.

Sie sagen dir nicht, ob ein Modell sicher ist oder mit menschlichen Werten ausgerichtet. Ein Modell kann Text sehr gut vorhersagen und dabei hilfreich, harmlos – oder gefährlich sein.

Sie sagen dir nicht, ob ein Modell in irgendeiner konkreten Aufgabe gut sein wird. Allgemeine Loss-Senkung garantiert keine Leistung bei genau dem Problem, das dich interessiert.

Sie sagen dir nicht, wann qualitativ neue Fähigkeiten auftauchen. Die Gesetze beschreiben glatte Kurven, aber Fähigkeiten erscheinen sprunghaft.

Diese Lücken sind wichtig. Sie bedeuten: Selbst mit perfektem Wissen über Skalierungsgesetze kannst du nicht vollständig vorhersagen, wie ein Modell sein wird. Die Gesetze begrenzen den Möglichkeitsraum, ohne ihn festzulegen.

Das philosophische Rätsel

An Skalierungsgesetzen ist etwas philosophisch Seltsames.

Warum sollte Sprachvorhersage so sauberen mathematischen Mustern folgen? Die Trainingsdaten sind ein chaotischer, widersprüchlicher Schnappschuss menschlichen Schreibens. Die Architektur ist eine Reihe technischer Entscheidungen. Der Optimierungsprozess ist stochastisch. Und doch folgt das Ergebnis Potenzgesetzen über sieben Größenordnungen.

Manche sehen darin einen Hinweis, dass Intelligenz eine mathematische Struktur hat, die darauf wartet, entdeckt zu werden. Andere sehen eine verdächtige Koinzidenz, die nicht ewig halten muss. Wieder andere argumentieren, es spiegele einfach die statistischen Eigenschaften von Sprache selbst wider.

Die Skalierungsgesetze funktionieren. Warum sie funktionieren, bleibt ehrlich gesagt unklar.

Wo uns das lässt

Die Skalierungsgesetze gaben der KI-Branche etwas, das sie dringend brauchte: ein Planungsgerüst. Sie ermöglichten Investitionen in Milliardenhöhe, mehrjährige Fahrpläne und selbstbewusste Vorhersagen über künftige Fähigkeiten.

Aber Gerüste können zu Gefängnissen werden.

Der Fokus auf Skalierung könnte andere Ansätze verdrängt haben. Massive Rechenleistung wurde zur Standardantwort, selbst wenn kleinere Experimente dieselben Fragen hätten beantworten können. Akademische Forschung wurde marginalisiert. Alternative Architekturen bekamen weniger Aufmerksamkeit.

Jetzt, wo Vortraining-Skalierung Anzeichen von Belastung zeigt, entdeckt die Branche andere Wege. Inferenz-Skalierung. Synthetische Daten. Bessere Trainingsalgorithmen. Nachtraining-Optimierung. Diese Ansätze gab es die ganze Zeit, aber sie lebten im Schatten der Skalierung.

Die Skalierungsgesetze waren eine Entdeckung darüber, wie KI funktioniert. Sie waren auch eine Entscheidung darüber, wie man Fortschritt verfolgt. Ob diese Entscheidung optimal war, ob wir heute mit vielfältigeren Ansätzen weiter wären, ist eine Frage, die niemand mit Sicherheit beantworten kann.

Was wir wissen: Die Kurven fallen noch. Rechenleistung hilft noch. Die Gesetze gelten noch – auch wenn die Gewinne schwerer einzusammeln sind.

Der nächste Durchbruch könnte aus mehr Größe kommen, oder aus etwas völlig anderem.