Em janeiro de 2020, uma equipe da OpenAI publicou um artigo com um título seco: “Scaling Laws for Neural Language Models.” O próprio artigo era denso, cheio de equações e gráficos que a maioria das pessoas nunca leria.

Mas as implicações eram enormes.

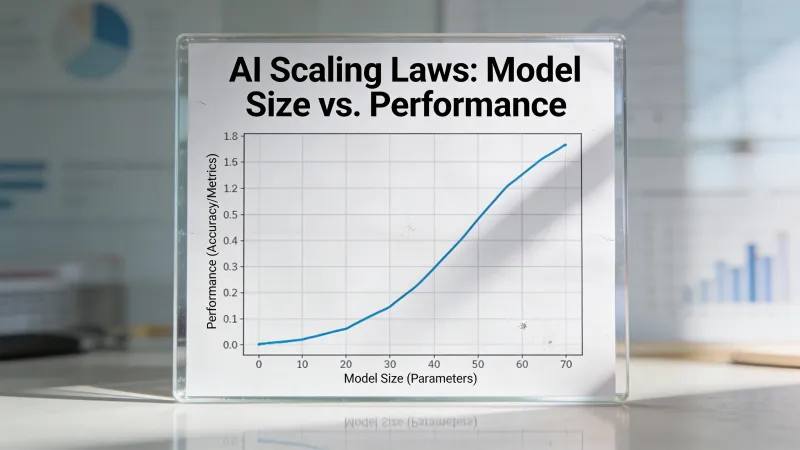

Os pesquisadores, liderados por Jared Kaplan, descobriram algo que parecia arrumadinho demais para ser verdade: o desempenho da IA segue padrões matemáticos que se mantêm ao longo de sete ordens de magnitude. Não correlações vagas. Não tendências aproximadas. Leis de potência com curvas previsíveis.

Essa descoberta mudou como laboratórios de IA operam, para onde fluem bilhões de dólares e quais futuros parecem possíveis.

A descoberta central

O desempenho melhora de forma previsível. Essa frase contém uma afirmação extraordinária, que o artigo da OpenAI de 2020 conseguiu sustentar com experimentos extensos.

Os pesquisadores treinaram dezenas de modelos de linguagem de tamanhos diferentes, com quantidades diferentes de dados, usando quantidades diferentes de computação. Depois, plotaram os resultados. O que surgiu foi uma família de curvas suaves que seguia relações matemáticas precisas.

De acordo com o artigo original de Kaplan et al., “the loss scales as a power-law with model size, dataset size, and the amount of compute used for training.” Essa relação se manteve em modelos que iam de milhões a bilhões de parâmetros.

Dobrar seu orçamento de computação? O erro de previsão do modelo cai por uma quantidade consistente e previsível. Dobrar de novo? A mesma melhora proporcional. As curvas eram suaves até o topo.

Não era assim que alguém esperava que aprendizado de máquina funcionasse. A maioria assumia que haveria retornos decrescentes, platôs, penhascos inesperados em que as coisas parariam de funcionar. Em vez disso, os gráficos mostravam uma melhora implacável e previsível.

Por que isso mudou tudo

Antes das leis de escalonamento, treinar um modelo de IA de ponta era como lançar um foguete sem saber se você tinha combustível suficiente para atingir a órbita — e você só descobriria no fim de uma rodada de treinamento de meses que custava dezenas de milhões de dólares.

Depois das leis de escalonamento, os laboratórios podiam prever resultados.

Quer saber, aproximadamente, quão capaz será seu próximo modelo? Olhe seu orçamento de computação e consulte as curvas. Planejando a coleta de dados? As leis dizem quanto você precisa. Decidindo se deve construir um cluster maior? Dá para estimar os ganhos de capacidade.

A IA virou, em certo sentido, um problema de engenharia em vez de um mistério científico. Não totalmente, não por completo, mas o suficiente para tornar apostas de bilhões de dólares viáveis.

As implicações se espalharam. Empresas agora podiam captar dinheiro com base em capacidades projetadas de modelos. Fabricantes de hardware podiam estimar demanda. Pesquisadores podiam planejar roteiros de vários anos. As leis de escalonamento deram à indústria inteira uma estrutura de planejamento que ela nunca teve.

A correção do Chinchilla

As primeiras leis de escalonamento não estavam exatamente certas.

O artigo de Kaplan sugeria que o tamanho do modelo importava mais do que o tamanho do conjunto de dados. Se você tivesse computação limitada, gastasse em um modelo maior. O GPT-3, com seus 175 bilhões de parâmetros treinados em “apenas” 300 bilhões de tokens, refletia essa filosofia.

Em março de 2022, a DeepMind publicou o que ficou conhecido como o artigo Chinchilla. Eles treinaram mais de 400 modelos de linguagem e encontraram algo diferente.

A abordagem ideal era escalar tamanho do modelo e dados de treinamento juntos, mais ou menos em proporção. A conclusão deles: os modelos existentes estavam subtreinados. Um modelo menor treinado com mais dados podia superar um modelo maior treinado com menos.

O próprio Chinchilla provou o ponto. Com 70 bilhões de parâmetros (menos da metade do GPT-3) treinado em 1,4 trilhão de tokens (quase cinco vezes os dados do GPT-3), ele igualou ou superou o modelo muito maior.

A nova regra era aproximadamente 20 tokens por parâmetro para treinamento ótimo em termos de computação. Essa razão virou um marco que todo laboratório de IA sabia de cor.

A realidade prática da escala

Números como “175 bilhões de parâmetros” e “1,4 trilhão de tokens” são difíceis de imaginar. Vou deixá-los concretos.

Treinar o GPT-3 exigiu cerca de 3.14 x 10^23 operações de ponto flutuante. Isso dá 314.000,000.000,000.000,000.000 cálculos individuais. A rodada de treinamento teria custado entre US$ 4 milhões e US$ 12 milhões só em computação.

O custo de treinamento do GPT-4 foi estimado em mais de US$ 100 milhões. Os requisitos de computação crescem mais rápido do que as melhorias na eficiência do hardware.

Isso cria uma dinâmica específica na indústria. No Hacker News, o comentarista bicepjai observou: “as progress depends more on massive training runs, it becomes capital-intensive, less reproducible and more secretive; so you get a compute divide and less publication.”

As exigências de capital filtram quem pode participar. Um laboratório universitário não consegue competir em escala bruta com uma empresa que pode gastar US$ 100 milhões em uma única rodada de treinamento. As leis de escalonamento criaram um mundo em que o progresso exige recursos que poucos possuem.

O que as leis dizem (e o que elas não dizem)

As leis de escalonamento dizem que a perda diminui de forma previsível. Perda, nesse contexto, significa o quão errado o modelo está ao prever a próxima palavra. Menor perda significa previsões melhores.

Mas aqui está o que as leis não dizem: o que o modelo realmente consegue fazer.

A relação entre perda e capacidades é complexa. Um modelo pode ficar um pouco melhor em prever texto e, de repente, ganhar a capacidade de resolver problemas de matemática que não conseguia resolver antes. Essas “capacidades emergentes” apareceram em limiares específicos de escala que as leis não previam.

O aprendizado com poucos exemplos (few-shot), em que um modelo aprende novas tarefas a partir de um punhado de exemplos, surgiu por volta da marca de 100 bilhões de parâmetros. O raciocínio em cadeia de pensamento (chain-of-thought) apareceu em escalas parecidas. Essas capacidades não eram apenas melhorias quantitativas de habilidades existentes. Eram qualitativamente novas.

As leis de escalonamento descrevem uma curva suave. A realidade mostrou saltos repentinos.

O problema de pesquisa aberta

Nem todo mundo comemorou o paradigma do escalonamento.

No Hacker News, o pesquisador gdiamos comentou: “I especially agree with your point that scaling laws really killed open research. That’s a shame and I personally think we could benefit from more research.”

A preocupação é estrutural. Se o progresso exige computação massiva, só laboratórios bem financiados conseguem avançar. Se só laboratórios bem financiados avançam, a maioria dos pesquisadores não consegue contribuir na fronteira. Departamentos acadêmicos de ciência da computação, historicamente a fonte de ideias de ruptura, ficam de lado.

gdiamos continuou: “If scaling is predictable, then you don’t need to do most experiments at very large scale. However, that doesn’t seem to stop researchers from starting there.”

Há algo irônico aqui. As leis de escalonamento, em teoria, permitem prever resultados em grande escala a partir de experimentos em pequena escala. Na prática, os incentivos empurram todo mundo para a escala mesmo assim. Você não consegue publicar sobre capacidades no nível de GPT-5 se não tiver recursos no nível de GPT-5.

Além do pré-treinamento: novas fronteiras

As leis de escalonamento originais focavam no pré-treinamento, a fase inicial em que um modelo aprende a prever texto. Mas o caminho de desenvolvimento de IA tem mais etapas.

Pesquisas recentes identificaram pelo menos três regimes distintos de escalonamento:

Escalonamento no pré-treinamento segue as leis originais de Kaplan e Chinchilla. Modelos maiores treinados em mais dados preveem texto melhor.

Escalonamento no pós-treinamento cobre ajuste fino e alinhamento. A relação entre computação gasta em feedback humano e comportamento do modelo segue seus próprios padrões, distintos do pré-treinamento.

Escalonamento na inferência é a descoberta mais recente. O modelo o1 da OpenAI demonstrou que deixar um modelo “pensar por mais tempo” na hora da inferência melhora o desempenho de raciocínio. Isso sugere outra dimensão em que mais computação gera resultados melhores.

A existência de múltiplas leis de escalonamento implica caminhos de melhora contínua mesmo que o escalonamento no pré-treinamento desacelere. Um modelo pode, potencialmente, ficar melhor por meio de pós-treinamento mais sofisticado ou por levar mais tempo para raciocinar sobre problemas.

O muro de dados

A correção do Chinchilla criou um novo problema.

Se o treinamento ótimo exige escalar dados junto com o tamanho do modelo, e os modelos de ponta atuais já consumiram a maior parte do texto de alta qualidade na internet, de onde vem o próximo conjunto de dados de treinamento?

Estimativas sugerem que a web indexada contém cerca de 510 trilhões de tokens. Parece muito até você considerar que a maior parte disso é de baixa qualidade, repetitiva ou simplesmente lixo. O texto de maior qualidade — o tipo que realmente ensina um modelo a raciocinar bem — é uma fração pequena.

As abordagens atuais para o muro de dados incluem:

Dados sintéticos: fazer a IA gerar dados de treinamento para a próxima geração de IA. Isso funciona até certo ponto, mas traz riscos de colapso do modelo se for feito sem cuidado.

Expansão multimodal: treinar com imagens, vídeo e áudio junto com texto abre novas fontes de dados. O mundo contém muito mais informação visual do que texto escrito.

Curadoria de maior qualidade: talvez o problema não seja quantidade, e sim qualidade. Filtragem melhor pode extrair mais sinal de aprendizado dos dados existentes.

Criação de novos dados: alguns laboratórios, ao que tudo indica, estão pagando por ou criando conteúdo proprietário especificamente para treinamento.

Nada disso resolve o problema de forma clara. O muro de dados continua sendo uma das restrições centrais para a continuidade do escalonamento.

O debate sobre retornos decrescentes

No fim de 2024 e ao longo de 2025, surgiram relatos de que as melhorias em modelos de ponta estavam desacelerando. Os modelos mais recentes não estavam dando saltos tão dramáticos quanto as gerações anteriores.

Alguns interpretaram isso como a morte do escalonamento. A festa tinha acabado. As leis tinham se esgotado.

Outros apontaram que as leis de escalonamento originais previam retornos decrescentes desde o começo. As curvas são logarítmicas, não exponenciais. Cada duplicação de computação compra uma melhora absoluta menor do que a anterior. Esse sempre foi o padrão esperado.

O debate gira em torno de uma pergunta que ninguém consegue responder de forma definitiva: estamos vendo a desaceleração esperada de uma melhora logarítmica ou um teto fundamental do que o escalonamento pode alcançar?

Observadores diferentes leem os mesmos dados de formas diferentes. O progresso continua, mas a que ritmo? E esse ritmo é suficiente para as capacidades que as pessoas querem?

Previsões que se confirmaram (e que não se confirmaram)

As leis de escalonamento fizeram previsões específicas. Algumas se sustentaram. Algumas não.

Se sustentou: a relação básica entre computação e perda permaneceu notavelmente consistente em diferentes arquiteturas e abordagens. As curvas fundamentais funcionam.

Sustentou em parte: a razão ótima do Chinchilla se mostrou ótima para eficiência de treinamento, mas não para eficiência de implantação. Modelos modernos como o Llama 3 treinam com 200 tokens por parâmetro, bem além do ótimo do Chinchilla, porque os custos de inferência importam mais do que os custos de treinamento em produtos usados em escala.

Não se sustentou: a previsão do artigo original de Kaplan de que o tamanho do modelo importa mais do que o tamanho dos dados estava simplesmente errada. O Chinchilla demonstrou isso de forma decisiva.

Incerto: se o escalonamento continua a produzir capacidades úteis além das escalas atuais ainda não está resolvido. As leis preveem redução contínua da perda, mas não se essa redução da perda se traduz em capacidades com as quais humanos se importam.

O que o escalonamento não consegue dizer

As leis de escalonamento são silenciosas sobre várias questões críticas.

Elas não dizem se um modelo vai alucinar. Reduzir a perda não garante precisão factual.

Elas não dizem se um modelo será seguro ou alinhado aos valores humanos. Um modelo pode prever texto muito bem e ainda assim ser útil, inofensivo ou perigoso.

Elas não dizem se um modelo será bom em alguma tarefa específica. A redução geral da perda não garante desempenho no problema particular que importa para você.

Elas não dizem quando capacidades qualitativamente novas vão surgir. As leis descrevem curvas suaves, mas as capacidades aparecem de forma descontínua.

Essas lacunas importam. Elas significam que, mesmo com conhecimento perfeito das leis de escalonamento, você não consegue prever totalmente como um modelo será. As leis restringem o espaço de possibilidades sem determiná-lo.

O enigma filosófico

Há algo filosoficamente estranho nas leis de escalonamento.

Por que a previsão de linguagem seguiria padrões matemáticos tão limpos? Os dados de treino são um retrato bagunçado e inconsistente da escrita humana. A arquitetura é uma série de escolhas de engenharia. O processo de otimização é estocástico. Ainda assim, o resultado segue leis de potência ao longo de sete ordens de magnitude.

Alguns veem isso como evidência de que a inteligência tem uma estrutura matemática esperando para ser descoberta. Outros veem como uma coincidência suspeita que talvez não se sustente para sempre. Outros ainda argumentam que isso apenas reflete as propriedades estatísticas da própria linguagem.

As leis de escalonamento funcionam. Por que elas funcionam continua genuinamente incerto.

Onde isso nos deixa

As leis de escalonamento deram à indústria de IA algo de que ela precisava desesperadamente: uma estrutura de planejamento. Elas permitiram investimentos de bilhões de dólares, roteiros de vários anos e previsões confiantes sobre capacidades futuras.

Mas estruturas podem virar prisões.

O foco no escalonamento pode ter abafado outras abordagens. Computação massiva virou a solução padrão mesmo quando experimentos menores poderiam ter respondido às mesmas perguntas. A pesquisa acadêmica foi marginalizada. Arquiteturas alternativas receberam menos atenção.

Agora, enquanto o escalonamento do pré-treinamento mostra sinais de desgaste, a indústria está descobrindo outros caminhos. Escalonamento na inferência. Dados sintéticos. Algoritmos de treino melhores. Otimização pós-treinamento. Essas abordagens sempre existiram, mas viviam na sombra do escalonamento.

As leis de escalonamento foram uma descoberta sobre como a IA funciona. Elas também foram uma escolha sobre como perseguir progresso. Se essa escolha foi ótima, se estaríamos mais à frente hoje com abordagens mais diversas, é uma pergunta que ninguém consegue responder com certeza.

O que sabemos: as curvas ainda descem. Computação ainda ajuda. As leis ainda valem, mesmo que os ganhos fiquem mais difíceis de capturar.

A próxima ruptura pode vir de mais escala — ou de outra coisa completamente diferente.