Todo mundo quer personalizar a IA. Poucos entendem as opções.

Você tem documentos da empresa que o modelo nunca viu, um estilo de escrita específico que ele ignora ou conhecimento do seu domínio que vive virando alucinação, e você quer uma IA que realmente funcione para a sua realidade — em vez de produzir uma resposta genérica que passa longe do que você precisa.

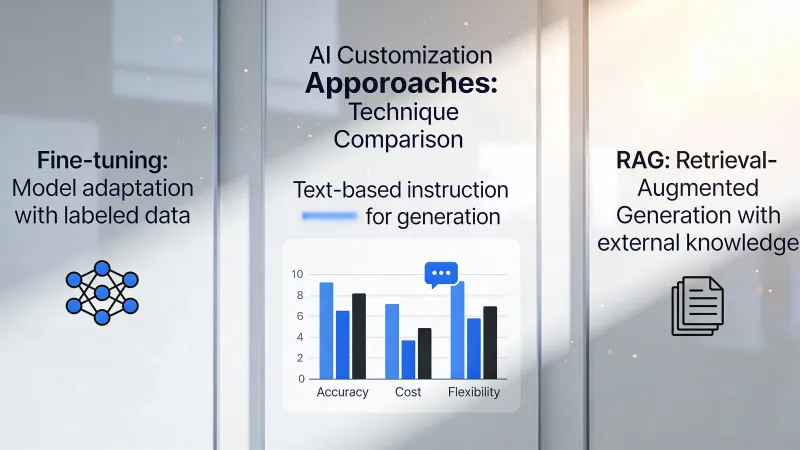

Existem três caminhos: prompts, RAG e ajuste fino. O mercado trata isso como uma escada, em que você sobe do simples para o sofisticado, mas essa narrativa gera erros caros, porque cada abordagem resolve um tipo de problema fundamentalmente diferente — e escolher pela complexidade percebida, em vez do encaixe real, desperdiça tempo e dinheiro.

A verdade incômoda sobre o ajuste fino

Vamos começar pela opção que parece mais impressionante.

O ajuste fino (fine-tuning) muda o próprio modelo. Você fornece exemplos de entrada e a saída desejada, e o processo de treino ajusta os pesos internos do modelo para produzir aquele tipo de resposta com mais consistência, essencialmente ensinando novos comportamentos por exposição repetida aos seus padrões específicos.

Parece poderoso. É poderoso.

E também quase nunca é o que você precisa.

No Hacker News, intellectronica foi direto: “Fine-tuning is super important and powerful…in reality for most use cases it offers little advantage for a lot of effort.” Essa avaliação continua se provando verdadeira em implantações reais, em que equipes passam meses preparando dados de treinamento só para descobrir que bons prompts teriam resolvido o problema em uma tarde.

O equívoco é profundo. As pessoas presumem que o ajuste fino ensina fatos novos ao modelo do mesmo jeito que estudar ensina humanos, mas dvt, no Hacker News, contestou isso de frente: “It does not teach the model new knowledge.” Ajuste fino muda comportamento e estilo, não o conhecimento subjacente que o modelo consegue acessar — o que significa que, se o seu problema é que o modelo não sabe dos produtos ou políticas da sua empresa, ajuste fino não vai consertar isso.

Onde o ajuste fino brilha é em consistência. Se você precisa de um modelo que gere JSON perfeitamente formatado toda vez, ou mantenha um tom exato ao longo de milhares de interações, ou execute uma tarefa estreita com confiabilidade quase mecânica, o ajuste fino entrega o que prompts não conseguem.

O custo torna essa decisão séria. Treinamentos variam de centenas de dólares para modelos pequenos a dezenas de milhares para qualquer coisa substancial. A preparação dos dados muitas vezes dobra o investimento total, porque você precisa de exemplos de alta qualidade exatamente no formato que o pipeline de treino espera. E quando seus requisitos mudam? Você treina de novo.

Por que RAG geralmente vence

Aqui está o que a maioria das equipes realmente precisa: uma IA que saiba sobre as suas coisas.

RAG funciona de outro jeito. Em vez de mudar o modelo, você constrói um sistema de recuperação que encontra documentos relevantes quando alguém pergunta algo e, então, inclui esses documentos no prompt para que o modelo tenha a informação de que precisa para responder com precisão.

O modelo continua genérico. O conhecimento continua externo.

Essa distinção importa muito. Quando a documentação do seu produto muda, você atualiza os documentos e o RAG passa a usar as novas informações imediatamente. Sem retreino. Sem equipe de ciência de dados. Só atualizar seus arquivos.

Um profissional, no Hacker News, descreveu essa troca assim: “RAG is focused more on capturing and using external resources on an ad hoc basis, where fine tuning looks to embed a specific ‘behaviour’ change in the model for a particular need.” Isso capta o ponto com precisão. RAG resolve o quê. Ajuste fino resolve o como.

O argumento da transparência também pesa. Quando o RAG dá uma resposta, você consegue rastrear aquilo até documentos-fonte específicos — o que permite auditar respostas, pegar alucinações e mostrar aos usuários exatamente de onde veio a informação. Modelos ajustados não oferecem esse tipo de rastro.

Comparações de custo favorecem o RAG com folga. Montar um banco de dados vetorial e um pipeline de embeddings custa de $200 a $2.000 por mês em implementações típicas. Ajustar um modelo de produção de forma correta custa isso só em computação de treino, antes de contar preparação de dados e manutenção contínua.

Mas RAG tem limites. Ele depende de documentos relevantes existirem. A etapa de recuperação adiciona latência. Documentos longos pressionam as janelas de contexto. E, de forma crítica, RAG não consegue mudar como o modelo raciocina ou escreve.

Prompts não são a opção de iniciante

Tratar prompts como o primeiro degrau de uma escada ignora o poder real disso.

Engenharia de prompts é criar instruções que guiam o comportamento do modelo sem modificar nada externamente. Você trabalha inteiramente dentro da conversa. Sem infraestrutura. Sem dados de treino. Sem bancos de dados vetoriais.

Parece simples. Aí mora a armadilha.

Engenharia de prompts sofisticada inclui estruturas de raciocínio bem definidas, exemplos com poucos casos (few-shot) que demonstram padrões exatos, decomposições de cadeia de pensamento para tarefas complexas e especificação cuidadosa de restrições que molda as saídas sem regras explícitas. Equipes que tratam prompts como algo básico muitas vezes nem exploraram o que dá para fazer quando você investe esforço de verdade nisso.

adamgordonbell compartilhou uma experiência reveladora: “When I first wanted to tackle a hard problem I thought to reach for fine-tuning with lots of input and output pairs, but it wasn’t needed.” Esse padrão se repete o tempo todo. Engenheiros assumem que complexidade exige soluções complexas e, depois, descobrem que bons prompts resolvem o problema com mais elegância.

A estrutura de custos faz com que valha investir a sério em prompts. Horas iterando prompts não custam nada além da assinatura. Se você resolve o problema só com prompts, você evita infraestrutura inteira — o que significa ciclos de iteração mais rápidos, manutenção mais simples e menos risco quando os requisitos mudam.

Só que a limitação é real. Prompts só conseguem moldar comportamento dentro do que o modelo já sabe fazer. Você não consegue “promptar” um modelo para entender conceitos que ele nunca encontrou durante o treino, e não consegue “promptar” acesso a informações que o modelo não tem.

A decisão que realmente importa

Pare de perguntar qual é melhor. Pergunte qual é o seu problema de verdade.

O modelo erra fatos sobre sua empresa, seus produtos ou eventos recentes. Isso é um problema de conhecimento. RAG resolve problemas de conhecimento dando ao modelo a informação que ele não tem, no momento da pergunta.

O modelo sabe a informação certa, mas entrega saídas nos formatos errados, nos estilos errados ou com qualidade inconsistente entre interações. Isso é um problema de comportamento. Ajuste fino resolve problemas de comportamento ajustando como o modelo gera respostas.

O modelo poderia fazer o que você quer, mas não faz porque suas instruções não estão claras o suficiente. Isso é um problema de instruções. Engenharia de prompts resolve problemas de instruções com orientação melhor dentro da conversa.

A maioria das equipes mistura essas categorias. Elas têm um problema de conhecimento e assumem que ajuste fino vai ensinar conhecimento novo. Elas têm um problema de instruções e assumem que RAG vai fornecer instruções. Combinar a solução com o problema real economiza meses de esforço desperdiçado.

O meio-termo perigoso

Às vezes o problema atravessa categorias. Você precisa de conhecimento da empresa E formatação consistente E padrões específicos de raciocínio.

É aí que surgem arquiteturas combinadas. RAG fornece informação atual. Ajuste fino garante uma estrutura de saída consistente. Prompts dão orientação específica para cada consulta. Os três trabalhando juntos.

phillipcarter, no Hacker News, alertou contra falsas dicotomias: “Fine-tuning doesn’t eliminate the need for RAG, and RAG doesn’t obviate the need for fine-tuning either.”

Mas combinações multiplicam a complexidade. Três sistemas para manter. Três pontos de falha em potencial. Três conjuntos de custos. Construa combinações só quando abordagens únicas falharem de forma demonstrável, não como um seguro contra problemas hipotéticos.

As equipes de IA mais sofisticadas tratam isso como lógica de roteamento. Consultas simples ficam só com prompts. Consultas intensivas em conhecimento ativam RAG. Operações de alto valor, com formato crítico, vão para modelos ajustados. O próprio sistema decide qual caminho cada solicitação toma.

Essa arquitetura exige engenharia significativa. A maioria das equipes não precisa disso. A maioria das equipes precisa escolher uma abordagem e executá-la bem.

O que o mercado aprendeu da pior forma

As primeiras implantações de IA em empresas deram preferência ao ajuste fino porque ele parecia mais substancial, mais defensável em apresentações para executivos, mais obviamente diferente de simplesmente usar o ChatGPT. Essas iniciativas frequentemente travavam na preparação de dados, em fases que se estendiam por meses.

solidasparagus resumiu a realidade prática: “collecting data and then fine-tuning models is orders of magnitude more complex than just throwing in RAG.”

A complexidade não é só técnica. Ajuste fino exige conjuntos de dados curados que representem seu caso de uso com precisão, o que significa identificar como é uma boa saída, coletar exemplos suficientes, formatá-los corretamente e validar que o conjunto de treinamento não contém erros que vão se propagar para o modelo. RAG exige enviar documentos que você provavelmente já tem.

Isso não significa que ajuste fino nunca seja o certo. Empresas que rodam milhões de consultas semelhantes por dia podem ajustar modelos menores que ficam mais rápidos e mais baratos do que modelos grandes e genéricos. Domínios especializados com terminologia e padrões de raciocínio únicos às vezes exigem mudanças de comportamento que prompts não conseguem alcançar. Aplicações sensíveis a latência se beneficiam de modelos menores ajustados em vez de modelos maiores guiados por prompts.

Mas o limiar é alto. Você precisa de volume para justificar o investimento. Você precisa de requisitos de comportamento claros que não mudem com frequência. Você precisa de dados de treinamento de qualidade — ou do orçamento para criá-los. E você precisa de paciência para um ciclo de iteração medido em semanas, não em horas.

A opção subestimada

Para muitas aplicações de negócio, a resposta é mais simples do que qualquer uma dessas.

Use o modelo como ele é, com bons prompts. Aceite alguma imperfeição. Coloque no ar.

A busca por uma personalização perfeita da IA atrasa valor real. Equipes passam meses em arquiteturas de RAG quando um modelo de prompt e revisão manual atenderia melhor aos usuários reais no curto prazo.

Isso não significa se acomodar para sempre. Significa sequenciar direito: provar que o conceito funciona com abordagens simples primeiro, identificar lacunas específicas no uso real e, então, investir na personalização que resolve essas lacunas específicas.

Começar com ajuste fino antes de validar o caso de uso é como otimizar código antes de saber se é o código certo. O esforço pode ser desperdiçado em um problema que não existe — ou que muda conforme você aprende mais sobre o que os usuários realmente precisam.

Pontos de partida práticos

Se o seu problema é conhecimento, comece com RAG. Coloque seus documentos em uma base vetorial, traga a recuperação para os seus prompts e veja se o modelo entrega respostas corretas quando tem a informação certa disponível.

Se o seu problema é consistência, comece com prompts detalhados, incluindo exemplos. Mostre ao modelo exatamente o que você quer com amostras anotadas. A maioria dos problemas de consistência cede a prompts com poucos exemplos (few-shot) antes de exigir ajuste fino.

Se o seu problema é capacidade — ou seja, o modelo simplesmente não consegue fazer a tarefa — questione se IA é a solução certa. Ajuste fino pode estender capacidades nas margens, mas não pode transformar um modelo de linguagem em algo para o qual ele não foi projetado.

Se você não tem certeza de qual é o seu problema, esse é o problema de verdade. Gaste tempo caracterizando falhas antes de investir em soluções. Converse com usuários. Olhe para as saídas ruins. Entenda especificamente o que deu errado e por quê, antes de decidir como corrigir.

As equipes que têm sucesso com personalização de IA compartilham um traço: elas definem o problema com precisão antes de escolher a solução e, então, validam a escolha com investimento mínimo antes de escalar a abordagem pela organização.

As equipes que sofrem pulam para soluções que soam sofisticadas sem entender o problema o suficiente para saber se sofisticação é necessária.

Comece simples. Adicione complexidade só quando o simples falhar de forma demonstrável.

Esse não é um conselho empolgante. Mas é o conselho que funciona.