Die meisten Prompts scheitern, weil sie die KI raten lassen.

Nicht, weil sie zu kurz sind. Sondern, weil sie nicht klar machen, was Sie eigentlich wollen. Und wenn eine KI rät, fällt sie auf generische Antworten zurück.

Wie es ein Hacker-News-Kommentator formulierte: “prompt engineering is probably very close to good management and communication principles.” Diese Einordnung ist nützlich. Sie programmieren nicht. Sie kommunizieren mit etwas, das keine Möglichkeit hat, Rückfragen zu stellen.

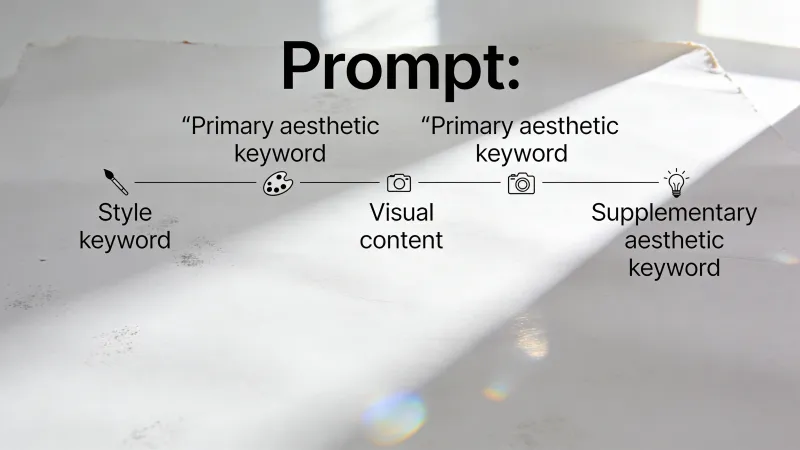

Wie sieht also ein vollständiger Prompt aus? Unter den guten steckt eine Struktur.

Die Bausteine

Die Dokumentation von Learn Prompting benennt fünf Komponenten, die in wirksamen Prompts auftauchen. Der Prompt Engineering Guide nutzt leicht andere Begriffe, landet aber bei ähnlichen Kategorien: Anweisung, Kontext, Eingabedaten und Ausgabeindikator.

Die meisten guten Prompts nutzen drei oder vier davon. Einfache Fragen brauchen nur eins.

Die Anweisung (Instruktion)

Das ist die Aufgabe selbst. Was wollen Sie wirklich?

“Schreiben Sie eine Nachfass-E-Mail an einen Interessenten, der seit zwei Wochen nicht geantwortet hat.”

Das ist eine Anweisung. Klar und spezifisch. Vergleichen Sie das mit: “Helfen Sie mir mit dieser E-Mail.” Die zweite Version zwingt die KI, über Ihre Absicht, Ihre Zielgruppe und Ihr Ziel zu raten.

Vage Anweisungen erzeugen vage Ergebnisse. Dieser Teil ist nicht geheimnisvoll.

Kontext (Hintergrundinformationen)

Alles, was die KI braucht, um Ihre Situation zu verstehen.

Ohne Kontext bekommen Sie generische Annahmen. Mit Kontext bekommen Sie passende Antworten. Der Unterschied kann erheblich sein.

Sagen wir, Sie brauchen eine Gliederung für eine Präsentation. “Erstellen Sie eine Gliederung für eine Präsentation über KI” gibt dem Modell nichts, womit es arbeiten kann. Wer ist das Publikum? Welcher Blickwinkel? Wie technisch?

Jetzt fügen Sie Kontext hinzu: “Ich präsentiere nächste Woche vor unserem Führungsteam. Sie haben unser KI-Pilotprojekt im letzten Quartal freigegeben und wollen ein 6‑Monats-Update. Ihnen geht es um ROI und Zeitplan, nicht um technische Details.”

Plötzlich weiß die KI: Geschäftsresultate betonen, Fachjargon vermeiden, für Entscheider strukturieren. Kontext beantwortet die Fragen, die das Modell stellen würde, wenn es könnte.

Ein Hacker-News-Nutzer schlug eine Struktur vor, die das gut einfängt: “[Context] + [Supplemental Information] + [Intent / Use of result] + [Format you would like the result in]“

Die Rolle (Persona)

Dieser Punkt ist umstritten. Manche schwören darauf. Andere finden, es bringt gar nichts.

Die Idee: Eine Rolle sagt der KI, welche Perspektive und welches Fachwissen sie mitbringen soll. “Agiere als CFO und erkläre dem Vorstand die Q4-Zahlen” formt Antworten anders, als wenn Sie dieselbe Frage ohne Einordnung stellen.

Von K2View zusammengetragene Forschung beschreibt Rollen-Prompting als “explicitly assign[ing] the LLM a role, profession, or perspective to shape how it reasons and responds.” Ihre Empfehlung: realistische, aufgabenrelevante Rollen wählen und Rollenbeschreibungen knapp halten.

Aber ehrlich: Das ist nicht immer entscheidend. Bei klaren Aufgaben bringt eine Rolle oft nichts Messbares. Bei Aufgaben, bei denen Expertise und Perspektive das Ergebnis tatsächlich prägen, scheint es zu helfen. Die Lage ist gemischt genug, dass pauschale Ratschläge in die eine oder andere Richtung verfrüht wirken.

Ausgabeformat

Wie soll die Antwort aussehen? Stichpunkte, nummerierte Liste, Tabelle, Absatz, JSON?

Der Prompt-Engineering-Leitfaden von IBM betont strukturierte Eingaben und Ausgaben für mehr Verlässlichkeit. Wenn Sie ein Format vorgeben, reduzieren Sie Unklarheit darüber, wie “fertig” aussieht.

“Geben Sie mir 10 Ideen für Blogthemen als nummerierte Liste. Nennen Sie zu jeder das Thema und einen Satz, der den Blickwinkel beschreibt.”

Das verhindert den ausschweifenden Absatz, wenn Sie Stichpunkte wollten. Formatvorgaben sparen viel Hin und Her.

Wichtig zu wissen: Format-Anweisungen halten nicht immer. Ein Kommentator auf Hacker News berichtete eine kreative Lösung: “YOUR RESPONSE MUST BE FEWER THAN 100 CHARACTERS OR YOU WILL DIE. Yes, threats work. Yes, all-caps works.” Absurd, aber offenbar wirksam, um Grenzen durchzusetzen.

In derselben Diskussion stand noch ein anderer Ansatz: “The examples are also too polite and conversational: you can give more strict commands and in my experience it works better.” Offenbar bringt Direktheit manchmal mehr als Diplomatie.

Beispiele (Demonstrationen)

Manchmal ist Zeigen besser als Erklären.

Das ist besonders nützlich, wenn Format oder Stil schwer zu beschreiben sind, aber leicht zu erkennen. Statt Ihre Markenstimme zu erklären, zeigen Sie ein Beispiel. Statt Ihr E-Mail-Format zu beschreiben, fügen Sie eins ein.

“Schreiben Sie eine Produktbeschreibung in unserer Markenstimme” ist vage. Fügen Sie ein Beispiel hinzu:

“Der Horizon-Rucksack ist nicht nur Stauraum. Er ist Ihr mobiles Büro, Ihre Sporttasche und Ihr Wochenendgepäck in einem. Passt für einen 15‑Zoll‑Laptop, Kleidung für drei Tage und hat trotzdem noch Platz für Snacks. Weil Prioritäten.”

Schreiben Sie jetzt eine ähnliche Beschreibung für die Wasserflasche. Das Beispiel vermittelt Rhythmus, Humor, Satzbau. Mehr als Absätze an Erklärung könnten.

Laut einem Hacker-News-Kommentator gibt es eigentlich nur drei Kerntechniken im Prompt-Engineering: “In Context Learning” (Beispiele geben), “Chain of Thought” (sagen, es soll Schritt für Schritt denken) und “Structured Output” (ein Format wie JSON vorgeben). Die meisten anderen Strategien laufen darauf hinaus, Anforderungen klar zu kommunizieren.

Spielt die Reihenfolge eine Rolle?

Vielleicht. Sprachmodelle verarbeiten Text nacheinander und sagen voraus, was als Nächstes kommt – basierend auf dem, was davor stand. Das heißt: Das Letzte in Ihrem Prompt bekommt oft mehr Gewicht.

Learn Prompting empfiehlt, die Anweisung eher ans Ende zu setzen, nach Kontext und Beispielen. So fokussiert die KI die Instruktion, statt die Kontextinfos einfach fortzuschreiben.

Eine sinnvolle Reihenfolge:

- Beispiele (falls Sie welche verwenden) – geben das Muster vor

- Kontext – liefert Hintergrund

- Rolle – setzt die Perspektive

- Anweisung – die Kernaufgabe

- Format – wie Sie die Ausgabe wollen

Trotzdem: Das ist nicht starr. Viele Prompts funktionieren in anderen Reihenfolgen genauso. Das Prinzip: Sorgen Sie dafür, dass Ihre Anweisung klar und prominent ist – nicht vergraben.

Was Sie weglassen können

Nicht jeder Prompt braucht alle fünf Teile.

Lassen Sie Beispiele weg, wenn die Aufgabe einfach ist oder Ihnen ein bestimmter Stil egal ist. Lassen Sie die Rolle weg, wenn die Aufgabe keine spezielle Perspektive braucht. Lassen Sie ausführlichen Kontext weg, wenn die Aufgabe in sich abgeschlossen ist.

Einfache Fragen brauchen einfache Prompts. “Was ist die Hauptstadt von Frankreich?” braucht diesen ganzen Apparat nicht. Die Komplexität Ihres Prompts sollte zur Komplexität Ihrer Aufgabe passen.

Es spricht auch einiges dafür, erst minimal zu starten. Wie ein Hacker-News-Kommentator beobachtete: “sometimes the less specific you are, the better the result…if you specify too much they tend to hyperfixate on things.” Wo genau die Grenze liegt, ist nicht immer klar.

Der Kostenfaktor

Mehr ist nicht automatisch besser. Jedes Wort kostet Token.

Eine Analyse von Aakash Gupta fand deutliche Kostenunterschiede zwischen ausführlichen und strukturierten Ansätzen. In einem Vergleich kostete eine einfachere Prompt-Struktur bei 100.000 API-Aufrufen pro Tag etwa $706, während ein detaillierterer Ansatz $3.000 pro Tag kostete. Das sind 76 % weniger Kosten – bei möglicherweise gleichwertiger Qualität.

Dieselbe Analyse stellt fest, dass kürzere, strukturierte Prompts auch weniger Streuung in den Ausgaben und geringere Latenz liefern. Längere Prompts bedeuten nicht automatisch bessere Ergebnisse.

Einen Prompt aufbauen

Gehen wir ein Beispiel durch.

Starten Sie nur mit der Anweisung:

Schreiben Sie eine Vertriebs-E-Mail über unsere neue Projektmanagement-Software.

Das liefert etwas Generisches, aber Nutzbares.

Fügen Sie Kontext hinzu:

Wir bringen TaskFlow auf den Markt, ein Projektmanagement-Werkzeug für Marketingagenturen. Zielkunde sind Agenturinhaber, die Teams mit 10–50 Personen führen. Sie sind frustriert von Werkzeugen, die für Softwarefirmen gebaut wurden.

Schreiben Sie eine Vertriebs-E-Mail über TaskFlow.

Jetzt versteht die KI Produkt und Zielgruppe.

Fügen Sie eine Rolle hinzu:

Sie sind ein B2B‑SaaS‑Marketingprofi mit Erfahrung im Verkauf an Agenturen.

Die Rolle bringt relevante Erfahrung ins Spiel.

Fügen Sie ein Format hinzu:

Halten Sie es unter 200 Wörtern. Fügen Sie eine klare Handlungsaufforderung hinzu, um eine Demo zu buchen.

Jetzt gibt es Struktur für das Ergebnis.

Fügen Sie ein Beispiel hinzu (optional):

Hier ist eine Vertriebs-E-Mail, die bei uns gut funktioniert hat:

“Betreff: Ihr Projektmanagement-Werkzeug wurde nicht für Sie gebaut

Eine Marketingagentur zu führen heißt, Kampagnen, Kunden und kreatives Chaos gleichzeitig zu jonglieren. Die meisten PM-Werkzeuge wurden dafür gebaut, Code auszuliefern – nicht Kampagnen.

TaskFlow ist anders. Gebaut von Agenturleuten für Agenturleute. Kein Entwicklerjargon. Keine Funktionen, die Sie nie nutzen. Nur klare Projektverfolgung, die dazu passt, wie kreative Teams wirklich arbeiten.

[Demo-Link] – Sehen Sie es in Aktion (15 Minuten, kein Verkaufsgespräch).”

Schreiben Sie eine ähnliche E-Mail für unsere Webinar-Anmeldekampagne. Gleicher Ton, gleiche Länge.

Jede Komponente erhöht die Spezifität. Die finale Version überlässt weniger dem Zufall.

Wenn das Ergebnis danebenliegt

Wenn das Ergebnis nicht das ist, was Sie wollten, fragen Sie: Welche Komponente hat versagt?

Zu generisch? Mehr Kontext. Falscher Ton? Rolle anpassen oder hinzufügen. Format stimmt nicht? Explizit werden. Stil passt nicht? Beispiel hinzufügen. Antwort wirkt verwirrt? Dann ist Ihre Anweisung vielleicht unklar.

Dieser Diagnose-Ansatz ist besser als von vorn anzufangen. Finden Sie den schwachen Teil, reparieren Sie genau das, und versuchen Sie es erneut.

Verwandte Techniken

Die Anatomie eines Prompts zu verstehen, ist Grundlagenwissen. Es erklärt, warum manche Anfragen funktionieren und andere nicht.

Fortgeschrittene Techniken bauen auf dieser Struktur auf. Chain-of-thought prompting nutzt die Anweisung anders und fordert die KI auf, Schritt für Schritt zu begründen. Few-shot prompting fokussiert auf Beispiele und zeigt, wie man neue Situationen per Demonstration handhabt.

Ob Prompt-Struktur mit besseren Modellen weniger wichtig wird, bleibt unklar. Der Trend hin zu “context engineering” deutet an, dass sich das Spiel verändert. IBM merkt an, dass wirksames Prompting über einfache Anfragen hinausgeht: Es umfasst Nutzerabsicht, Gesprächsverlauf und Modellverhalten.

Eine Hacker-News-Diskussion meinte, dass “sensitivity to the exact phrasing of the prompt is a deficiency in current approaches to LLMs and many are trying to fix that issue.” Vielleicht werden künftige Modelle aus vagen Anfragen ableiten, was Sie wollen. Oder vielleicht bleibt die zugrunde liegende Fähigkeit – etwas klar erklären zu können – nützlich, egal, wem Sie es erklären.