Tienes una tarea para una IA. ¿Solo se la pides o primero le enseñas qué quieres?

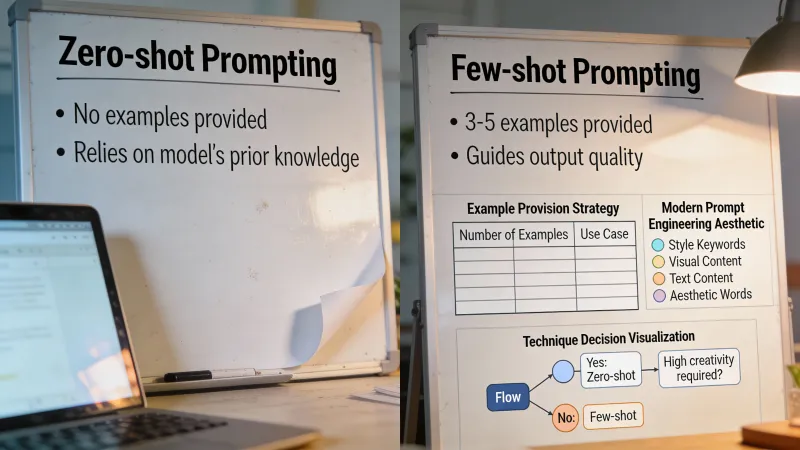

Esa es la pregunta de zero-shot vs few-shot. Zero-shot significa pedir directamente, sin ejemplos. Few-shot significa dar uno o más ejemplos antes de tu solicitud real. Los nombres vienen de la investigación en aprendizaje automático, pero la idea es simple: mostrar vs decir.

La mayoría de la gente nunca usa ejemplos o los usa para todo. Ambas cosas están mal. La respuesta depende de lo que estés pidiendo, del modelo que uses y de si el formato importa más que el contenido.

El enfoque de ejemplos primero

El prompting few-shot funciona por coincidencia de patrones. Le muestras a la IA cómo se ve una buena salida y replica ese patrón para tu nueva entrada. Esto es especialmente potente cuando necesitas un formato, tono o estructura específicos que son difíciles de describir con palabras.

Supón que necesitas descripciones de producto para un sitio de comercio electrónico. Podrías explicar que quieres descripciones cortas y contundentes, con características clave en un orden específico. O podrías simplemente mostrar una:

Taza de viaje de cerámica Mantiene el café caliente durante 4 horas. Cabe en portavasos estándar. Apta para lavavajillas. Disponible en 6 colores.

Luego pide una descripción de una botella de agua de acero inoxidable. La IA ahora tiene una plantilla. Igualará la longitud, la estructura de las frases y el nivel de detalle. No hay ambigüedad sobre lo que estás buscando.

Un comentarista de Hacker News lo resumió así: “In general, showing an example of correct output (one shot prompting) can greatly improve output format consistency.”

Ese es el beneficio central. Consistencia. Cuando necesitas que la IA produzca varias salidas con el mismo formato, los ejemplos le ganan a las instrucciones casi siempre.

Cuándo los ejemplos lo cambian todo

Las mejoras del prompting few-shot pueden ser drásticas. En un estudio de caso sobre codificación médica, añadir pares ejemplo-etiqueta a los prompts mejoró la precisión de 0% a 90%. No es un error tipográfico. El mismo modelo pasó de estar completamente equivocado a rozar lo perfecto solo por ver unos pocos ejemplos antes.

Pero ese es un escenario ideal. La investigación recopilada por PromptHub muestra rendimientos decrecientes después de unos dos o tres ejemplos. Ves grandes mejoras con los primeros, y luego llega una meseta. Añadir diez ejemplos en lugar de tres rara vez ayuda y puede incluso perjudicar al recargar el prompt.

Un estudio de la Universidad de Londres sobre reparación automática de errores encontró algo contraintuitivo: su marco MANIPLE logró una mejora del 17% en correcciones exitosas al optimizar qué ejemplos incluir, pero añadir más ejemplos a veces degradaba el rendimiento. El prompt se volvía más ruidoso, no más inteligente.

El sorprendente caso contra los ejemplos

Aquí es donde se pone interesante. Las reglas están cambiando con los modelos de razonamiento más nuevos.

La serie o1 de OpenAI y modelos similares, centrados en razonar, en muchos casos rinden peor con ejemplos. La investigación citada por PromptHub encontró que el prompting de 5 ejemplos redujo el rendimiento de o1-preview frente a una referencia de prompt mínimo. La documentación de DeepSeek-R1 afirma explícitamente que el prompting few-shot “consistently degrades its performance.”

¿Por qué? Estos modelos están diseñados para razonar por su cuenta. Darles ejemplos puede limitar su pensamiento o llevarlos por el camino equivocado. Funcionan mejor cuando describes qué quieres y les dejas resolver cómo llegar ahí.

Esto importa porque el sector se está moviendo hacia modelos de razonamiento. Si usas o1, o3-mini o similares, prueba primero sin ejemplos. Añádelos solo si hay que corregir el formato de la salida.

El problema modelo por modelo

Hay otra complicación. Los mejores ejemplos para un modelo pueden no ser los mejores para otro.

Aickin, fundador de Libretto, hizo experimentos para comprobar si los ejemplos con mejor desempeño en un modelo también eran los mejores en otro. El hallazgo fue claro: “Most of the time, the answer was no, even between different versions of the same model.”

La implicación práctica es dura. Probablemente necesites optimizar ejemplos modelo por modelo y repetir ese trabajo cada vez que salga una versión nueva. Esos tres ejemplos perfectos que diseñaste para GPT-4 podrían no trasladarse a GPT-4o o Claude 3.5.

Para la mayoría, esto significa mantener los ejemplos simples y no sobreoptimizarlos. Cuanto más específicos sean tus ejemplos, más probable será que fallen cuando cambies de modelo o el modelo se actualice.

Mostrar vs decir: cuándo funciona cada uno

Olvida las reglas rígidas. Piensa en lo que realmente quieres lograr.

Los ejemplos funcionan mejor cuando:

El formato lo es todo. Si necesitas JSON, tablas en markdown o una plantilla específica rellenada, un ejemplo suele ganarles a párrafos de instrucciones. La IA ve la estructura y la replica.

El estilo es difícil de describir. “Escribe con la voz de nuestra marca” es vago. Mostrar tres frases con esa voz es concreto. El patrón es más fácil de imitar que la descripción.

Estás haciendo tareas repetitivas. ¿Necesitas veinte descripciones de producto? Das dos ejemplos y obtienes dieciocho más con el mismo formato. La consistencia se acumula.

El modelo es un LLM estándar como GPT-4 o Claude. Estos modelos están entrenados para seguir patrones. Responden bien a enfoques de mostrar, no decir.

Omite ejemplos cuando:

La tarea exige razonamiento. Problemas matemáticos, acertijos lógicos, depuración de código, análisis estratégico. En estos casos, explica qué quieres y deja que el modelo piense. Añadir ejemplos puede limitar su enfoque o introducir errores por la solución específica de tu ejemplo.

Estás usando un modelo de razonamiento. o1, o3-mini, DeepSeek-R1. Estos modelos generan internamente su propia cadena de pensamiento. Los ejemplos pueden interferir en ese proceso.

La tarea es directa. “Resume este artículo en tres frases” no necesita ejemplo. La instrucción ya es lo bastante clara. Añadir ejemplos solo quema tokens sin mejorar la salida.

Necesitas creatividad, no consistencia. Si quieres que la IA te sorprenda, los ejemplos limitan el espacio de salidas posibles. Le estás mostrando qué está permitido en lugar de qué es posible.

La prueba en el mundo real

La teoría está bien. La práctica, mejor.

Haz un experimento simple antes de comprometerte con un enfoque. Toma tu tarea, ejecútala tres veces en zero-shot y tres veces con dos ejemplos. Compara las salidas. ¿Los ejemplos mejoraron la calidad? ¿Mejoraron la consistencia? ¿Cambió algo en absoluto?

Muchas veces la respuesta es: “Los ejemplos ayudaron con el formato, pero no con la calidad del contenido.” Esa información es útil. Te dice cuándo invertir en ejemplos y cuándo invertir, en cambio, en mejores instrucciones.

Algunos profesionales descubren que el punto óptimo es un ejemplo para el formato más instrucciones detalladas para todo lo demás. Obtienes la consistencia estructural del ejemplo y dejas que las instrucciones guíen la sustancia.

El cálculo de costos

Los ejemplos no son gratis. Cada ejemplo que añades cuesta tokens en cada llamada a la API. Con Claude Haiku o GPT-4o-mini, el costo es insignificante. Con GPT-4 o Claude Opus, se acumula.

Las matemáticas cambian según el volumen. Si ejecutas un prompt una sola vez, añade tantos ejemplos como quieras. Si lo ejecutas miles de veces al día, cada token importa.

Minimaxir señaló en Hacker News que la economía favorece más que nunca el prompting few-shot: “You will often get better results with few-shot prompting (with good examples) on a modern LLM than with a finetuned LLM.” Los tokens de entrada se han abaratado, especialmente con modelos como Claude Haiku. El costo de añadir ejemplos ha caído de forma drástica.

Pero la comparación no va solo de costo por token. Ajustar finamente un modelo cuesta entre 4 y 6 veces más que el uso estándar de API, según los precios de OpenAI. Si eliges entre ajuste fino y ejecutar muchos ejemplos, los ejemplos suelen ganar en costo incluso con los tokens extra.

El peligroso punto medio

El peor enfoque es añadir ejemplos sin pensar si realmente ayudan.

Prompting por inercia. Viste en algún sitio que “siempre hay que añadir ejemplos” y ahora cada prompt lleva tres ejemplos, sean relevantes o no. La IA se confunde sobre qué es instrucción y qué es contexto. La salida empeora, no mejora.

O lo contrario: has interiorizado que los prompts deben ser “claros y directos”, así que nunca muestras ejemplos, incluso cuando el formato importa. Acabas escribiendo párrafos sobre estructuras de tabla cuando un solo ejemplo comunicaría lo mismo en dos líneas.

La habilidad no está en memorizar reglas. Está en reconocer en qué situación estás.

Mezclar enfoques

La elección entre ejemplos e instrucciones no es binaria. Puedes explicar lo que quieres y después mostrarlo.

Para extracción de documentos, podrías escribir: “Extrae de estos formularios el nombre del cliente, correo electrónico, puntuación y punto principal de feedback. Formatea como JSON.”

Luego añade un ejemplo que muestre el formato. La instrucción explica la tarea. El ejemplo clava la estructura de salida. Obtienes claridad y consistencia.

Este enfoque híbrido funciona especialmente bien cuando: el formato es específico (usa el ejemplo), pero el razonamiento detrás de las decisiones importa (usa la instrucción). Ninguno de los dos, por separado, bastaría. Juntos cubren aspectos distintos de lo que necesitas.

Lo que de verdad importa

Después de toda la investigación y la experimentación, algunas cosas están claras.

Los ejemplos ayudan sobre todo con formato, consistencia y estilo. Si esas son tus prioridades, úsalos. Si tus prioridades son la calidad del contenido y el razonamiento, los ejemplos pueden no ayudar e incluso perjudicar.

Dos o tres ejemplos suelen ser suficientes. Más que eso rara vez aporta valor y puede añadir ruido. La investigación de PromptHub muestra que los rendimientos decrecientes aparecen rápido.

Prueba en tu tarea real, con tu modelo real. Los promedios de la investigación esconden variaciones enormes. Lo que funciona para codificación médica puede no funcionar para texto publicitario.

Y observa qué pasa cuando los modelos se actualizan. Tus ejemplos optimizados con cuidado pueden necesitar recalibración. El mejor prompt few-shot del mes pasado puede ser promedio hoy.

Si te llevas una sola idea, que sea esta: la diferencia entre zero-shot y few-shot no va de qué técnica es “mejor”. Va de si la coincidencia de patrones o el razonamiento sirven a tu tarea. A veces quieres que la IA copie una estructura. A veces quieres que piense. Saber cuál es cuál lo es todo.