Alguien probablemente te dijo que el aprendizaje profundo es solo un tipo más sofisticado de aprendizaje automático, que a su vez es un subconjunto de la IA. Esa explicación es técnicamente correcta y completamente inútil, porque no te dice nada sobre cuándo importa la distinción, por qué estos términos se mezclan y se destrozan en el texto publicitario, o qué significa todo esto para las herramientas abiertas ahora mismo en las pestañas de tu navegador.

Déjame intentarlo de otra manera.

Empieza por lo que no son

La IA no es una tecnología concreta. Nunca lo fue.

El término “inteligencia artificial” se remonta a 1956, cuando un grupo de investigadores en Dartmouth quería un nombre pegadizo para su taller de verano sobre hacer que las máquinas piensen. Antes de que ese taller terminara, el campo ya tenía su marca. Todo lo que vino después y hacía que los ordenadores parecieran inteligentes se metió bajo la misma etiqueta, sin importar cómo funcionara.

Por eso un programa de ajedrez de 1997, un filtro de spam de 2005 y ChatGPT en 2026 cuentan como “IA”. Técnicamente casi no tienen nada en común. El paraguas es así de enorme.

El aprendizaje automático es más estrecho. Mucho más estrecho. Describe sistemas que mejoran por exposición a datos en lugar de por programación explícita. Una persona escribe el algoritmo general de aprendizaje. Los datos hacen la enseñanza. Esta diferencia suena académica hasta que te das cuenta de que decide si una herramienta puede adaptarse a tu situación específica o si queda atada a reglas que alguien dejó cableadas hace años.

El aprendizaje profundo es todavía más estrecho. Redes neuronales. Múltiples capas. Patrones que emergen de patrones que emergen de patrones. Lo de “profundo” se refiere a la profundidad de la red, no a una profundidad filosófica.

La confusión tiene un origen

Los especialistas en marketing descubrieron que “IA” suena más impresionante que “algoritmo”.

Pasó poco a poco. Un motor de recomendaciones se convirtió en un “sistema de personalización impulsado por IA”. Un chatbot basado en reglas se convirtió en un “asistente de IA”. Un paquete de estadística se convirtió en “analítica predictiva con IA”. El significado técnico se fue drenando mientras el valor comercial se inflaba.

Como lo dijo un comentarista de Hacker News al hablar de la terminología del aprendizaje automático: “machine learning is a particular model set atop the edifice of statistics mixed with coding.” La realidad práctica es menos glamorosa de lo que sugiere el branding.

Esto no es necesariamente deshonesto. Las definiciones sí son difusas en los bordes. Pero te crea problemas cuando intentas evaluar herramientas o entender capacidades. Algo etiquetado como “IA” puede ser cualquier cosa: desde una tabla de búsqueda hasta GPT-4.

Cómo aprende de verdad el aprendizaje automático

Digamos que tienes diez mil correos, cada uno etiquetado como spam o legítimo. Un algoritmo de aprendizaje automático examina estos ejemplos y encuentra patrones que separan las dos categorías. Tal vez los correos spam tienden a tener ciertas combinaciones de palabras, dominios de remitente raros o manías específicas de formato.

El algoritmo identifica estos patrones por sí mismo. Una persona aporta los datos etiquetados y elige el método de aprendizaje, pero no le especifica que “DINERO GRATIS” en el asunto se correlaciona con spam. El algoritmo lo detecta a partir de los ejemplos.

Una vez entrenado, el modelo puede examinar correos nuevos que nunca ha visto y hacer predicciones. No porque alguien programara una regla sobre “DINERO GRATIS”, sino porque el modelo aprendió ese patrón a partir de datos.

Esto es aprendizaje supervisado. Tú aportas ejemplos etiquetados. El algoritmo aprende a predecir etiquetas para casos nuevos.

El aprendizaje no supervisado se salta las etiquetas. Le das datos al algoritmo y dejas que encuentre estructura por su cuenta. Segmentos de clientes que no sabías que existían. Anomalías que no encajan con ningún patrón normal. Grupos que revelan similitudes ocultas.

El aprendizaje por refuerzo añade prueba y error. El sistema toma acciones, recibe retroalimentación sobre si esas acciones fueron buenas o malas, y poco a poco descubre qué estrategias funcionan. Esto impulsa IA que juega a juegos y algunas aplicaciones de robótica.

La idea central en los tres: el sistema mejora a partir de la experiencia, no a base de más programación.

Dónde se separa el aprendizaje profundo

El aprendizaje automático tradicional exige que una persona identifique características relevantes. ¿Quieres clasificar imágenes de gatos y perros? Alguien tiene que decidir que importan la forma de las orejas, la textura del pelaje y las proporciones del cuerpo. Esta ingeniería de características requiere experiencia, tiempo y conocimiento del dominio.

El aprendizaje profundo elimina ese paso.

Una red neuronal con suficientes capas puede descubrir por sí misma qué características importan. Muéstrale millones de imágenes de gatos y perros con etiquetas. La red aprende que ciertos patrones de bajo nivel como bordes y texturas se combinan en patrones de nivel medio como ojos y orejas, que se combinan en patrones de alto nivel como “golden retriever” o “gato atigrado”.

Nadie especifica que los bordes importan. La red lo descubre.

Por eso el aprendizaje profundo domina todo lo que involucra datos no estructurados. Imágenes. Audio. Vídeo. Lenguaje natural. Las características que distinguen un sentimiento positivo de uno negativo en texto, o una voz de otra en audio, son sutiles y difíciles de definir de forma explícita. El aprendizaje profundo las encuentra igual.

El coste es el dato. El aprendizaje profundo necesita muchísimos más ejemplos para entrenar con eficacia. Donde el aprendizaje automático tradicional puede funcionar con cientos o miles de muestras, el aprendizaje profundo suele requerir millones. Y los requisitos de cómputo son, en consecuencia, enormes.

La parte que la gente olvida

En un hilo de Hacker News sobre las limitaciones del aprendizaje profundo, el investigador y exdirector de IA en Tesla Andrej Karpathy (vía el usuario daddyo) hizo una observación que atraviesa el humo: “I haven’t found a way to properly articulate this yet but somehow everything we do in deep learning is memorization (interpolation, pattern recognition, etc) instead of thinking.”

Esto importa más de lo que la mayoría de las conversaciones admite.

El aprendizaje profundo encuentra patrones. Empareja entradas con salidas basándose en datos de entrenamiento. No razona sobre el mundo. No entiende la causalidad. No sabe por qué nada es verdad.

Otro comentarista en el mismo hilo, dredmorbius, lo dijo sin rodeos: “Deep Learning is finding associated effects. It does not find the underlying causes. It is a mode of technical rather than scientific advance.”

Entender esto cambia cómo evalúas las promesas sobre IA. Un sistema entrenado con datos históricos reproducirá patrones de esa historia, incluidos sesgos, errores y correlaciones que ya no se sostienen. No va a preguntarse si esos patrones tienen sentido. No puede.

Cuándo encaja cada enfoque

Los sistemas basados en reglas funcionan mejor cuando el problema tiene una lógica clara que los humanos pueden especificar por completo. Cálculos de impuestos. Decisiones de enrutamiento basadas en criterios explícitos. Situaciones en las que necesitas explicar exactamente por qué ocurrió un resultado concreto.

El aprendizaje automático tradicional brilla con datos estructurados y tamaños de conjunto moderados. Predecir la fuga de clientes a partir de métricas de comportamiento. Puntuar oportunidades comerciales según atributos de la empresa. Casos en los que las características relevantes son identificables y la interpretabilidad importa.

El aprendizaje profundo se vuelve necesario para datos no estructurados a escala. Reconocimiento de imágenes. Transcripción de voz. Comprensión del lenguaje natural. Problemas en los que definir características explícitamente sería imposible o poco práctico.

Las herramientas con las que interactúas a diario se sientan en puntos distintos de este espectro. Un filtro de spam puede usar aprendizaje automático tradicional. Un motor de recomendaciones puede mezclar varios enfoques. ChatGPT y Claude usan aprendizaje profundo, específicamente redes neuronales basadas en transformers con miles de millones de parámetros.

Saber qué categoría aplica te ayuda a hacer mejores preguntas. ¿Puede este sistema adaptarse a mis datos específicos? ¿Me explicará sus decisiones? ¿Necesita conjuntos masivos de entrenamiento, o puede trabajar con lo que tengo?

El transformer lo cambió todo

La arquitectura específica de aprendizaje profundo detrás de los asistentes de IA actuales se llama transformer. Antes de 2017, los modelos de lenguaje procesaban palabras de forma secuencial, una a la vez. Eso los hacía lentos de entrenar y malos conectando ideas separadas por muchas palabras.

Los transformers introdujeron la autoatención: la capacidad de comparar cada palabra con todas las demás al mismo tiempo. Este procesamiento en paralelo hizo el entrenamiento más rápido y capturó relaciones de largo alcance que los enfoques anteriores se perdían.

GPT, Claude, Gemini, Llama. Todos construidos sobre transformers. También lo están los generadores de imágenes como DALL-E y los generadores de vídeo como Sora. Una innovación arquitectónica, publicada en un artículo titulado “Attention is All You Need”, desbloqueó casi todo lo que la gente hoy llama “IA” en una conversación casual.

No necesitas entender las matemáticas. Lo importante es reconocer que estos sistemas comparten una base común, lo que explica tanto sus capacidades como sus limitaciones. Se les da muy bien el reconocimiento de patrones porque los transformers son muy buenos encontrando patrones en secuencias largas. Se les da mal el razonamiento fiable porque el reconocimiento de patrones no es razonar.

El problema de la caja negra

Con un árbol de decisión o una regresión lineal, puedes rastrear exactamente por qué una predicción salió como salió. La ratio deuda-ingresos superó el umbral. El cliente no había iniciado sesión en 90 días. Claro, auditable, defendible.

Los modelos de aprendizaje profundo se resisten a este tipo de explicación. Millones de parámetros interactúan de formas que se resisten a la interpretación humana. Ves entradas y salidas. El medio es opaco.

Esto crea problemas reales en sectores regulados. Salud, finanzas, crédito. Los reguladores quieren saber por qué se tomó una decisión. “La red neuronal dio una puntuación alta” no es una respuesta aceptable.

La investigación sobre IA explicable continúa, pero el intercambio se mantiene. Los modelos más capaces tienden a ser los menos interpretables.

Qué significa esto para las herramientas que usas

Cuando escribes en ChatGPT o Claude, estás usando aprendizaje profundo. En concreto, estás usando un modelo de lenguaje grande basado en arquitectura transformer, entrenado con cientos de miles de millones de ejemplos de texto.

Esto explica comportamientos que, de otro modo, podrían parecer aleatorios o rotos.

Estos modelos son excelentes reconociendo patrones. Han visto cantidades enormes de texto y han aprendido qué patrones siguen a cuáles. Por eso pueden escribir en estilos distintos, traducir idiomas y generar código que de verdad corre.

No verifican la verdad. Como se explica en el artículo sobre por qué la IA se inventa cosas, los LLM predicen qué texto debería venir después según patrones. Que ese texto sea o no sea correcto en términos factuales es otra pregunta que no pueden responder desde dentro.

Los límites de contexto son reales. Tokens y ventanas de contexto limitan cuánta información puede procesar el modelo de forma simultánea. Es una restricción de arquitectura, no un fallo temporal esperando un arreglo.

La forma en que formulas el prompt afecta las salidas porque el modelo está haciendo coincidir patrones contra tu entrada. Diferentes entradas activan diferentes patrones. Por eso el diseño de prompts importa y por eso cambios pequeños en el texto pueden producir resultados dramáticamente distintos.

El mercado ya decidió

El aprendizaje automático no es una tecnología experimental. El 72% de las empresas de EE. UU. reporta que el aprendizaje automático es operación estándar de TI, no solo I+D. El mercado estuvo en algún punto entre $72 y $97 mil millones en 2024, según cómo lo midas, con proyecciones de crecimiento que muestran aumentos anuales del 30-35% hasta principios de la década de 2030.

El mercado laboral lo refleja. Los puestos de ingeniero/a de aprendizaje automático pagan una compensación total mediana de alrededor de $158.000 en EE. UU. El Foro Económico Mundial proyecta que los empleos de especialistas en IA y aprendizaje automático crecerán más de un 80% entre 2025 y 2030.

Estos números importan porque indican hacia dónde fluye la inversión. Las herramientas disponibles hoy van a mejorar. Los costes van a bajar. Las preguntas pasan de “si adoptar” a “cómo adoptar bien”.

Lo que sigue siendo cierto

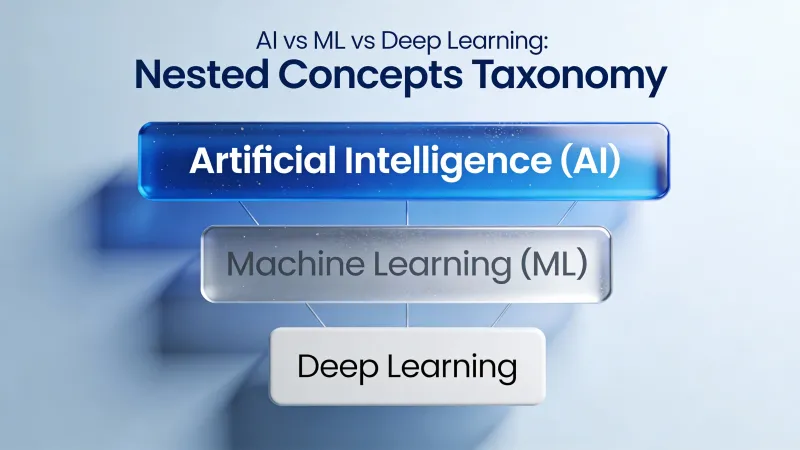

IA, aprendizaje automático y aprendizaje profundo describen categorías anidadas. La IA es la más amplia y cubre cualquier cosa que imite un comportamiento inteligente. El aprendizaje automático acota a sistemas que aprenden de datos. El aprendizaje profundo acota aún más a redes neuronales que aprenden sus propias características.

Pero la terminología importa menos que entender capacidades. ¿Qué puede hacer de verdad esta herramienta específica? ¿Aprende de datos nuevos o sigue reglas fijas? ¿Puede explicar sus decisiones? ¿Necesita conjuntos masivos de datos o funciona con lo que tienes?

El proveedor probablemente llama a todo “IA”. Esa etiqueta no te dice casi nada. La tecnología subyacente te dice casi todo.

El momento actual en IA se siente significativo porque el aprendizaje profundo, específicamente los modelos de lenguaje basados en transformers, resolvió problemas que enfoques anteriores no podían tocar. Comprensión del lenguaje natural. Generación de imágenes. Síntesis de código. Estos avances son reales.

Lo que no son es pensamiento. El reconocimiento de patrones a escala parece inteligencia. A veces es útil. De vez en cuando es transformador. Pero opera con principios fundamentalmente distintos a la cognición humana, y entender esa diferencia es todo el juego.