Todo el mundo quiere personalizar la IA. Pocos entienden sus opciones.

Tienes documentos de la empresa que el modelo nunca ha visto, un estilo de escritura específico que ignora, o conocimiento de dominio que sigue “alucinando”, y quieres una IA que de verdad funcione para tu caso en vez de producir una salida genérica que no da en el blanco.

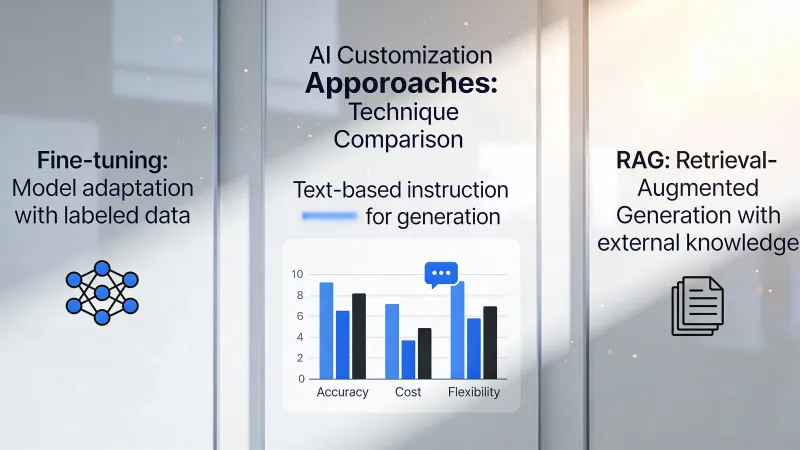

Hay tres caminos: prompting, RAG y ajuste fino. La industria los trata como una escalera en la que subes de lo simple a lo sofisticado, pero ese marco provoca errores caros porque cada enfoque resuelve problemas fundamentalmente distintos, y elegir por complejidad percibida en lugar de por encaje real desperdicia tanto tiempo como dinero.

La verdad incómoda sobre el ajuste fino

Empecemos por la opción que suena más impresionante.

El ajuste fino cambia el propio modelo. Le das ejemplos de entrada y de la salida deseada, y el proceso de entrenamiento ajusta los pesos internos del modelo para producir ese tipo de salida con más consistencia, básicamente enseñándole nuevos comportamientos mediante exposición repetida a tus patrones específicos.

Suena potente. Lo es.

Y aun así, casi nunca es lo que necesitas.

En Hacker News, intellectronica lo dijo sin rodeos: “Fine-tuning is super important and powerful…in reality for most use cases it offers little advantage for a lot of effort.” Esa valoración se sigue confirmando en despliegues reales, donde equipos pasan meses preparando datos de entrenamiento solo para descubrir que unos buenos prompts habrían resuelto el problema en una tarde.

El malentendido es profundo. La gente asume que el ajuste fino le enseña datos nuevos al modelo, como estudiar le enseña a los humanos, pero dvt en Hacker News lo cuestionó de frente: “It does not teach the model new knowledge.” El ajuste fino cambia el comportamiento y el estilo, no el conocimiento subyacente al que el modelo puede acceder, lo que significa que si tu problema es que el modelo no conoce los productos o políticas de tu empresa, el ajuste fino no lo arreglará.

Donde el ajuste fino brilla es en la consistencia. Si necesitas un modelo que devuelva JSON perfectamente formateado todas y cada una de las veces, o que mantenga un tono exacto a lo largo de miles de interacciones, o que ejecute una tarea estrecha con fiabilidad de máquina, el ajuste fino ofrece lo que los prompts no pueden.

El costo hace que esta decisión sea seria. Las ejecuciones de entrenamiento van desde cientos de dólares para modelos pequeños hasta decenas de miles para cualquier cosa sustancial. La preparación de datos suele duplicar la inversión total porque necesitas ejemplos de alta calidad en el formato exacto que espera la canalización de entrenamiento. ¿Y cuando cambian tus requisitos? Entrenas de nuevo.

Por qué RAG suele ganar

Esto es lo que la mayoría de los equipos necesita de verdad: una IA que sepa sobre sus cosas.

RAG funciona distinto. En lugar de cambiar el modelo, construyes un sistema de recuperación que encuentra documentos relevantes cuando un usuario pregunta algo, y luego incluyes esos documentos en el prompt para que el modelo tenga la información que necesita para responder con precisión.

El modelo sigue siendo genérico. El conocimiento se mantiene externo.

Esta diferencia importa muchísimo. Cuando cambia la documentación de tu producto, actualizas los documentos y RAG empieza a usar la información nueva de inmediato. Sin reentrenamiento. Sin equipo de ciencia de datos. Solo actualiza tus archivos.

Un profesional en Hacker News describió el intercambio así: “RAG is focused more on capturing and using external resources on an ad hoc basis, where fine tuning looks to embed a specific ‘behaviour’ change in the model for a particular need.” Lo clava. RAG se encarga del qué. El ajuste fino, del cómo.

El argumento de la transparencia también es contundente. Cuando RAG da una respuesta, puedes rastrearla hasta documentos fuente concretos, lo que significa que puedes auditar respuestas, detectar alucinaciones y mostrar a los usuarios de dónde salió la información. Los modelos ajustados con fine-tuning no ofrecen ese rastro.

Las comparaciones de costos favorecen claramente a RAG. Montar una base de datos vectorial y una canalización de embeddings cuesta entre $200 y $2.000 al mes en implementaciones típicas. Ajustar bien con fine-tuning un modelo de producción cuesta eso solo en cómputo de entrenamiento, antes de contar la preparación de datos y el mantenimiento continuo.

Pero RAG tiene límites. Requiere que existan documentos relevantes. El paso de recuperación añade latencia. Los documentos largos tensionan las ventanas de contexto. Y, de forma crítica, RAG no puede cambiar cómo razona o escribe el modelo.

Prompting no es la opción para principiantes

Presentar el prompting como el primer escalón de una escalera minimiza su poder real.

La ingeniería de prompts consiste en redactar instrucciones que guían el comportamiento del modelo sin modificar nada externo. Trabajas por completo dentro de la conversación. Sin infraestructura. Sin datos de entrenamiento. Sin bases de datos vectoriales.

Suena simple. Esa es la trampa.

La ingeniería de prompts sofisticada incluye marcos de razonamiento estructurado, ejemplos few-shot que demuestran patrones exactos, desgloses de cadena de pensamiento para tareas complejas y una especificación cuidadosa de restricciones que moldea las salidas sin reglas explícitas. Los equipos que desprecian el prompting como algo básico a menudo no han explorado lo que es posible cuando inviertes esfuerzo real en ello.

adamgordonbell compartió una experiencia reveladora: “When I first wanted to tackle a hard problem I thought to reach for fine-tuning with lots of input and output pairs, but it wasn’t needed.” Ese patrón se repite constantemente. Los ingenieros asumen que la complejidad exige soluciones complejas, y luego descubren que unos buenos prompts resuelven el problema de forma más elegante.

La estructura de costos hace que valga la pena invertir en prompting. Horas de iteración de prompts no cuestan nada más allá de las cuotas de suscripción. Si puedes resolver un problema solo con prompts, te ahorras la infraestructura por completo, lo que significa ciclos de iteración más rápidos, mantenimiento más simple y menos riesgo cuando cambian los requisitos.

Pero la limitación es real. Los prompts solo pueden moldear el comportamiento dentro de lo que el modelo ya sabe hacer. No puedes “forzar con prompts” a un modelo a entender conceptos con los que nunca se encontró durante el entrenamiento, y no puedes “forzar con prompts” el acceso a información que el modelo no tiene.

La decisión que de verdad importa

Deja de preguntar cuál es mejor. Pregunta cuál es tu problema real.

El modelo da datos equivocados sobre tu empresa, tus productos o eventos recientes. Eso es un problema de conocimiento. RAG resuelve problemas de conocimiento dándole al modelo la información que le falta en el momento de la consulta.

El modelo sabe la información correcta, pero produce salidas en formatos incorrectos, estilos incorrectos o con una calidad inconsistente entre interacciones. Eso es un problema de comportamiento. El ajuste fino resuelve problemas de comportamiento ajustando cómo genera respuestas el modelo.

El modelo podría hacer lo que quieres, pero no lo hace porque tus instrucciones no son lo bastante claras. Eso es un problema de instrucciones. La ingeniería de prompts resuelve problemas de instrucciones dando mejor guía dentro de la conversación.

La mayoría de los equipos mezcla estas categorías. Tienen un problema de conocimiento, pero asumen que el ajuste fino enseñará conocimiento nuevo. Tienen un problema de instrucciones, pero asumen que RAG aportará instrucciones. Emparejar la solución con el problema real ahorra meses de esfuerzo desperdiciado.

El terreno intermedio peligroso

A veces el problema cruza categorías. Necesitas conocimiento de la empresa Y un formato consistente Y patrones de razonamiento específicos.

Aquí aparecen las arquitecturas combinadas. RAG aporta información actual. El ajuste fino garantiza una estructura de salida consistente. Los prompts dan guía específica para cada consulta. Los tres trabajando juntos.

phillipcarter en Hacker News advirtió contra los falsos dilemas: “Fine-tuning doesn’t eliminate the need for RAG, and RAG doesn’t obviate the need for fine-tuning either.”

Pero las combinaciones multiplican la complejidad. Tres sistemas que mantener. Tres posibles puntos de fallo. Tres conjuntos de costos. Construye combinaciones solo cuando los enfoques individuales fallen de forma demostrable, no como cobertura ante problemas hipotéticos.

Los equipos de IA más sofisticados tratan esto como lógica de enrutamiento. Las consultas simples se resuelven solo con prompts. Las consultas intensivas en conocimiento activan RAG. Las operaciones de alto valor y críticas por formato pasan por modelos ajustados con fine-tuning. El sistema decide qué camino toma cada solicitud.

Esa arquitectura requiere mucha ingeniería. La mayoría de los equipos no la necesita. La mayoría de los equipos necesita elegir un enfoque y ejecutarlo bien.

Lo que el mercado aprendió a la mala

Los primeros despliegues de IA en empresas tendían al ajuste fino por defecto porque parecía más sustancial, más defendible en presentaciones ejecutivas, más claramente distinto a “solo usar ChatGPT”. A menudo esos despliegues se estancaban durante fases de preparación de datos que se alargaban durante meses.

solidasparagus resumió la realidad práctica: “collecting data and then fine-tuning models is orders of magnitude more complex than just throwing in RAG.”

La complejidad no es solo técnica. El ajuste fino requiere conjuntos de datos curados que representen tu caso de uso con precisión, lo que significa definir cómo se ve una buena salida, reunir suficientes ejemplos, formatearlos correctamente y validar que el conjunto de entrenamiento no contenga errores que se propaguen al modelo. RAG requiere subir documentos que probablemente ya tienes.

Esto no quiere decir que el ajuste fino nunca sea lo correcto. Empresas que ejecutan millones de consultas similares al día pueden ajustar modelos más pequeños que corren más rápido y más barato que los modelos generales grandes. Dominios especializados con terminología y patrones de razonamiento únicos a veces requieren cambios de comportamiento que los prompts no logran. Aplicaciones sensibles a la latencia se benefician de modelos pequeños ajustados con fine-tuning frente a modelos más grandes con prompting.

Pero el umbral es alto. Necesitas volumen para justificar la inversión. Necesitas requisitos de comportamiento claros que no cambien con frecuencia. Necesitas datos de entrenamiento de calidad o presupuesto para crearlos. Y necesitas paciencia para un ciclo de iteración que se mide en semanas, no en horas.

La opción infravalorada

Para muchas aplicaciones de negocio, la respuesta es más simple que cualquiera de estas.

Usa el modelo tal cual con prompts decentes. Acepta cierta imperfección. Lanza algo.

La búsqueda de una personalización perfecta de la IA retrasa el valor real. Los equipos pasan meses en arquitecturas de RAG cuando una plantilla de prompts y una revisión manual servirían mejor a sus usuarios reales a corto plazo.

Esto no significa conformarse para siempre. Significa secuenciar bien: demuestra que el concepto funciona con enfoques simples primero, identifica huecos concretos con el uso real y luego invierte en la personalización que cierre esos huecos concretos.

Empezar con ajuste fino antes de validar el caso de uso es como optimizar código antes de saber si es el código correcto. El esfuerzo puede desperdiciarse en un problema que no existe, o que cambia a medida que aprendes más sobre lo que de verdad necesitan tus usuarios.

Puntos de partida prácticos

Si tu problema es de conocimiento, empieza con RAG. Mete tus documentos en un almacén de vectores, integra la recuperación en tus prompts y mira si el modelo produce respuestas correctas cuando tiene la información adecuada disponible.

Si tu problema es de consistencia, empieza con prompts detallados que incluyan ejemplos. Enséñale al modelo exactamente lo que quieres con muestras anotadas. La mayoría de los problemas de consistencia cede ante prompting con pocos ejemplos antes de requerir ajuste fino.

Si tu problema es de capacidad, es decir, si el modelo fundamentalmente no puede hacer la tarea, cuestiona si la IA es la solución adecuada. El ajuste fino puede ampliar capacidades en los márgenes, pero no puede transformar un modelo de lenguaje en algo para lo que no fue diseñado.

Si no estás seguro de cuál es tu problema, ese es el problema real. Dedica tiempo a caracterizar los fallos antes de invertir en soluciones. Habla con usuarios. Mira las salidas malas. Entiende específicamente qué salió mal y por qué antes de decidir cómo arreglarlo.

Los equipos que triunfan al personalizar IA comparten un rasgo: definen el problema con precisión antes de seleccionar la solución, y luego validan su elección con una inversión mínima antes de escalar el enfoque a su organización.

Los equipos que tienen problemas saltan a soluciones que suenan sofisticadas sin entender lo bastante el problema como para saber si esa sofisticación está justificada.

Empieza simple. Añade complejidad solo cuando lo simple falle de forma demostrable.

Ese no es un consejo emocionante. Pero es el consejo que funciona.