Quelqu’un vous a probablement dit que l’apprentissage profond est juste une version sophistiquée de l’apprentissage automatique, qui lui-même est un sous-ensemble de l’IA. Cette explication est techniquement correcte et complètement inutile, parce qu’elle ne vous dit rien sur quand la distinction compte, pourquoi ces termes se retrouvent triturés dans du texte publicitaire, ni ce que tout ça signifie pour les outils ouverts dans vos onglets, là, maintenant.

Essayons autrement.

Commencez par ce qu’ils ne sont pas

L’IA n’est pas une technologie précise. Ça ne l’a jamais été.

Le terme « intelligence artificielle » date de 1956, quand un groupe de chercheurs à Dartmouth voulait un nom accrocheur pour son atelier d’été sur la façon de faire penser des machines. Avant même la fin de l’atelier, le domaine avait sa marque. Tout ce qui, ensuite, faisait paraître les ordinateurs « intelligents » a été rangé sous la même étiquette, quelle que soit la manière dont ça fonctionnait.

C’est pour ça qu’un programme d’échecs de 1997, un filtre anti-spam de 2005 et ChatGPT en 2026 comptent tous comme de « l’IA ». Techniquement, ils n’ont presque rien en commun. Le parapluie est aussi large que ça.

L’apprentissage automatique est plus étroit. Beaucoup plus étroit. Il décrit des systèmes qui s’améliorent en étant exposés à des données plutôt que par une programmation explicite. Un humain écrit l’algorithme d’apprentissage général. Les données font le travail d’enseignant. Cette différence a l’air académique jusqu’au moment où vous réalisez qu’elle détermine si un outil peut s’adapter à votre situation précise, ou s’il est bloqué sur des règles que quelqu’un a câblées en dur il y a des années.

L’apprentissage profond est encore plus étroit. Des réseaux de neurones. Plusieurs couches. Des motifs qui émergent de motifs qui émergent de motifs. Le « profond » renvoie à la profondeur du réseau, pas à une profondeur philosophique.

La confusion a une source

Les équipes marketing ont découvert que « IA » sonne plus impressionnant que « algorithme ».

Ça s’est fait progressivement. Un moteur de recommandation est devenu un « système de personnalisation propulsé par l’IA ». Un chatbot à base de règles est devenu un « assistant IA ». Un logiciel de statistiques est devenu de « l’analytique prédictive IA ». Le sens technique s’est évaporé pendant que la valeur marketing gonflait.

Comme l’a formulé un commentateur sur Hacker News en parlant de la terminologie du machine learning : “machine learning is a particular model set atop the edifice of statistics mixed with coding.” Dans la pratique, c’est moins glamour que ce que la marque laisse entendre.

Ce n’est pas forcément malhonnête. Les définitions sont réellement floues sur les bords. Mais ça crée des problèmes quand vous essayez d’évaluer des outils ou de comprendre des capacités. Un truc étiqueté « IA » peut aller d’une simple table de correspondance à GPT-4.

Comment l’apprentissage automatique apprend vraiment

Imaginez que vous avez dix mille emails, chacun étiqueté spam ou légitime. Un algorithme d’apprentissage automatique examine ces exemples et repère des motifs qui séparent les deux catégories. Peut-être que les spams ont tendance à contenir certaines combinaisons de mots, des domaines d’expéditeur inhabituels, ou des bizarreries de mise en forme.

L’algorithme identifie ces motifs tout seul. Un humain fournit les données étiquetées et choisit la méthode d’apprentissage, mais il ne spécifie pas que « ARGENT GRATUIT » dans l’objet corrèle avec du spam. L’algorithme le remarque à partir des exemples.

Une fois entraîné, le modèle peut examiner de nouveaux emails qu’il n’a jamais vus et faire des prédictions. Pas parce que quelqu’un a programmé une règle sur « ARGENT GRATUIT », mais parce que le modèle a appris ce motif à partir des données.

C’est l’apprentissage supervisé. Vous fournissez des exemples étiquetés. L’algorithme apprend à prédire les étiquettes pour de nouveaux cas.

L’apprentissage non supervisé saute l’étape des étiquettes. Vous donnez des données à l’algorithme et vous le laissez trouver de la structure par lui-même. Des segments clients que vous ne saviez pas qu’ils existaient. Des anomalies qui ne ressemblent à aucun motif normal. Des groupes qui révèlent des similarités cachées.

L’apprentissage par renforcement ajoute l’essai-erreur. Le système prend des actions, reçoit un retour indiquant si ces actions étaient bonnes ou mauvaises, et finit progressivement par comprendre quelles stratégies fonctionnent. C’est ce qui alimente des IA de jeu et certaines applications en robotique.

L’idée centrale, dans les trois cas : le système s’améliore par l’expérience plutôt que par encore plus de programmation.

Où l’apprentissage profond se distingue

L’apprentissage automatique « classique » exige qu’un humain identifie les caractéristiques pertinentes. Vous voulez classer des images de chats et de chiens ? Quelqu’un doit décider que la forme des oreilles, la texture du pelage et les proportions du corps comptent. Cette ingénierie des caractéristiques demande de l’expertise, du temps et des connaissances métier.

L’apprentissage profond supprime cette étape.

Un réseau de neurones avec suffisamment de couches peut déterminer tout seul quelles caractéristiques importent. Montrez-lui des millions d’images de chats et de chiens avec des étiquettes. Le réseau apprend que certains motifs de bas niveau, comme les contours et les textures, se combinent en motifs de niveau intermédiaire comme les yeux et les oreilles, qui se combinent en motifs de haut niveau comme « golden retriever » ou « chat tigré ».

Personne ne précise que les contours comptent. Le réseau le découvre.

C’est pour ça que l’apprentissage profond domine tout ce qui implique des données non structurées. Images. Audio. Vidéo. Langage naturel. Les caractéristiques qui distinguent un sentiment positif d’un sentiment négatif dans du texte, ou une voix d’une autre dans de l’audio, sont subtiles et difficiles à définir explicitement. L’apprentissage profond les trouve quand même.

Le coût, ce sont les données. L’apprentissage profond a besoin de bien plus d’exemples pour s’entraîner efficacement. Là où le ML traditionnel peut fonctionner avec des centaines ou des milliers d’échantillons, l’apprentissage profond nécessite souvent des millions. Et la puissance de calcul requise est, à l’avenant, massive.

La partie que tout le monde oublie

Dans un fil Hacker News sur les limites de l’apprentissage profond, le chercheur et ancien directeur IA de Tesla Andrej Karpathy (via l’utilisateur daddyo) a fait une observation qui coupe à travers le battage : “I haven’t found a way to properly articulate this yet but somehow everything we do in deep learning is memorization (interpolation, pattern recognition, etc) instead of thinking.”

Ça compte plus que la plupart des discussions ne l’admettent.

L’apprentissage profond repère des motifs. Il associe des entrées à des sorties à partir de données d’entraînement. Il ne raisonne pas sur le monde. Il ne comprend pas la causalité. Il ne sait pas pourquoi quelque chose est vrai.

Un autre commentateur dans le même fil, dredmorbius, l’a formulé sans détour : “Deep Learning is finding associated effects. It does not find the underlying causes. It is a mode of technical rather than scientific advance.”

Comprendre ça change la manière dont vous évaluez les promesses autour de l’IA. Un système entraîné sur des données historiques va reproduire les motifs de cette histoire, y compris des biais, des erreurs et des corrélations qui ne tiennent plus. Il ne se demandera pas si ces motifs ont du sens. Il ne le peut pas.

Quand chaque approche a du sens

Les systèmes à base de règles marchent le mieux quand le problème a une logique claire que les humains peuvent spécifier complètement. Calculs d’impôts. Décisions d’acheminement basées sur des critères explicites. Situations où vous devez expliquer exactement pourquoi un résultat particulier est arrivé.

L’apprentissage automatique classique brille avec des données structurées et des tailles d’ensemble de données modérées. Prédire le churn client à partir de métriques comportementales. Noter des prospects à partir d’attributs d’entreprise. Des cas où les caractéristiques pertinentes sont identifiables et où l’interprétabilité compte.

L’apprentissage profond devient nécessaire pour des données non structurées à grande échelle. Reconnaissance d’images. Transcription de la parole. Compréhension du langage naturel. Des problèmes où définir explicitement des caractéristiques serait impossible ou impraticable.

Les outils avec lesquels vous interagissez tous les jours se situent à différents endroits de ce spectre. Un filtre anti-spam peut utiliser du ML classique. Un moteur de recommandation peut mélanger plusieurs approches. ChatGPT et Claude utilisent l’apprentissage profond, plus précisément des réseaux de neurones de type transformer avec des milliards de paramètres.

Savoir quelle catégorie s’applique vous aide à poser de meilleures questions. Ce système peut-il s’adapter à mes données à moi ? Va-t-il expliquer ses décisions ? A-t-il besoin d’ensembles d’entraînement gigantesques, ou peut-il fonctionner avec ce que j’ai ?

Le transformer a tout changé

L’architecture d’apprentissage profond spécifique derrière les assistants IA actuels s’appelle le transformer. Avant 2017, les modèles de langage traitaient les mots de manière séquentielle, un par un. Ça les rendait lents à entraîner et mauvais pour relier des idées séparées par beaucoup de mots.

Les transformers ont introduit l’auto-attention : la capacité de comparer chaque mot à tous les autres simultanément. Ce traitement parallèle a accéléré l’entraînement et capturé des relations à longue portée que les approches précédentes rataient.

GPT, Claude, Gemini, Llama. Tous basés sur des transformers. Idem pour des générateurs d’images comme DALL-E et des générateurs de vidéo comme Sora. Une innovation d’architecture, publiée dans un article intitulé “Attention is All You Need”, a débloqué presque tout ce que les gens appellent maintenant « l’IA » dans une conversation courante.

Vous n’avez pas besoin de comprendre les maths. Ce qui compte, c’est de reconnaître que ces systèmes partagent un socle commun, ce qui explique à la fois leurs capacités et leurs limites. Ils excellent à reconnaître des motifs parce que les transformers excellent à trouver des motifs dans de longues séquences. Ils peinent à raisonner de façon fiable parce que la reconnaissance de motifs n’est pas du raisonnement.

Le problème de la boîte noire

Avec un arbre de décision ou une régression linéaire, vous pouvez retracer exactement pourquoi une prédiction est sortie comme elle est sortie. Le ratio dette/revenu a dépassé le seuil. Le client ne s’était pas connecté depuis 90 jours. Clair, auditable, défendable.

Les modèles d’apprentissage profond résistent à ce genre d’explication. Des millions de paramètres interagissent d’une manière qui résiste à l’interprétation humaine. Vous voyez des entrées et des sorties. Le milieu est opaque.

Ça crée de vrais problèmes dans les secteurs réglementés. Santé, finance, crédit. Les régulateurs veulent savoir pourquoi une décision a été prise. « Le réseau de neurones a sorti un score élevé » n’est pas une réponse acceptable.

La recherche sur l’IA explicable continue, mais l’arbitrage reste. Les modèles les plus capables ont tendance à être les moins interprétables.

Ce que ça change pour les outils que vous utilisez

Quand vous tapez dans ChatGPT ou Claude, vous utilisez de l’apprentissage profond. Plus précisément, vous utilisez un grand modèle de langage construit sur une architecture transformer, entraîné sur des centaines de milliards d’exemples de texte.

Ça explique des comportements qui pourraient autrement sembler aléatoires ou cassés.

Ces modèles sont excellents pour repérer des motifs. Ils ont vu des quantités immenses de texte et appris quels motifs suivent quels autres motifs. C’est pour ça qu’ils peuvent écrire dans différents styles, traduire des langues et générer du code qui tourne réellement.

Ils ne vérifient pas la vérité. Comme expliqué dans l’article sur pourquoi l’IA invente des choses, les LLM prédisent quel texte devrait venir ensuite à partir de motifs. Que ce texte soit factuellement exact est une question séparée à laquelle ils ne peuvent pas répondre de l’intérieur.

Les limites de contexte sont réelles. Jetons et fenêtres de contexte limitent la quantité d’information que le modèle peut traiter simultanément. C’est une contrainte d’architecture, pas un bug temporaire qui attend un correctif.

La formulation de vos instructions change les sorties parce que le modèle met en correspondance des motifs avec votre entrée. Des entrées différentes activent des motifs différents. C’est pour ça que l’ingénierie de prompts compte, et pourquoi de petits changements de formulation peuvent produire des résultats radicalement différents.

Le marché a déjà tranché

L’apprentissage automatique n’est pas une technologie expérimentale. Soixante-douze pour cent des entreprises américaines déclarent que le ML fait partie des opérations informatiques standard, pas seulement de la R&D. Le marché a atteint quelque part entre $72 et $97 milliards en 2024 selon la façon dont vous le mesurez, avec des projections de croissance montrant 30-35 % d’augmentation annuelle jusqu’au début des années 2030.

Le marché de l’emploi reflète ça. Les postes d’ingénieur machine learning affichent une rémunération totale médiane autour de $158 000 aux États-Unis. Le World Economic Forum projette que les emplois de spécialistes IA et ML augmenteront de plus de 80 % entre 2025 et 2030.

Ces chiffres comptent parce qu’ils indiquent où vont les investissements. Les outils disponibles aujourd’hui vont s’améliorer. Les coûts vont baisser. Les questions passent de « faut-il adopter » à « comment bien adopter ».

Ce qui reste vrai

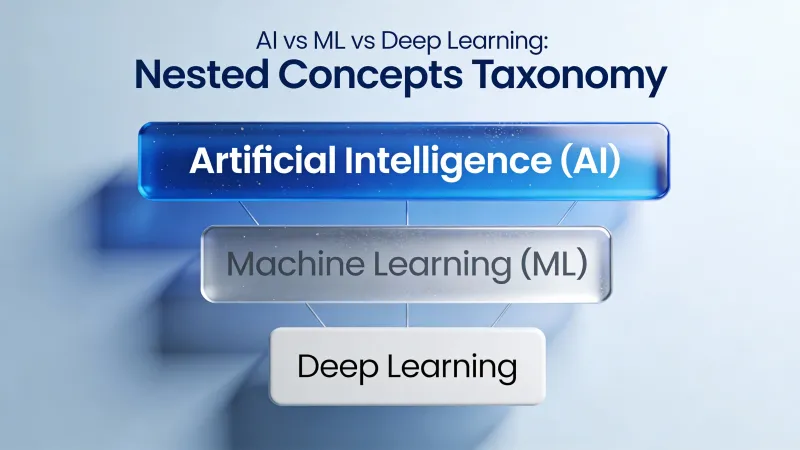

IA, apprentissage automatique et apprentissage profond décrivent des catégories imbriquées. L’IA est la plus large, couvrant tout ce qui imite un comportement intelligent. L’apprentissage automatique se resserre sur des systèmes qui apprennent à partir de données. L’apprentissage profond se resserre encore sur des réseaux de neurones qui apprennent leurs propres caractéristiques.

Mais la terminologie compte moins que la compréhension des capacités. Qu’est-ce que cet outil précis peut réellement faire ? Apprend-il à partir de nouvelles données ou suit-il des règles fixes ? Peut-il expliquer ses décisions ? A-t-il besoin d’ensembles de données massifs ou peut-il travailler avec ce que vous avez ?

Le fournisseur appellera probablement tout « IA ». Cette étiquette ne vous dit presque rien. La technologie sous-jacente, elle, vous dit presque tout.

Le moment actuel autour de l’IA paraît important parce que l’apprentissage profond, en particulier les modèles de langage à base de transformers, a cassé des problèmes que les approches précédentes ne pouvaient pas toucher. Compréhension du langage naturel. Génération d’images. Synthèse de code. Ces avancées sont réelles.

Ce qu’elles ne sont pas, c’est de la pensée. La reconnaissance de motifs à grande échelle ressemble à de l’intelligence. Parfois c’est utile. Par moments c’est transformateur. Mais ça fonctionne sur des principes fondamentalement différents de la cognition humaine — et comprendre cette différence, c’est tout le jeu.