Quelqu’un dans votre équipe a construit quelque chose avec l’IA. Peut-être une démo, peut-être une preuve de concept, peut-être juste un e-mail vraiment impressionnant qui a emballé la direction. Et maintenant, tout le monde veut savoir : est-ce qu’on peut faire ça à l’échelle de toute l’organisation ?

Réponse courte : peut-être.

Réponse longue : un paysage jonché de pilotes abandonnés, de budgets cramés, et « d’initiatives IA » qui ont été discrètement réabsorbées par les opérations normales, sans fanfare. La recherche du MIT en 2025 a constaté que 95 % des pilotes d’IA générative en entreprise n’arrivent pas à produire des retours financiers mesurables. Pas « en dessous des attentes ». Rien de mesurable. Du tout.

Cette statistique mérite qu’on s’y arrête une seconde, parce qu’elle explique l’électricité dans l’air autour de l’adoption de l’IA en ce moment. Tout le monde lance des pilotes. Presque personne n’exploite en production.

Entre la démo et le réflexe

Il existe une zone bien précise où les initiatives IA viennent mourir. Ça arrive après la phase de pilote excitante, quand une petite équipe prouve que ça marche, mais avant que l’outil s’ancre dans la façon dont les gens font réellement leur travail. Dans certains cercles de conseil, cet espace a même un nom : le purgatoire du pilote (pilot purgatory).

Le pilote marche. Il marche même très bien. Quelqu’un au marketing écrit trois mois de posts sociaux en un après-midi. Les ventes génèrent de la prospection personnalisée qui sonne vraiment personnalisée. Le juridique réduit de moitié le temps de revue des contrats.

Puis la réalité débarque.

Le champion du pilote est réaffecté sur un autre projet. L’outil a besoin d’une revue de sécurité avant de pouvoir toucher des données client. L’informatique n’a pas le budget pour l’intégrer aux systèmes existants. Les gens qui n’étaient pas dans le pilote ne savent pas s’en servir et n’ont pas le temps d’apprendre. Les managers intermédiaires sont sceptiques parce que le succès peut vouloir dire que leur équipe rétrécit.

Six mois plus tard, quelqu’un demande ce qu’il est arrivé à ce truc d’IA, et personne n’a une bonne réponse.

Pourquoi ce passage compte

Voici ce qui change quand on passe du pilote à la production : tout.

Un pilote, c’est une poignée de personnes motivées qui se sont portées volontaires pour essayer quelque chose de nouveau. Étendre, c’est embarquer tout le monde, y compris ceux qui n’ont pas levé la main, ceux qui sont sceptiques, ceux qui sont trop occupés, et ceux qui ont peur en silence.

Les pilotes fonctionnent en dehors des processus habituels. La production, c’est l’intégration dans ce système emmêlé d’autorisations, de transferts et de flux de travail que votre organisation a accumulé pendant des décennies.

Les pilotes tolèrent l’imperfection parce que ce sont des expériences. La production exige de la fiabilité parce que le travail réel des gens en dépend.

Le changement d’état d’esprit est brutal. Un commentateur sur Hacker News l’a dit sans détour : “Almost all of the Enterprise/Corporate AI offerings are a significant step in cost that needs to bear actual fruit in order to be worthwhile, not to mention the compliance and security requirements most places have in order to get these things approved.” C’est dans ce processus d’approbation que l’enthousiasme se cogne à la bureaucratie, et la bureaucratie gagne souvent par usure.

Le paradoxe du budget

Les organisations mettent systématiquement leur argent IA aux mauvais endroits. L’étude du MIT a constaté que plus de la moitié des budgets d’IA générative vont vers des outils de vente et de marketing, alors que le meilleur retour sur investissement apparaît dans l’automatisation des fonctions support. Tout le monde veut des applications clinquantes côté client. La vraie valeur se cache dans l’opérationnel ennuyeux.

Ce décalage crée un cycle prévisible. Vous financez le cas d’usage le plus excitant. Il s’avère plus difficile que prévu, parce qu’une IA en contact direct avec des clients doit être parfaite et que les clients sont imprévisibles. Pendant ce temps, l’équipe comptable rapproche encore les factures à la main parce que personne n’a alloué de budget à ce flux de travail.

Johnson & Johnson a mené 900 projets d’IA générative en trois ans après avoir encouragé les employés à expérimenter librement. Ils ont découvert que seulement 10 à 15 % de ces cas d’usage produisaient 80 % de la valeur. L’entreprise concentre maintenant ses ressources sur les projets à fort impact et coupe le reste. Trois ans et 900 expériences pour apprendre quels paris rapportent vraiment.

La plupart des entreprises ne feront pas 900 expériences. Elles en feront cinq ou dix, choisiront selon ce qui est le plus excitant plutôt que le plus utile, puis se demanderont pourquoi les résultats sont décevants.

L’IA de l’ombre est déjà là

Pendant que votre initiative IA officielle se fraye un chemin dans les achats et la revue de sécurité, vos employés utilisent déjà l’IA. Simplement, ils le font d’une manière que vous ne voyez pas et que vous ne contrôlez pas.

Les données sont frappantes. La recherche de Cyberhaven a constaté que 73,8 % des comptes ChatGPT utilisés au travail sont des comptes personnels, sans contrôles de sécurité entreprise. Pour Gemini de Google, c’est 94,4 %. Pour Bard, 95,9 %.

Vos équipes ne vous attendent pas.

Elles collent des données client dans des outils grand public pour aller plus vite. Elles utilisent des comptes personnels parce que l’entreprise n’a pas fourni d’alternatives approuvées. 27,4 % des données d’entreprise que les employés envoient à des outils IA sont désormais classées comme sensibles, contre 10,7 % un an plus tôt.

Ça crée une situation étrange : l’effort officiel d’extension de l’IA avance lentement, au rythme des contrôles de conformité, pendant que l’usage non maîtrisé explose dans l’ombre. Au moment où votre déploiement officiel arrive, les habitudes se sont déjà installées autour d’outils non approuvés. Vous n’introduisez pas l’IA ; vous demandez aux gens de passer à une autre version.

Les organisations intelligentes repèrent ces utilisateurs de l’ombre et apprennent d’eux au lieu de les punir. Quels problèmes résolvent-ils ? Qu’est-ce que ça vous dit sur les endroits où l’IA aide vraiment ?

L’équation humaine

Étendre l’IA, c’est passer des premiers adoptants enthousiastes à la majorité sceptique. Ce n’est pas le même combat.

La recherche de BCG a constaté que plus des trois quarts des dirigeants et managers disent utiliser l’IA générative plusieurs fois par semaine, mais que l’usage régulier parmi les employés de terrain a plafonné à 51 %. Le problème n’est pas l’accès. La plupart des organisations ont fourni des outils. Le problème, c’est l’adoption.

Ceux qui ont le plus de mal avec l’adoption de l’IA ne sont pas ceux qu’on imagine. Des employés seniors, avec une expertise profonde, résistent parfois parce que l’IA menace la valeur d’un savoir qu’ils ont mis des décennies à construire. L’analyste qui savait toujours où trouver la donnée voit maintenant un collègue junior obtenir des réponses comparables à partir d’un simple prompt. C’est déstabilisant, et pas seulement pour des raisons de productivité.

D’autres résistances sont plus simples. Les gens sont débordés. Apprendre un nouvel outil prend du temps. Le gain n’est pas évident. Les conséquences des erreurs semblent élevées. Attendre de voir si celui-ci va durer paraît raisonnable quand les trois dernières initiatives technologiques sont passées comme une comète.

Un schéma qui marche : le réseau de champions internes. Novartis, Adobe et HSBC ont tous mis en place des programmes où des employés volontaires testent de nouveaux outils, partagent des cas d’usage et accompagnent leurs pairs. Le champion, ce n’est pas l’informatique ou la direction qui dit aux gens quoi faire. C’est un collègue qui montre comment lui, concrètement, s’en sert. Cette influence de pair à pair compte plus qu’on ne le croit.

Quand l’IA produit vraiment des résultats

Il existe des réussites. Lumen Technologies rapporte que Copilot fait gagner à leur équipe commerciale une moyenne de quatre heures par semaine, soit 50 millions de dollars par an. Des tâches qui prenaient quatre heures prennent désormais quinze minutes.

Ce qui rend l’expérience de Lumen notable, ce n’est pas la technologie. C’est le fait d’avoir déployé Copilot à travers des départements et des fonctions métiers, plutôt que de le laisser éternellement enfermé dans le pilote d’une seule équipe. L’outil est devenu une partie du travail, pas une expérience optionnelle.

La santé offre un autre exemple. Comme une personne l’a décrit sur Hacker News : “I’m in the process of deploying several AI solutions in Healthcare. We have a process a nurse usually spends about an hour on, and costs $40-$70 depending on if they are offshore and a few other factors. Our AI can match it at a few dollars often less.” Elle a noté qu’en test, l’IA repérait souvent des problèmes que les infirmières manquaient, tandis que les infirmières trouvaient rarement des problèmes que l’IA n’avait pas vus.

Le point commun des réussites n’est pas une stratégie IA brillante. C’est une exécution obstinée de fondamentaux ennuyeux : des cas d’usage clairs liés à des résultats mesurables, l’intégration dans les flux de travail existants, une formation qui prépare vraiment les gens à utiliser les outils, et une direction qui reste impliquée au-delà de la phase d’annonce.

Le problème d’intégration dont personne ne parle

La plupart des outils IA ne fonctionnent pas en vase clos. Ils fonctionnent en se connectant à vos données.

Ça semble simple jusqu’à ce que vous réalisiez que vos données vivent dans dix-sept systèmes différents qui ne se parlent pas, dont la moitié ont des responsables flous et des bizarreries non documentées que seule la personne partie il y a deux ans comprenait vraiment.

Des outils génériques comme ChatGPT sont excellents pour les individus parce qu’ils marchent avec ce que vous collez dedans. Ils peinent en entreprise parce qu’ils n’ont pas accès au contexte. L’IA ne connaît pas votre historique client, votre catalogue produit, votre terminologie interne ou vos processus spécifiques. Sans ce contexte, les sorties demandent une édition lourde.

La recherche du MIT pointe cet « écart d’apprentissage » comme une raison centrale pour laquelle les pilotes n’arrivent pas à s’étendre. Le problème n’est pas la qualité du modèle. C’est que les outils génériques ne s’adaptent pas aux flux de travail de l’organisation. Les solutions IA achetées auprès de fournisseurs spécialisés réussissent environ 67 % du temps, tandis que les systèmes développés en interne réussissent trois fois moins souvent. L’avantage des fournisseurs vient en partie du fait qu’ils ont déjà résolu des problèmes d’intégration.

Construire ou acheter

La décision « construire vs acheter » a des enjeux plus élevés avec l’IA qu’avec les logiciels classiques.

Construire vous donne du contrôle et de la personnalisation, mais exige des compétences que la plupart des organisations n’ont pas. Il faut des personnes qui comprennent les limites de l’IA, savent construire des systèmes fiables et peuvent les maintenir à mesure que les modèles évoluent. La technologie change plus vite que les logiciels traditionnels, donc ce que vous construisez aujourd’hui peut demander une grosse remise à plat dans dix-huit mois.

Acheter, c’est un déploiement plus rapide mais moins de personnalisation, et une dépendance continue au fournisseur. Vous êtes contraint par ce que l’outil du fournisseur fait bien, ce qui ne correspond pas forcément à vos flux de travail.

Les données du MIT montrent que l’achat fonctionne plus souvent que la construction pour les organisations qui n’ont pas une expertise IA profonde. Mais acheter crée ses propres problèmes quand les fournisseurs changent la direction du produit, augmentent les prix ou disparaissent. Dépendre d’un seul fournisseur pour des flux de travail critiques introduit un risque qui n’existait pas auparavant.

Certaines organisations tentent des approches hybrides : acheter la capacité IA de base auprès de fournisseurs, mais construire des couches d’intégration sur mesure. Ça peut capter le meilleur des deux mondes, mais ça combine aussi les difficultés des deux. Il faut des compétences de gestion fournisseurs et une capacité technique interne.

Ce que vivent vraiment les cadres intermédiaires

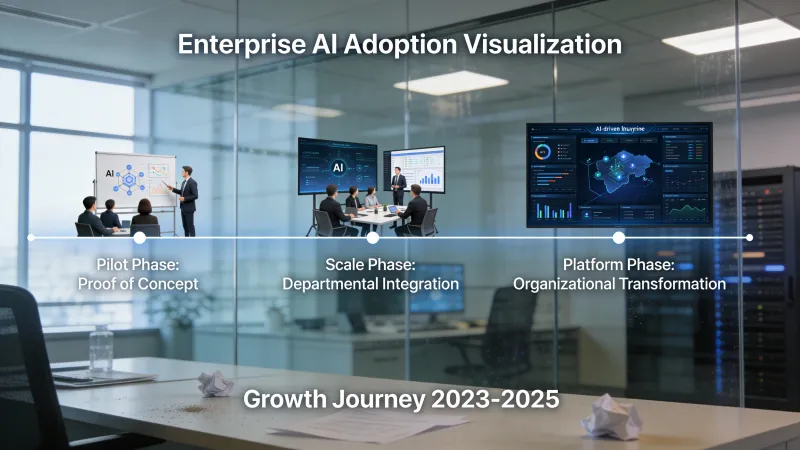

Les présentations au comité exécutif décrivent la transformation IA en phases lisses. Évaluer, piloter, étendre, optimiser. Des flèches propres vers la droite. Des objectifs mesurables à chaque étape.

L’expérience des cadres intermédiaires est plus chaotique.

On leur demande d’atteindre les mêmes objectifs pendant que leur équipe apprend de nouveaux outils. Le temps de formation est pris sur le temps de production. Les erreurs du début créent du travail de reprise. Certains s’adaptent vite et d’autres peinent, ce qui crée des tensions. Les outils aident sur certaines tâches mais pas sur d’autres, donc les flux de travail deviennent des patchworks.

Ils entendent d’en haut que l’adoption de l’IA est une priorité. Ils entendent d’en bas que les outils sont peu fiables, ou que les gens n’ont pas le temps. Ils essaient de trouver un compromis réaliste pendant que les indicateurs attendent une amélioration immédiate.

Les cadres intermédiaires déterminent souvent si l’IA prend réellement racine. Ce sont eux qui décident s’il faut imposer l’usage des outils, comment gérer les résistances, et si les membres de l’équipe en difficulté reçoivent du soutien ou de la pression. Le parrainage exécutif compte pour allouer des ressources, mais ce sont les cadres intermédiaires qui fixent la réalité du quotidien.

Les 95 % et les 5 %

Si 95 % des pilotes n’arrivent pas à produire des retours mesurables, qu’est-ce que font différemment les 5 % ?

Ils ne sont pas plus intelligents sur l’IA. Ils sont meilleurs sur le changement organisationnel.

Les 5 % commencent par des problèmes bien définis et relient l’IA directement à des résultats mesurables, pas « améliorer l’efficacité » mais « réduire le temps de revue des contrats de 4 heures à 1 heure ». Cette précision leur dit si ça marche.

Ils confient la responsabilité opérationnelle aux personnes les plus proches des flux de travail, pas à des équipes innovation qui opèrent en parallèle du travail réel. Ceux qui font le métier deviennent ceux qui façonnent comment l’IA assiste ce métier.

Ils investissent de manière disproportionnée dans le volet humains et processus. La répartition qui revient souvent dans la recherche ressemble à 10 % d’algorithmes, 20 % d’infrastructure, 70 % d’humains et de processus. La plupart des organisations inversent ce ratio, dépensant beaucoup sur la technologie et supposant que l’adoption suivra.

Ils intègrent la gouvernance au plan dès le départ, et non comme un ajout quand les problèmes émergent. Des pistes d’audit, des métriques claires, des processus de revue définis. Ça sonne bureaucratique, mais c’est précisément ce qui permet à l’IA de s’étendre, parce que c’est ainsi qu’on convainc les parties prenantes sceptiques d’élargir l’accès.

À quoi ressemble une adoption durable

Il y a une différence entre lancer l’IA et établir l’IA.

Le lancement, c’est l’annonce, les sessions de formation, le pic d’usage initial. L’établissement, c’est quand les gens prennent naturellement des outils IA, quand les nouveaux employés sont formés à des flux de travail assistés par IA dès le premier jour, quand la question passe de « est-ce que je dois utiliser l’IA pour ça » à « quelle est la meilleure façon d’utiliser l’IA pour ça ».

Y arriver prend plus de temps que ne le suggère le plan projet. D’abord, il faut suffisamment de personnes qui utilisent régulièrement les outils pour que l’usage devienne visible et normalisé. Ensuite, il faut des flux de travail qui intègrent l’IA de manière documentée et répétable, plutôt que de l’expérimentation individuelle. Enfin, il faut que l’IA devienne une partie des attentes de performance, pas comme de la surveillance, mais comme une compétence supposée.

La plupart des organisations en sont encore à la phase d’expérimentation. BCG a constaté que plus de 85 % des employés restent à des stades précoces d’adoption de l’IA, tandis que moins de 10 % ont atteint le point où l’IA est intégrée à leur travail central. Le chemin du premier pilote à une capacité organisationnelle prend des années, pas des trimestres.

Des questions franches à se poser

Avant de planifier l’extension de l’IA, posez ces questions sans réponses optimistes :

Quel problème résolvons-nous que nous ne pouvions pas résoudre avant l’IA, et comment saurons-nous que nous l’avons résolu ? Si vous ne pouvez pas répondre précisément, votre effort d’extension n’a pas de direction claire.

Qui en sera propriétaire après la dissolution de l’équipe projet ? Les initiatives sans responsabilité durable reviennent à l’état précédent.

Que se passe-t-il quand l’IA fait une erreur qui affecte un client ? Si vous ne le savez pas, vous n’êtes pas prêt pour la production.

Quelles parties de l’organisation sont prêtes, et lesquelles ne le sont pas ? Commencer là où les conditions favorisent le succès vaut mieux que d’essayer de tout transformer d’un coup.

Avons-nous le soutien des cadres intermédiaires pour traverser les mois inconfortables où l’adoption traîne et où les résultats restent flous ? Le parrainage exécutif seul ne suffit pas.

Qu’est-ce qui nous ferait arrêter cette initiative, et comment saurons-nous que nous avons atteint ce point ? Clarifier des critères d’échec aide à éviter le projet zombie qui ne meurt jamais officiellement, mais ne vit jamais vraiment non plus.

Le temps long

L’adoption organisationnelle de l’IA n’est pas un projet avec une date de fin. C’est une capacité qui évolue.

Les modèles s’améliorent. Ce qui n’était pas possible l’an dernier devient routinier cette année. Les organisations qui intègrent des mécanismes d’apprentissage dans leur approche peuvent capter ces améliorations au fil de l’eau. Les organisations qui ont traité l’IA comme un déploiement ponctuel voient leurs capacités vieillir.

L’environnement réglementaire continue de bouger. Ce qui est acceptable aujourd’hui pour une IA qui traite des données client peut ne pas l’être demain. Construire la conformité dans les fondations vaut mieux que de bricoler après coup quand les règles changent.

Le paysage concurrentiel bouge. Certains secteurs atteindront un point où la capacité IA sera le minimum syndical, ou ne pas l’avoir voudra dire prendre du retard en coûts ou en vitesse. D’autres secteurs avanceront plus lentement. Savoir où se situe votre industrie aide à calibrer l’urgence.

Les personnes de votre organisation apprennent. Les sceptiques du départ deviennent parfois les utilisateurs IA les plus précieux parce qu’ils testent les limites à fond. Les premiers adoptants s’épuisent parfois à force de porter trop de poids. L’histoire humaine évolue en même temps que l’histoire technologique.

Étendre l’IA dans une organisation ressemble moins à l’installation d’un logiciel qu’à la construction d’une culture. Les cultures prennent du temps. Elles connaissent des rechutes. Elles résistent aux initiatives formelles et répondent aux normes informelles. Elles exigent une attention durable plutôt qu’un effort concentré.

Les entreprises qui réussissent seront, pour l’essentiel, celles qui l’ont traité comme un travail continu plutôt que comme un projet de transformation avec une date de fin. Elles continueront d’apprendre, de s’ajuster, et de trouver de nouveaux endroits où l’IA aide. C’est moins excitant que la vision d’une transformation organisationnelle, mais c’est plus proche de ce que font réellement les 5 %.

Ce qui sépare les pilotes qui s’étendent de ceux qui ne s’étendent pas, au bout du compte, c’est peut-être la patience. La patience de traverser les problèmes d’intégration au lieu de les déclarer bloquants. La patience de soutenir les adoptants en difficulté au lieu de les remplacer. La patience de mesurer les résultats sur des trimestres plutôt que sur des semaines. La patience de continuer d’investir quand les premiers retours déçoivent.

Pas la patience de l’attente passive. La patience de l’effort soutenu. C’est une ressource plus difficile à allouer qu’un budget.