Dein erster Prompt funktioniert selten. Dein zweiter auch nicht. Die Frage ist nicht, ob du iterierst. Die Frage ist, ob dich deine Iterationen wirklich voranbringen — oder ob du nur Credits verbrennst, während du dir einredest, du würdest Fortschritt machen.

Die meisten Guides zu Prompt-Engineering behandeln Iteration wie eine Tugend an sich, als würde das bloße Nachjustieren und Testen irgendwie Verbesserung garantieren. Aber sprich mit jemandem, der echte Stunden damit verbracht hat, Prompts für Produktivsysteme zu verfeinern, und du hörst eine andere Geschichte. Manchmal verstärkt sich Iteration. Manchmal zieht sie dich in eine Spirale. Den Unterschied zu kennen trennt strategisches Nachschärfen von teurem Frust.

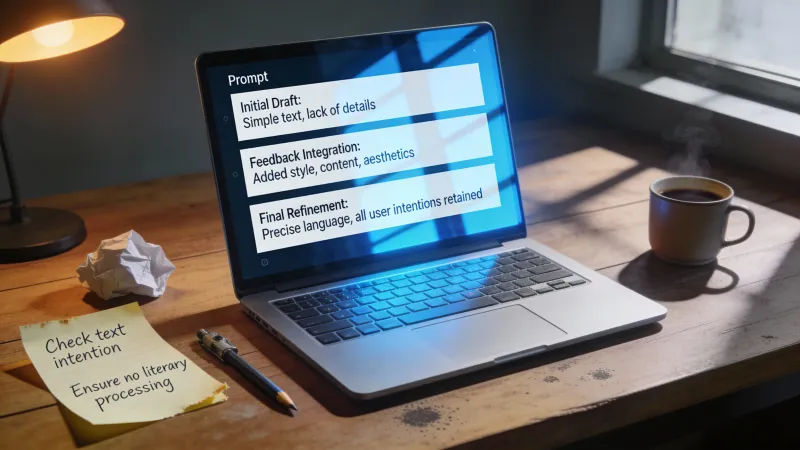

Die Mechanik einer sinnvollen Iteration

Jede Prompt-Iteration verändert etwas. Die sinnvollen verändern die richtigen Dinge.

Wenn du eine Ausgabe bekommst, die am Ziel vorbeigeht, ist der Reflex oft: mehr Anweisungen, mehr Beispiele, mehr Einschränkungen. Aber Anhäufen ist nur ein Werkzeug im Kasten. Wie ein Entwickler auf Hacker News seinen Ablauf beschrieben hat: “every time the model does something undesired, even minor I add an explicit rule in the system prompt” (minimaxir, Hacker News). Dieser Ansatz funktioniert, aber er hat auch angemerkt, dass sich angesammelte Regeln “balloon quickly” können, sobald beim Testen Probleme auftauchen.

Das Gegenteil funktioniert ebenfalls. Manchmal liefern weniger Anweisungen bessere Ergebnisse als mehr. Ein Praktiker beobachtete: “Sometimes even giving them ‘drunken’ prompts with just a few keywords is enough… If you specify too much they tend to hyperfixate on things” (birracerveza, Hacker News). Enge Vorgaben können ein Modell so stark verengen, dass es das eigentliche Ziel verfehlt.

Also: in welche Richtung gehst du? Das hängt vom Fehlermuster ab.

Erst diagnostizieren, dann ändern

Ausgabe zu allgemein? Konkreter werden. Ausgabe zu wörtlich? Einschränkungen rausnehmen. Ausgabe inkonsistent? Struktur geben. Ausgabe wiederholt sich? Beispiele reduzieren.

Ordne den Fehler der Korrektur zu. Zufällige Änderungen erzeugen zufällige Ergebnisse, und zufällige Ergebnisse zeigen dir nicht, was den Ausschlag gegeben hat.

Die Leute, die darin wirklich gut werden, behandeln Iteration als Hypothesentest statt als Versuch-und-Irrtum. Jede Änderung testet eine konkrete Annahme darüber, warum die letzte Ausgabe danebenlag. Dieses Framing zählt, weil es dich zwingt, erst zu benennen, was du glaubst, was schiefging — bevor du irgendetwas änderst.

Wann iterieren und wann neu anfangen

Iteration setzt voraus, dass dein aktueller Prompt ein Fundament hat, auf dem es sich aufzubauen lohnt. Diese Annahme stimmt nicht immer.

Es gibt ein Muster: Menschen polieren einen mittelmäßigen Prompt durch fünfzehn Iterationen, hängen Klauseln, Beispiele und Einschränkungen dran, bis der Prompt ein verknotetes Bündel aus angesammelten Pflastern ist. Am Ende haben sie etwas, das irgendwie funktioniert, manchmal. Aber sie wären schneller gewesen, wenn sie den Anfang verworfen und das Problem frisch angegangen wären.

Die Versunkene-Kosten-Falle trifft im Prompt-Engineering hart. Du hast zwanzig Minuten in diesen Prompt gesteckt. Er funktioniert fast. Eine kleine Anpassung noch, dann passt es. Aber wenn dein Rahmen von Anfang an falsch war, repariert kein Feinschliff das.

Starte neu, wenn:

- dein Prompt über zwei Absätze Anweisungen hinausgewachsen ist

- du Ausnahmen hinzufügst, um Ausnahmen zu behandeln

- die Kernbeschreibung der Aufgabe deinem eigentlichen Ziel nicht mehr ähnelt

- die Ausgaben trotz logischer Änderungen schlechter werden, nicht besser

Ein Entwickler auf Hacker News brachte es brutal auf den Punkt: “I realized the real problem was that I hadn’t figured out what I wanted in the first place” (Kiyo-Lynn, Hacker News). Bevor du iterierst, musst du wissen, wie Erfolg aussieht. Wenn du die ideale Ausgabe nicht klar beschreiben kannst, kann dein Prompt das auch nicht.

Protokoll für einen Neustart

Wenn du neu anfängst, lösch nicht einfach und schreib neu. Zieh erst heraus, was aus deinen Fehlversuchen funktioniert hat.

Vielleicht war deine Formatvorgabe gut, auch wenn dein Aufgabenrahmen danebenlag. Vielleicht haben deine Beispiele das Falsche gezeigt, aber die Tonalitäts-Anweisung hat gesessen. Rette die Teile, die Potenzial gezeigt haben. Wirf das Gerüst weg, das du um Fehler herumgebaut hast.

Dann schreib deinen neuen Prompt rückwärts vom Ergebnis her. Starte mit dem, was du genau sehen willst. Beschreibe diese Ausgabe in klarer Sprache. Bau Anweisungen, die genau dieses Ergebnis erzeugen würden. Diese Umkehrung führt oft zu saubereren Prompts, als zu versuchen, die Transformation vom Input zur Ausgabe zu spezifizieren.

Was funktioniert festhalten (ohne zu überkonstruieren)

Du brauchst ein System. Du brauchst kein kompliziertes System.

Der einfachste Ansatz: führ ein laufendes Dokument. Jeder Prompt-Versuch bekommt eine Nummer, den Prompt-Text, eine Beispielausgabe und eine Ein-Zeilen-Bewertung. “Bessere Struktur, aber der lockere Ton ist weg.” “Format perfekt, aber Inhalt zu oberflächlich.” “Das hier hat tatsächlich funktioniert.”

Wie ein erfahrener Praktiker anmerkte: “Practice. Keep notes on what works for you. Pay attention to what other people do and take the best ideas” (PaulHoule, Hacker News). Die Gewohnheit, Notizen zu machen, zählt mehr als das konkrete Format.

Was du festhalten solltest

Für jede Iteration notiere:

- was du gegenüber der vorherigen Version geändert hast

- warum du glaubtest, dass diese Änderung hilft

- was sich in der Ausgabe tatsächlich verändert hat

- ob dich die Änderung deinem Ziel nähergebracht oder davon weggeführt hat

Der letzte Punkt ist entscheidend. Manchmal erzeugt eine Änderung eine andere Ausgabe, ohne eine bessere zu erzeugen. Wenn du die Richtung nicht explizit bewertest, kannst du endlos iterieren ohne Fortschritt — nur anders.

Das Vergleichsproblem

Hier ist die unbequeme Wahrheit: Prompt-Ausgaben zu vergleichen ist schwieriger, als es aussieht. Derselbe Prompt kann bei zwei Läufen hintereinander merklich unterschiedliche Ausgaben produzieren. Das heißt: Die Verbesserung, die du glaubst zu sehen, ist vielleicht nur Zufall.

Ein Kommentator fasste diesen Frust so: “if you’re ‘tweaking’ the prompt what you’re really doing is just re-rolling the dice until you land in a neighborhood closer” to what you want (ianbicking, Hacker News). Er argumentiert, dass Techniken nur dann echter Fortschritt sind, wenn sie über mehrere Testfälle hinweg funktionieren, statt nur einzelne Glückstreffer zu liefern.

Für Prompts in Produktivsystemen ist das enorm wichtig. Ein Prompt, der einmal brillant funktioniert und dreimal scheitert, ist schlechter als ein Prompt, der jedes Mal solide funktioniert. Tests an einem einzelnen Beispiel geben dir keine Information über Konsistenz. Tests an vielen Beispielen schon — kosten aber mehr Zeit.

Der Mittelweg: Teste Änderungen gegen deine drei repräsentativsten Eingaben. Wenn die Änderung alle drei verbessert, hast du wahrscheinlich etwas Reales gefunden. Wenn sie eine verbessert und eine andere verschlechtert, verschiebst du vermutlich nur die Varianz.

Die Falle der abnehmenden Erträge

Jeder Prompt hat eine Obergrenze. Wenn du darüber hinausdrückst, optimierst du auf Rauschen.

Die ersten paar Iterationen bringen typischerweise große Verbesserungen. Grobe Prompts werden funktional. Funktionale Prompts werden zuverlässig. Aber irgendwann schrumpfen deine Zugewinne so stark, dass du Signal und Zufall nicht mehr zuverlässig unterscheiden kannst.

Ein Hacker-News-Nutzer beschrieb, wie er beim Iterieren mit KI-Agenten an diese Wand kam: sie “just spin and spin, burn 30 dollars for one prompt” (taosx, Hacker News). Automatisierung macht die Falle schlimmer. Wenn Iteration gratis ist, iterierst du ewig. Wenn sie Geld oder Zeit kostet, spürst du die abnehmenden Erträge im Portemonnaie oder im Kalender.

Die Obergrenze erkennen

Du bist in den abnehmenden Erträgen, wenn:

- Änderungen andere Ausgaben produzieren, aber nicht klar bessere

- du immer wieder denselben Änderungstyp machst (konkreter, dann noch konkreter, dann noch konkreter)

- die Qualität schwankt, statt zu steigen

- du mehr Zeit damit verbringst zu entscheiden, ob eine Ausgabe besser ist, als Prompts tatsächlich zu testen

An diesem Punkt hast du drei Optionen. Akzeptiere die aktuelle Ausgabe als gut genug. Ändere deinen Ansatz komplett. Oder erkenne, dass die Aufgabe vielleicht über das hinausgeht, was du nur mit Prompting erreichen kannst.

Wann du aufhören solltest

Die schwierigste Fähigkeit bei Prompt-Iteration ist zu wissen, wann du aufhören solltest. Nicht, weil du Perfektion erreicht hast, sondern weil weitere Verfeinerung deine Ergebnisse nicht mehr sinnvoll verbessert.

Ein anderer Kommentator fand Erfolg, indem er sich bewusst Grenzen setzte: “Instead of over optimizing my prompt I just try to find the minimal amount of representation to get the llm to understand my problem” (someoneontenet, Hacker News). Minimal ausreichend ist oft besser als theoretisch optimal.

Gut genug hat einen Produktivitätsvorteil. Jede Stunde, die du damit verbringst, einen Prompt zu optimieren, der schon funktioniert, ist eine Stunde, die du nicht in etwas anderes steckst. Der perfekte Prompt ist weniger wichtig, als du denkst — besonders bei Aufgaben, bei denen du die Ausgabe sowieso überprüfst.

Meta-Prompting: Die KI für dich iterieren lassen

Es gibt eine Abkürzung, die manchmal besser funktioniert als manuelle Iteration.

Statt deinen Prompt direkt zu verfeinern, beschreibst du dein Ziel einer KI und bittest sie, einen Prompt für dieses Ziel zu erzeugen. Dann nutzt du diesen erzeugten Prompt in einer frischen Unterhaltung, ohne Kontext dazu, wie du dort hingekommen bist.

Ein Praktiker dokumentierte diesen Ansatz: zuerst “Ask Claude to come up with LLM prompt to solve problem”, dann den erzeugten Prompt in einer neuen Unterhaltung verwenden. Er sah eine Verbesserung von 148 auf 428 Wörter, indem er nur 27 Wörter Meta-Anweisung nutzte, statt den ursprünglichen Prompt direkt zu verfeinern (slt2021, Hacker News).

Das funktioniert, weil KI-Modelle Prompts oft anders strukturieren als Menschen. Sie packen vielleicht Rahmung oder Anweisungen rein, auf die du nicht kommen würdest. Die frische Unterhaltung zählt, weil sie die Kontext-Verschmutzung eliminiert, die sich bei manueller Iteration ansammelt.

Meta-Prompting ist nicht immer besser. Aber wenn du feststeckst, gibt es dir einen anderen Angriffswinkel.

Iteration als Lernprozess

Die Prompts, die du in sechs Monaten schreibst, werden besser sein als die Prompts, die du heute schreibst. Nicht, weil du bessere Vorlagen auswendig gelernt hast, sondern weil du Muster durch Wiederholung verinnerlicht hast.

Jede Iteration lehrt dich etwas darüber, wie Sprachmodelle Anweisungen interpretieren — selbst dann, wenn die Iteration deine Ausgabe nicht verbessert. Mit der Zeit entwickelst du ein Gefühl für Wortwahl, Struktur, Spezifität und Beispiele, das deine ersten Entwürfe besser macht.

Der Iterationsgedanke geht über einzelne Prompts hinaus. Jedes Projekt, das mit Prompting arbeitet, bringt dir etwas bei, das du übertragen kannst. Die Muster, die bei Werbetexten geholfen haben, können beeinflussen, wie du Prompts für Code-Reviews angehst. Die Fehlermuster, die du in einem Bereich siehst, tauchen in anderen wieder auf.

Wie ein Kommentator beobachtete: “just practice. With different systems; sd, mj, chatgpt, gpt3, gptj etc.” (anonzzzies, Hacker News). Breite Erfahrung zählt genauso wie Tiefe in einem einzelnen System — auch, weil unterschiedliche Modelle unterschiedliche Aspekte davon sichtbar machen, wie Prompting funktioniert.

Prompt-Engineering ist eine empirische Disziplin, die sich als linguistische tarnt. Du lernst durch Tun und Beobachten, nicht durch das Lesen von Regeln und deren Anwendung. Die Iterationen, die sich wie verschwendete Zeit anfühlen, bauen oft Intuitionen auf, die du Jahre später bei komplett anderen Problemen nutzt.

Also iteriere. Halte fest, was funktioniert. Merk, wann du dich drehst. Starte neu, wenn du musst.

Aber vergiss nicht: Das Ziel ist nicht ein perfekter Prompt. Das Ziel ist Ausgabe, die das erledigt, was du brauchst. Manchmal ist gut genug wirklich gut genug — und die beste Iteration ist die, bei der du entscheidest aufzuhören.