La historia de la inteligencia artificial no es una línea recta desde unos inicios primitivos hasta un presente brillante. Es una historia de fracasos espectaculares. Dos veces, los investigadores declararon victoria. Dos veces, se equivocaron. El campo casi murió en ambas.

¿Qué fue lo que por fin funcionó? Esa pregunta importa más que cualquier cronología.

La promesa que nadie pudo cumplir

Antes de entrar en la cronología, entiende qué hace que la historia de la IA sea rara entre las historias tecnológicas. Los primeros investigadores no estaban mejorando poco a poco una herramienta existente como el teléfono o el automóvil. Estaban afirmando que el pensamiento, eso que hace humanos a los humanos, podía fabricarse. Estaban diciendo que pasaría pronto.

En 1970, la revista Life publicó un artículo citando a Marvin Minsky: “In from three to eight years we will have a machine with the general intelligence of an average human being.” Minsky después negó haber dicho esto. Pero la cita circuló. Fijó expectativas. Y cuando pasaron ocho años sin nada ni remotamente parecido a la inteligencia a nivel humano, la gente se dio cuenta.

Este patrón se repitió durante décadas. Afirmaciones audaces. Financiación. Decepción. Reacción en contra. Repetir.

¿Por qué importa esto ahora? Porque hoy estás oyendo afirmaciones parecidas. Entender qué salió mal antes te ayuda a evaluar qué podría volver a salir mal.

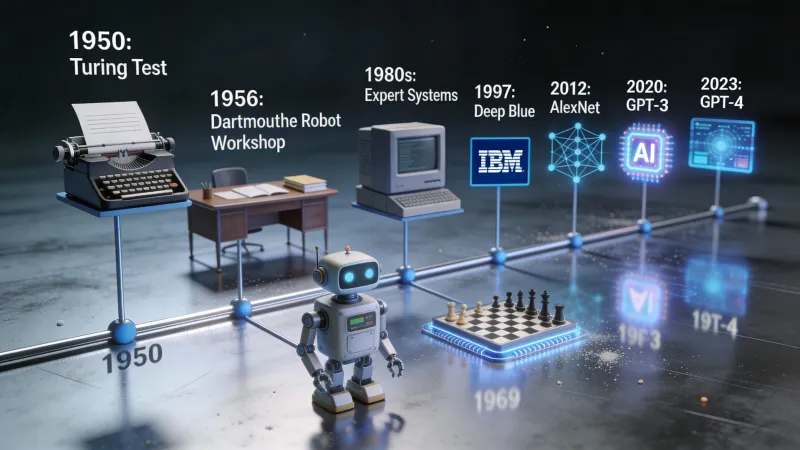

1950: una pregunta lo cambia todo

Alan Turing publicó un artículo en 1950 que enmarcó todo el campo antes de que el campo existiera. El artículo se llamaba “Computing Machinery and Intelligence.” La primera línea era sencilla: “I propose to consider the question, ‘Can machines think?’”

Turing sabía que las definiciones iban a ser un problema. ¿Qué significa siquiera “pensar”? Así que propuso una salida. Olvida intentar definir el pensamiento. En su lugar, juega a un juego.

Un juez humano mantiene conversaciones por texto con dos participantes ocultos. Uno es humano. Uno es una máquina. Si el juez no puede distinguir de forma fiable quién es quién, ¿importa si la máquina “realmente” piensa?

Esto se convirtió en el test de Turing. Desplazó el debate de la filosofía a la ingeniería. ¿Podemos construir algo que lo pase? Esa pregunta sí podía responderse con experimentos, construyendo, probando e iterando.

Turing murió en 1954. Nunca vio que la investigación en IA se convirtiera en un campo. Pero su planteamiento sigue influyendo en cómo evaluamos los sistemas de IA hoy.

1956: un campamento de verano para el futuro

Seis años después del artículo de Turing, un grupo de investigadores se reunió en el Dartmouth College, en New Hampshire, para un taller de verano. John McCarthy lo organizó. Marvin Minsky estaba allí. También Claude Shannon, que había inventado la teoría de la información.

La propuesta que escribieron contiene la frase que definió todo lo que vino después: “The study is to proceed on the basis of the conjecture that every aspect of learning or any other feature of intelligence can in principle be so precisely described that a machine can be made to simulate it.”

Vuelve a leerlo. Cada aspecto del aprendizaje. Cada rasgo de la inteligencia. Puede describirse con precisión. Puede simularse con una máquina.

Esto no era una afirmación modesta. Era una apuesta a que la inteligencia humana, sea lo que sea, podía reducirse a reglas y cálculos. A que nada del pensamiento quedaba, en el fondo, fuera del alcance de lo que las máquinas podían hacer.

En ese taller se acuñó el término “artificial intelligence”. Los investigadores que asistieron se convirtieron en los líderes del campo durante los cuarenta años siguientes. Eran brillantes. También estaban desbocados de optimismo con los plazos.

Los años 60: el optimismo se desboca

La década posterior a Dartmouth fue productiva, emocionante y, al final, preparó el terreno para el primer golpe. Los investigadores construyeron programas que podían demostrar teoremas matemáticos, jugar a las damas, resolver problemas de palabras y mantener conversaciones simples.

ELIZA apareció en 1966. Joseph Weizenbaum, en el MIT, creó un chatbot que fingía ser un psicoterapeuta. Funcionaba por coincidencia de patrones. El usuario dice “Estoy triste.” ELIZA responde: “¿Por qué dices que estás triste?” Sin comprensión. Solo manipulación de texto.

Pasó algo inesperado. Los usuarios formaron vínculos emocionales con ELIZA. Se confesaban con ella. Algunos creían que estaban hablando con algo que se preocupaba por ellos. Weizenbaum se inquietó. Pasó el resto de su carrera advirtiendo sobre los peligros de atribuir cualidades humanas a las máquinas.

A finales de los 60, los investigadores hacían predicciones que hoy suenan absurdas. Herbert Simon dijo que las máquinas harían cualquier trabajo que un humano pudiera hacer en veinte años. Minsky afirmó que el problema de la inteligencia artificial quedaría “substantially solved” en el plazo de una generación.

La financiación siguió llegando. DARPA inyectó dinero en laboratorios de IA. El futuro parecía garantizado.

1973-1980: llega la edad de hielo

Entonces la realidad golpeó.

En 1973, el gobierno del Reino Unido encargó al matemático James Lighthill que evaluara la investigación en IA. Su informe fue devastador. La conclusión clave: “In no part of the field have the discoveries made so far produced the major impact that was then promised.”

Lighthill sostuvo que la investigación en IA se había topado con barreras fundamentales. El problema de la “explosión combinatoria” significaba que las tareas del mundo real tenían demasiadas posibilidades como para buscarlas todas. Los trucos ingeniosos que funcionaban en problemas de juguete se desmoronaban ante cualquier cosa que se pareciera a una aplicación real.

Gran Bretaña recortó la financiación de IA. Laboratorios que habían prosperado vieron cómo sus presupuestos desaparecían casi de la noche a la mañana. DARPA, observando desde el otro lado del Atlántico, se puso nerviosa. Empezaron a exigir aplicaciones militares prácticas en lugar de investigación pura. El dinero también se secó en Estados Unidos.

Este fue el primer invierno de la IA. No una desaceleración. Un colapso.

¿Por qué ocurrió? Las promesas eran demasiado grandes. Los problemas eran demasiado difíciles. Los ordenadores eran demasiado lentos. Los investigadores confundieron los primeros éxitos en problemas acotados con evidencia de que la inteligencia general estaba cerca.

El invierno duró aproximadamente siete años. La IA se convirtió en un riesgo profesional. Usar el término en solicitudes de financiación podía hundir tu propuesta. Los investigadores que se quedaron en el campo lo hicieron en silencio, trabajando en problemas más estrechos con nombres menos vistosos.

1980-1987: falsa primavera

La IA volvió. El motor fueron los “sistemas expertos”. Eran programas que codificaban el conocimiento humano como reglas. Si el paciente tiene fiebre y tos y ha estado expuesto a alguien con gripe, entonces probablemente el paciente tiene gripe. Si el equipo hace un ruido de rozamiento y el nivel de aceite es bajo, entonces probablemente el rodamiento está fallando.

A las empresas les encantó esto. Los negocios podían capturar lo que sabían sus mejores empleados y escalarlo en toda la organización. Se construyeron ordenadores especializados solo para ejecutar sistemas expertos. Una empresa llamada Symbolics vendía hardware de IA por cientos de miles de dólares por máquina.

La inversión volvió a raudales. Se abrieron laboratorios corporativos de IA. El término “inteligencia artificial” volvió a ser respetable. A mediados de los 80, la industria de la IA valía miles de millones de dólares.

Pero los sistemas expertos tenían un problema fundamental. No podían aprender. Cada pieza de conocimiento había que programarla a mano. Mantenerlos era una pesadilla. A medida que se acumulaban las reglas, se volvían frágiles e impredecibles. Y cuando los ordenadores de propósito general más baratos de Sun y Apple les alcanzaron en rendimiento, el mercado de hardware especializado colapsó.

1987-1993: el segundo invierno

El golpe fue peor la segunda vez. Los laboratorios corporativos de IA cerraron. Symbolics quebró. Los investigadores de IA que quedaban rebautizaron lo que hacían como “aprendizaje automático” o “redes neuronales” o cualquier cosa que evitara las palabras tóxicas “inteligencia artificial”.

Si trabajabas en IA en 1990, probablemente no lo habrías admitido en fiestas.

Y, sin embargo, estaba ocurriendo algo importante bajo la superficie. Una pequeña comunidad de investigadores siguió trabajando en redes neuronales, una tecnología que se había descartado en los 60. Mejoraron los algoritmos. Esperaron a que los ordenadores se pusieran al día. Y, lo más importante, Internet empezaba a generar cantidades masivas de texto e imágenes digitales.

Los ingredientes para el siguiente gran avance se estaban ensamblando solos.

Por qué terminaron los inviernos

Aquí está la parte que la mayoría de las historias de la IA se saltan: ¿por qué terminaron los inviernos? ¿Qué cambió?

Cambieron tres cosas.

Primero, la potencia de cálculo siguió duplicándose. La Ley de Moore significaba que un ordenador en 2010 era millones de veces más potente que uno en 1970. Problemas que eran computacionalmente imposibles pasaron a ser abordables.

Segundo, los datos se volvieron abundantes. Internet lo cambió todo. De pronto los investigadores tenían acceso a miles de millones de documentos, millones de imágenes, grabaciones de miles de horas de voz. Las redes neuronales necesitan datos como las plantas necesitan luz solar. Internet aportó suficiente luz para que creciera algo grande.

Tercero, los algoritmos mejoraron. La retropropagación hizo práctico entrenar redes neuronales profundas. Dropout evitó el sobreajuste. Mejores arquitecturas, como las redes neuronales convolucionales, funcionaron bien con imágenes. El progreso incremental se acumuló hasta convertirse en un cambio cualitativo.

Ninguno de estos factores, por sí solo, era suficiente. Juntos, crearon las condiciones para un avance que empequeñecería todo lo anterior.

2012: el año en que todo cambió

En octubre de 2012, un equipo de la Universidad de Toronto participó en el ImageNet Large Scale Visual Recognition Challenge. La competición consistía en identificar objetos en fotografías. Un millón de imágenes. Mil categorías.

El equipo utilizó una red neuronal profunda llamada AlexNet. Geoffrey Hinton supervisó. Alex Krizhevsky hizo la implementación. Ilya Sutskever aportó ideas clave.

Ganaron. Eso era esperable. Pero el margen de victoria sorprendió a todo el mundo.

AlexNet alcanzó una tasa de error top-5 del 15,3%. La siguiente mejor propuesta tuvo 26,2%. Eso no es una pequeña mejora. Es otra categoría de rendimiento. Es la diferencia entre una tecnología que más o menos funciona y otra que de verdad funciona.

Hinton luego bromeó sobre la colaboración: “Ilya thought we should do it, Alex made it work, and I got the Nobel Prize.” El Nobel llegó en 2024, pero el resultado de AlexNet fue lo que hizo posible todo lo demás.

En cuestión de meses, todas las grandes tecnológicas estaban contratando investigadores de redes neuronales. Google adquirió una startup que Hinton había fundado. Facebook abrió un laboratorio de IA. Microsoft amplió su división de investigación. El dinero que había abandonado la IA en los 80 volvió a raudales.

Esto no fue una falsa primavera. La tecnología funcionó de verdad. Funcionó en problemas reales, a escala real, con valor económico real.

2017: ocho investigadores cambian el mundo

El siguiente punto de inflexión llegó con un artículo de título extraño. Ocho investigadores de Google publicaron “Attention Is All You Need” en junio de 2017. El título hacía referencia a una canción de los Beatles. El contenido revolucionó el procesamiento del lenguaje natural.

El artículo introdujo la arquitectura Transformer. Los modelos de lenguaje anteriores procesaban el texto en secuencia, palabra por palabra. Los Transformers procesan todo en paralelo, permitiendo que cada palabra “preste atención” a cualquier otra palabra sin importar la distancia. Esto hizo el entrenamiento mucho más rápido y capturó mucho mejor las dependencias de largo alcance en el texto.

Hoy, todos los grandes modelos de lenguaje usan Transformers. GPT. Claude. Gemini. Llama. Todos descienden de ese artículo de 2017. Probablemente sea la investigación de IA más influyente de la última década.

Los autores no sabían lo que habían creado. El artículo trataba sobre traducción automática. Tardó años en quedar claro lo que implicaba.

2020: la hipótesis del escalado se confirma

OpenAI lanzó GPT-3 en junio de 2020. Tenía 175 mil millones de parámetros. Podía escribir ensayos. Podía depurar código. Podía responder preguntas sobre casi cualquier cosa. A veces se inventaba cosas. Pero cuando funcionaba, funcionaba de una forma que parecía casi mágica.

La reacción de desarrolladores e investigadores fue intensa. Un tuit viral capturó el momento: “Playing with GPT-3 feels like seeing the future.”

El CEO de OpenAI, Sam Altman, intentó moderar las expectativas. “The GPT-3 hype is way too much,” escribió. Pero la pasta de dientes ya estaba fuera del tubo.

GPT-3 demostró algo importante. La hipótesis del escalado sugería que, si hacías las redes neuronales más grandes y las entrenabas con más datos, seguirían volviéndose más inteligentes. Muchos investigadores eran escépticos. GPT-3 demostró que los escépticos se equivocaban.

30 de noviembre de 2022: el público descubre la IA

ChatGPT se lanzó un miércoles. Cinco días después, el CEO de OpenAI, Sam Altman, tuiteó: “ChatGPT launched on wednesday. today it crossed 1 million users!”

Dos meses después, tenía 100 millones de usuarios. Ninguna aplicación de consumo había crecido tan rápido. Ni Facebook. Ni TikTok. Ni Instagram. Nada.

¿Qué hizo a ChatGPT distinto de GPT-3? Era gratis. Era conversacional. Estaba optimizado para ser útil e inofensivo. Cualquiera podía probarlo sin una clave de API ni una tarjeta de crédito.

Este fue el momento en que la IA dejó de ser una historia tecnológica. Tus compañeros de trabajo la usaban. Tus padres preguntaban por ella. Tus hijos hacían los deberes con ella.

El campo que casi había muerto dos veces ahora era la tecnología de la que más se hablaba en el mundo.

¿Dónde estamos ahora?

A comienzos de 2026, ChatGPT tiene 800 millones de usuarios activos semanales. Eso es, aproximadamente, el 10% de la población adulta mundial usando una sola herramienta de IA. GPT-5 existe. Claude existe. Gemini existe. Modelos de código abierto de Meta y Mistral han puesto una IA potente al alcance de cualquiera con un equipo decente.

El dinero que fluye hacia la IA empequeñece cualquier cosa de los auges anteriores. Cientos de miles de millones de dólares. Nuevos centros de datos construyéndose en múltiples continentes específicamente para entrenar modelos de IA.

¿Es esta otra burbuja? ¿Habrá un tercer invierno?

La respuesta honesta: nadie lo sabe. Pero algunas cosas son distintas esta vez.

La tecnología entrega valor real. ChatGPT no es ELIZA. Puede ayudar de verdad con trabajo de verdad. Las empresas están usando IA para escribir código, analizar datos, resumir documentos y docenas de otras tareas que ahorran tiempo y dinero reales.

Las capacidades son demostrables. Los auges anteriores de la IA se basaban en promesas. Este se basa en productos que la gente puede usar hoy.

Los riesgos son reales. Estos modelos a veces alucinan. Se les puede manipular. Plantean preguntas sobre empleo, desinformación y concentración de poder que los sistemas de IA anteriores nunca plantearon.

El patrón que conviene recordar

Setenta y cinco años de historia de la IA enseñan una lección consistente. Un avance lleva al bombo. El bombo lleva a prometer de más. Prometer de más lleva a la decepción. La decepción lleva al invierno.

Los avances desde 2012 son reales. Los Transformers cambiaron lo que es posible. ChatGPT cambió quién lo usa. Pero la historia sugiere humildad con las predicciones.

Los investigadores que decían en 1965 que la IA a nivel humano estaba a veinte años vista se equivocaron. Los investigadores que dicen cosas parecidas hoy podrían equivocarse también. O podrían acertar. La respuesta honesta es que nadie lo sabe.

Lo que sí sabemos: las herramientas de IA ya son útiles para tareas específicas. Entender de dónde vienen ayuda a separar la realidad del bombo. Esa separación tiene valor.

El campo que murió dos veces ahora vale billones. Que siga así depende de si la tecnología sigue entregando. De momento lo hace. Pero ya hemos estado aquí antes.