Irgendwo zwischen deiner Frage und der Antwort der KI passiert eine Entscheidung. Nicht eine. Tausende.

Jedes einzelne Wort, das das Modell schreibt, ist eine Wahl zwischen Alternativen, die an dieser Stelle auch gepasst hätten. „Blau“ oder „klar“ oder „dunkel“. „Deshalb“ oder „also“ oder „folglich“. Jede Wahl formt alles, was danach kommt. Temperatur ist die Einstellung, die steuert, wie diese Entscheidungen getroffen werden.

Die meisten fassen sie nie an. Sollten sie aber.

Die Wahrscheinlichkeitsmaschine

Wenn ein Sprachmodell Text erzeugt, holt es keine Antworten aus einer Datenbank, und es durchsucht nicht das Internet nach der besten Reaktion auf deine Frage oder nach der korrekten Antwort in irgendeinem riesigen Nachschlagewerk. Es sagt voraus. Aus allem, was es beim Training gelesen hat, und allem, was du in deinen Prompt geschrieben hast, berechnet das Modell die Wahrscheinlichkeit, mit der jedes mögliche nächste Wort „natürlich“ folgen würde.

Für „Das Wetter heute ist ___“ könnte das Modell berechnen:

- sonnig: 28 % Wahrscheinlichkeit

- schön: 15 % Wahrscheinlichkeit

- schrecklich: 8 % Wahrscheinlichkeit

- apokalyptisch: 0,003 % Wahrscheinlichkeit

Diese Wahrscheinlichkeiten entstehen aus Mustern, die es beim Training aufgenommen hat: Millionen Beispiele dafür, wie Menschen ähnliche Sätze beenden, gewichtet und kombiniert durch Schichten neuronaler Netzwerk-Mathematik, die selbst die Ingenieure, die es gebaut haben, nicht vollständig erklären können.

Temperatur verändert, was als Nächstes passiert.

Was Temperatur wirklich macht

Der Begriff kommt aus der Physik. In der statistischen Mechanik beschreibt Temperatur, wie sich Energie über ein System verteilt. Kalte Systeme bündeln Energie in vorhersehbaren Mustern. Heiße Systeme verteilen Energie chaotisch.

Die Mathematik überträgt sich fast direkt auf Sprachmodelle, und hier ist das Wort „Temperatur“ keine Metapher, sondern ein echter technischer Begriff, aus der Thermodynamik übernommen, weil die Gleichungen fast identisch aussehen.

Niedrige Temperatur schärft die Wahrscheinlichkeitsverteilung. Wenn „sonnig“ 28 % Wahrscheinlichkeit hatte und „schön“ 15 %, kann ein Absenken der Temperatur diese Werte auf 45 % und 8 % verschieben. Die Abstände werden größer. Der Favorit wird dominanter. Das Modell wählt immer häufiger die Option mit der höchsten Wahrscheinlichkeit, und Alternativen mit niedrigerer Wahrscheinlichkeit werden fast nie genommen.

Hohe Temperatur flacht die Verteilung ab. Dieselben Wahrscheinlichkeiten könnten zu 22 % und 18 % werden. Die Abstände schrumpfen. Optionen auf Platz zwei und drei bekommen mehr Chancen. Das Modell wählt breiter aus seiner Wahrscheinlichkeitsverteilung, inklusive Wörter, die es bei niedriger Temperatur fast nie wählen würde.

Bei Temperatur null wählt das Modell immer das einzelne wahrscheinlichste nächste Wort. Jedes Mal. Lässt du denselben Prompt hundertmal laufen, bekommst du hundertmal dieselbe Ausgabe. Das nennt man manchmal greedy decoding.

Bei Temperatur eins wählt das Modell direkt aus seiner rohen Wahrscheinlichkeitsverteilung, ohne Modifikation. Ein Wort mit 10 % Wahrscheinlichkeit hat eine 10 %-Chance, ausgewählt zu werden.

Über Temperatur eins werden Optionen mit niedrigerer Wahrscheinlichkeit verstärkt. Die Verteilung wird noch flacher. Wörter, die vorher winzige Chancen hatten, bekommen plötzlich echte.

Die Kreativitätsillusion

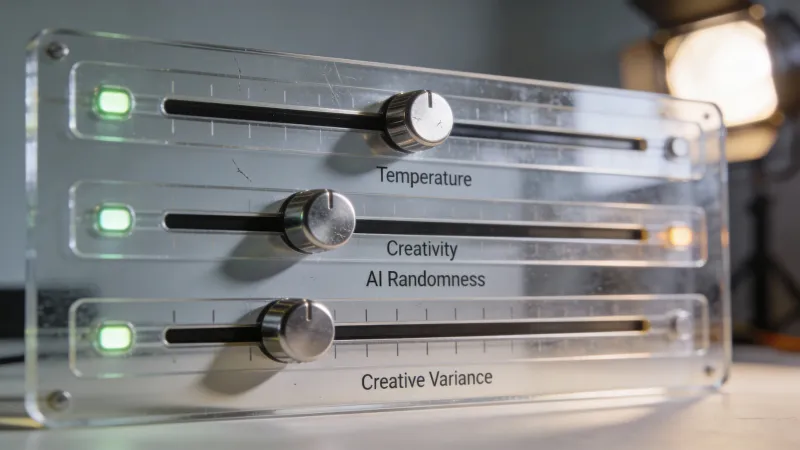

Viele KI-Oberflächen nennen ihren Temperatur-Schieberegler „Kreativität“. Das ist Marketing. Nicht Technik.

Zufall ist nicht Kreativität. Unerwartete Wörter zu wählen ist nicht dasselbe wie interessante Ideen zu haben, und dieser Unterschied ist enorm wichtig dafür, wie du über diese Einstellung nachdenken solltest.

Ein Hacker-News-Nutzer namens spywaregorilla hat es gut formuliert: Temperatur ist “more like ‘willingness to choose less likely answers.’” Diese Einordnung hilft. Weniger wahrscheinlich ist nicht dasselbe wie besser oder kreativer. Manchmal ist das weniger wahrscheinliche Wort überraschend und großartig. Manchmal ist es einfach nur falsch.

Höhere Temperatur liefert tatsächlich abwechslungsreichere Ausgaben. Das Modell erkundet mehr von seinem Wahrscheinlichkeitsraum, und diese Erkundung bringt gelegentlich Kombinationen hervor, die du bei niedriger Temperatur nie gesehen hättest. Aber „gelegentlich“ ist das Schlüsselwort. Meistens waren Wörter mit niedriger Wahrscheinlichkeit aus guten Gründen niedrig.

Ein anderer Kommentator, noodletheworld, hat es brutal klar gesagt: “Randomising LLM outputs (temperature) results in outputs that will always have some degree of hallucination. That’s just math. You can’t mix a random factor in and magically expect it to not exist.”

Das ist der Tauschhandel. Determinismus liefert Konsistenz und Langeweile. Zufall liefert Vielfalt und Fehler. Temperatur ist der Regler zwischen diesen Polen.

Das Null-Problem

Wenn Determinismus Halluzinationen vermeidet, warum dann nicht immer Temperatur null?

Weil Determinismus seine eigene Krankheit hat. Modelle bei Temperatur null bleiben hängen. Sie geraten in Schleifen. Sie wiederholen sich obsessiv. Sie greifen für alles auf die generischste, wahrscheinlichste Formulierung zurück und produzieren Text, der klingt, als hätte ihn ein vorsichtiger Bürokrat geschrieben, der nie etwas Interessantes sagen will.

Avianlyric auf Hacker News erklärte die Dynamik: “Setting the temperature of an LLM to 0 effectively disables that randomness, but the result is a very boring output that’s likely to end up caught in a never ending loop.”

Ein bisschen Zufall ist nötig, damit Ausgabe interessant wird. Die Frage ist: wie viel.

Top-p: ein anderer Ansatz

Temperatur skaliert Wahrscheinlichkeiten. Top-p (auch nucleus sampling genannt) begrenzt, welche Optionen überhaupt in Betracht gezogen werden.

Das Modell berechnet weiterhin Wahrscheinlichkeiten für jedes mögliche nächste Wort. Aber statt diese Wahrscheinlichkeiten zu skalieren, zieht top-p eine Grenze. Stellst du top-p auf 0.9, sortiert das Modell alle Wörter nach Wahrscheinlichkeit, addiert sie beginnend mit dem wahrscheinlichsten und stoppt, sobald es 90 % kumulierte Wahrscheinlichkeit erreicht. Alles unterhalb dieser Linie fällt raus. Das Modell wählt dann nur noch aus den verbleibenden Optionen.

Dieser Ansatz hat einen Vorteil, den Temperatur nicht hat. Er passt sich an.

Wenn das Modell sich sicher ist und ein Wort die Verteilung dominiert, wählt top-p natürlich aus einer kleinen Menge. Wenn das Modell unsicher ist und sich Wahrscheinlichkeiten über viele Optionen verteilen, lässt top-p mehr Kandidaten zu. Temperatur wendet dieselbe Skalierung unabhängig vom Kontext an. Top-p reagiert auf das eigene Sicherheitsgefühl des Modells.

In der Praxis sorgt top-p oft für konsistentere Ausgabequalität über verschiedene Arten von Prompts hinweg. Temperatur kann bei einem Prompt fantastisch funktionieren und beim nächsten katastrophal. Top-p glättet diese Extreme.

Top-k: das grobe Werkzeug

Top-k ist einfacher und gröber. Es betrachtet genau k Optionen, egal was passiert.

Setz top-k auf 50, und das Modell wählt nur aus den 50 wahrscheinlichsten nächsten Wörtern. Setz es auf 5, und du bekommst nur 5 Optionen. Die tatsächlichen Wahrscheinlichkeitswerte spielen für die Grenze keine Rolle, nur die Reihenfolge.

Das schafft offensichtliche Probleme. Manche Kontexte haben klare richtige Antworten, bei denen weniger als 50 Optionen sinnvoll sind. Andere sind völlig offen, bei denen 50 viel zu restriktiv ist. Top-k erkennt den Unterschied nicht.

Die meisten Produktionssysteme bevorzugen top-p gegenüber top-k. Die Anpassungsfähigkeit zählt.

Wie Einstellungen zusammenwirken

Hier wird es für viele verwirrend. Diese Parameter können zusammenarbeiten, aber oft behindern sie sich gegenseitig.

Die typische Reihenfolge ist: Wahrscheinlichkeiten berechnen, Temperaturskalierung anwenden, top-p- oder top-k-Filterung anwenden, dann aus dem Rest auswählen.

Temperatur passiert zuerst. Sie formt die gesamte Verteilung um. Dann schneidet top-p oder top-k den Schwanz ab. Das Ergebnis hängt von beiden Einstellungen ab, und das Zusammenspiel kann unvorhersehbar sein.

Die meisten Dokumentationen empfehlen, entweder das eine oder das andere zu drehen, nicht beides. Wenn du top-p nutzt, lass Temperatur bei 1.0, damit du mit der rohen Verteilung arbeitest. Wenn du Temperatur anpasst, setz top-p auf 1.0 (das schaltet es aus), damit Temperatur volle Kontrolle hat.

Beides gleichzeitig zu verstellen ist nicht „falsch“, aber es macht Ergebnisse schwerer vorherzusagen und die Fehlersuche schwerer, wenn die Ausgabe aus dem Ruder läuft.

Min-p: der Neuling

In den letzten Monaten ist die Begeisterung für einen neueren Ansatz namens min-p sampling gewachsen, besonders unter Leuten, die Open-Source-Modelle lokal laufen lassen.

Min-p setzt eine Mindestwahrscheinlichkeit relativ zur Top-Option. Wenn das wahrscheinlichste Wort 50 % Wahrscheinlichkeit hat und min-p auf 0.1 steht, wird jedes Wort mit weniger als 5 % Wahrscheinlichkeit (ein Zehntel von 50 %) entfernt.

Wie top-p passt sich das an den Kontext an. Wenn das Modell sich sicher ist, ist min-p großzügig, weil selbst moderat wahrscheinliche Optionen die Schwelle schaffen. Wenn das Modell unsicher ist, ist min-p streng, weil fast nichts eine hohe Hürde nimmt.

API-Anbieter wie OpenAI und Anthropic bieten min-p derzeit nicht an. Du begegnest dem nur, wenn du lokale Modelle über Werkzeuge wie llama.cpp oder text-generation-webui nutzt. Aber wenn du mit Modellen mit offenen Gewichten experimentierst, lohnt es sich, min-p zu verstehen.

Praktische Hinweise

Verschiedene Aufgaben verlangen verschiedene Einstellungen. Das funktioniert tatsächlich.

Für Code-Erzeugung: Niedrige Temperatur. Zwischen 0.0 und 0.3. Syntaxfehler sind nicht kreativ. Logikfehler sind keine interessanten Überraschungen. Code funktioniert oder er funktioniert nicht, und mehr Zufall erzeugt nur mehr kaputte Ausgabe.

Für Faktenfragen: Niedrige Temperatur. Die korrekte Antwort auf „Was ist die Hauptstadt von Frankreich?“ ist Paris. Es gibt keine kreative Alternative, die das verbessert. Zufall kann die Antwort nur schlechter machen.

Für Geschäftstexte: Mittlere Temperatur. Zwischen 0.3 und 0.6. Du willst professionell und sauber, nicht robotisch und repetitiv. Ein bisschen Variation hält die Sprache lebendig. Zu viel Variation bringt Fehler oder seltsame Wortwahl, die Glaubwürdigkeit zerstört.

Für kreatives Schreiben: Höhere Temperatur. Zwischen 0.7 und 1.0. Hier hilft Zufall tatsächlich. Unerwartete Wortwahl erzeugt Überraschung. Ungewöhnliche Kombinationen erzeugen frische Bilder. Du willst, dass das Modell seinen Möglichkeitsraum erkundet, nicht dass es auf Klischees zurückfällt.

Für Ideensammlung: Höchste Temperatur. Zwischen 0.9 und 1.2. Du willst ausdrücklich unerwartete Ausgabe. Du suchst Ideen, auf die du selbst nicht gekommen wärst, und der ganze Punkt ist, Optionen mit niedriger Wahrscheinlichkeit sichtbar zu machen. Erzeuge viele Varianten und sortiere danach aus.

Das Modell macht einen Unterschied

Verschiedene Modelle reagieren unterschiedlich auf Temperaturänderungen.

Größere Modelle vertragen höhere Temperaturen besser. Sie haben mehr Muster aufgenommen, mehr Wege, jeden Gedanken zu beenden. Wenn sie aus Optionen mit niedriger Wahrscheinlichkeit auswählen, sind diese Optionen immer noch durch riesiges Training geprägt. Kleinere Modelle haben dünneres Wissen. Ihre Ausgaben mit niedriger Wahrscheinlichkeit sind eher Unsinn.

Neuere Modelle kommen außerdem oft besser mit Temperatur zurecht. Verbesserungen in Training und Architektur haben die Lücke zwischen Ausgabequalität bei hoher und niedriger Temperatur verkleinert. Was bei GPT-2 Kauderwelsch produziert hätte, kann bei GPT-4 interessante alternative Formulierungen liefern.

Wenn du eine günstigere oder kleinere Modellstufe nutzt, halte Temperatur niedriger. Mit starken Modellen hast du mehr Spielraum zum Experimentieren.

Mehr als die Grundlagen

Die meisten Nutzer begegnen nur Temperatur und vielleicht top-p. API-Nutzer sehen eventuell auch:

Frequency penalty entmutigt, Wörter zu wiederholen, die in der Ausgabe bereits vorkamen. Höhere Werte bedeuten stärkere Entmutigung. Das hilft gegen das Wiederholungsproblem bei niedrigen Temperaturen, ohne reinen Zufall hinzuzufügen.

Presence penalty ermutigt, neue Themen einzuführen, statt bei dem zu bleiben, was schon erwähnt wurde. Ähnlich wie frequency penalty, aber mehr auf begriffliche Neuheit als auf Wortwiederholung.

Max tokens steuert die Ausgabelänge. Hat mit Zufall gar nichts zu tun, nur damit, wann das Modell aufhört zu generieren.

Diese Einstellungen sind vor allem für Entwickler wichtig, die Anwendungen auf Sprachmodell-APIs bauen. Für typische Chat-Nutzung sind Temperatur und top-p die, die man verstehen sollte.

Einstellungen sind keine Strategie

Das ist, was ich gern früher gewusst hätte, als ich angefangen habe, mit diesen Reglern zu experimentieren: Parameter zu justieren ist nicht dasselbe wie gute Anweisungen zu geben.

Ein brillanter Prompt bei Standardwerten schlägt einen mittelmäßigen Prompt bei perfekten Einstellungen. Klarer Kontext schlägt clevere Temperaturwahl. Konkrete Beispiele schlagen fein justierte top-p-Werte. Die Grundlagen, gut mit Sprachmodellen zu kommunizieren, sind wichtiger als Parameter-Optimierung.

Trotzdem: Parameter zählen an den Rändern. Wenn du einen guten Prompt hast, kann das Anpassen der Temperatur Ergebnisse für deinen konkreten Anwendungsfall spürbar verbessern. Die Zugewinne sind real. Sie sind nur nicht die ersten, die du jagen solltest.

Die unbequeme Wahrheit

Temperatureinstellungen zeigen etwas, worüber manche lieber nicht nachdenken: Sprachmodelle sind probabilistische Systeme, die statistische Entscheidungen treffen, keine Denkmaschinen, die zu korrekten Antworten kommen.

Wenn du Temperatur auf null stellst und deterministische Ausgabe bekommst, bekommst du nicht die richtige Antwort. Du bekommst die wahrscheinlichste Antwort. Das ist nicht dasselbe. Wenn du Temperatur hochdrehst und abwechslungsreiche Ausgabe bekommst, bekommst du keine kreativen Antworten. Du bekommst gesampelte Antworten. Das ist auch nicht dasselbe.

Das Modell weiß nicht, welches Wort korrekt ist. Es weiß, welches Wort wahrscheinlich ist. Temperatur steuert, wie streng es dieser Wahrscheinlichkeit folgt versus wie sehr es Alternativen erkundet. Weder das eine noch das andere macht das Modell schlauer oder genauer. Beides ändert nur, welche Ausgaben aus seiner Wahrscheinlichkeitsverteilung du tatsächlich zu sehen bekommst.

Diese Unterscheidung zu verstehen verändert, wie du diese Werkzeuge benutzt. Du erwartest nicht mehr, dass die „richtigen“ Einstellungen versteckte Fähigkeiten freischalten. Du fängst an, darüber nachzudenken, welche Sampling-Strategie zu deiner konkreten Aufgabe passt. Du wirst bequem mit der Realität, dass Sprachmodelle mächtig und nützlich sind und zugleich grundsätzlich anders funktionieren als das, was Menschen unter Intelligenz verstehen.

Der Temperatur-Regler ist kein Kreativitätsrad. Er ist ein Zufallsrad. Manchmal dient dir Zufall. Manchmal nicht. Den Unterschied zu kennen ist das meiste von dem, was es zu wissen gibt.