L’histoire de l’intelligence artificielle n’est pas une ligne droite qui va de débuts primitifs à un présent brillant. C’est une histoire d’échecs spectaculaires. Deux fois, des chercheurs ont déclaré victoire. Deux fois, ils se sont trompés. Le domaine a failli mourir les deux fois.

Qu’est-ce qui a fini par marcher ? Cette question compte plus que n’importe quelle chronologie.

La promesse que personne ne pouvait tenir

Avant de plonger dans la chronologie, il faut comprendre ce qui rend l’histoire de l’IA inhabituelle parmi les récits technologiques. Les premiers chercheurs n’amélioraient pas progressivement un outil existant, comme le téléphone ou l’automobile. Ils affirmaient que la pensée, la chose qui fait de nous des humains, pouvait être fabriquée. Ils affirmaient que ça arriverait bientôt.

En 1970, le magazine Life a publié un article citant Marvin Minsky : “In from three to eight years we will have a machine with the general intelligence of an average human being.” Minsky a ensuite contesté avoir jamais dit cela. Mais la citation a circulé. Elle a fixé des attentes. Et quand huit ans ont passé sans rien qui ressemble de près ou de loin à une intelligence au niveau humain, les gens l’ont remarqué.

Ce schéma s’est répété pendant des décennies. Grandes promesses. Financement. Déception. Contrecoup. Recommencer.

Pourquoi est-ce important maintenant ? Parce que vous entendez des promesses similaires aujourd’hui. Comprendre ce qui a déraillé avant vous aide à évaluer ce qui pourrait dérailler à nouveau.

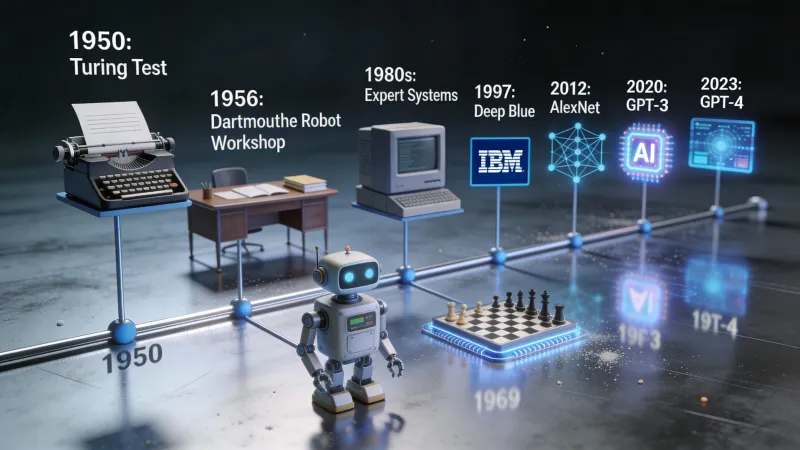

1950 : une question change tout

Alan Turing a publié en 1950 un article qui a cadré tout le domaine avant même que le domaine n’existe. L’article s’appelait “Computing Machinery and Intelligence.” La phrase d’ouverture était simple : “I propose to consider the question, ‘Can machines think?’”

Turing savait que les définitions seraient un problème. Que signifie même “penser” ? Alors il a proposé un détour. Oubliez l’idée de définir la pensée. À la place, jouez à un jeu.

Un juge humain mène des conversations écrites avec deux participants cachés. L’un est humain. L’autre est une machine. Si le juge ne peut pas dire de manière fiable qui est qui, est-ce que ça compte que la machine “pense vraiment” ?

C’est devenu le test de Turing. Il a déplacé le débat de la philosophie vers l’ingénierie. Peut-on construire quelque chose qui le réussit ? Cette question pouvait réellement être tranchée par des expériences, en construisant, en testant, en itérant.

Turing est mort en 1954. Il n’a jamais vu la recherche en IA devenir un domaine. Mais sa manière de poser le problème influence encore la façon dont nous évaluons les systèmes d’IA aujourd’hui.

1956 : un camp d’été pour l’avenir

Six ans après l’article de Turing, un groupe de chercheurs s’est réuni au Dartmouth College, dans le New Hampshire, pour un atelier d’été. John McCarthy l’a organisé. Marvin Minsky y était. Claude Shannon aussi, l’inventeur de la théorie de l’information.

La proposition qu’ils ont rédigée contient la phrase qui a défini tout ce qui a suivi : “The study is to proceed on the basis of the conjecture that every aspect of learning or any other feature of intelligence can in principle be so precisely described that a machine can be made to simulate it.”

Relisez ça. Chaque aspect de l’apprentissage. Chaque caractéristique de l’intelligence. Peut être décrit avec précision. Peut être simulé par une machine.

Ce n’était pas une affirmation modeste. C’était un pari : que l’intelligence humaine, quelle qu’elle soit, pouvait être réduite à des règles et des calculs. Qu’il n’y avait rien, dans la pensée, qui soit fondamentalement hors de portée des machines.

Le terme “artificial intelligence” a été inventé lors de cet atelier. Les chercheurs présents sont devenus les leaders du domaine pendant les quarante années suivantes. Ils étaient brillants. Ils étaient aussi d’un optimisme débridé sur les délais.

Les années 1960 : l’optimisme s’emballe

La décennie qui a suivi Dartmouth a été productive, excitante, et elle a fini par préparer le premier crash. Les chercheurs ont construit des programmes capables de démontrer des théorèmes mathématiques, de jouer aux dames, de résoudre des problèmes de mots, et de tenir des conversations simples.

ELIZA est apparu en 1966. Joseph Weizenbaum, au MIT, a créé un chatbot qui prétendait être psychothérapeute. Il fonctionnait par reconnaissance de motifs. L’utilisateur dit “Je suis triste.” ELIZA répond : “Pourquoi dites-vous que vous êtes triste ?” Aucune compréhension. Juste de la manipulation de texte.

Quelque chose d’inattendu s’est produit. Des utilisateurs ont développé des liens émotionnels avec ELIZA. Ils se confiaient à lui. Certains croyaient parler à quelque chose qui se souciait d’eux. Weizenbaum a été perturbé par ça. Il a passé le reste de sa carrière à alerter sur les dangers d’attribuer des qualités humaines aux machines.

À la fin des années 1960, les chercheurs faisaient des prédictions qui paraissent absurdes aujourd’hui. Herbert Simon disait que les machines feraient tout travail qu’un humain peut faire dans les vingt ans. Minsky affirmait que le problème de l’intelligence artificielle serait “substantially solved” en une génération.

Le financement continuait d’affluer. La DARPA a déversé de l’argent dans les labos d’IA. L’avenir semblait garanti.

1973-1980 : l’ère glaciaire arrive

Puis la réalité a frappé.

En 1973, le gouvernement britannique a demandé au mathématicien James Lighthill d’évaluer la recherche en IA. Son rapport a été dévastateur. La conclusion clé : “In no part of the field have the discoveries made so far produced the major impact that was then promised.”

Lighthill a soutenu que la recherche en IA s’était heurtée à des barrières fondamentales. Le problème de l’explosion combinatoire signifiait que les tâches du monde réel avaient trop de possibilités à explorer. Les astuces intelligentes qui marchaient sur des problèmes jouets échouaient dès qu’on s’approchait d’applications réelles.

La Grande-Bretagne a sabré les financements. Des laboratoires qui prospéraient ont vu leurs budgets s’évaporer presque du jour au lendemain. La DARPA, qui observait depuis l’autre côté de l’Atlantique, a pris peur. Elle a commencé à exiger des applications militaires pratiques plutôt que de la recherche pure. L’argent s’est tari aux États-Unis aussi.

C’était le premier hiver de l’IA. Pas un ralentissement. Un effondrement.

Pourquoi est-ce arrivé ? Les promesses étaient trop grandes. Les problèmes trop difficiles. Les ordinateurs trop lents. Les chercheurs avaient pris des succès précoces sur des problèmes contraints pour la preuve qu’une intelligence générale était proche.

L’hiver a duré environ sept ans. L’IA est devenue un risque de carrière. Utiliser le terme dans des demandes de subvention pouvait torpiller votre dossier. Les chercheurs qui sont restés dans le domaine l’ont fait discrètement, en travaillant sur des problèmes plus étroits, sous des noms moins glamour.

1980-1987 : faux printemps

L’IA est revenue. Le moteur, c’était les “expert systems”. Des programmes qui encodaient le savoir humain sous forme de règles. Si le patient a de la fièvre et de la toux et a été exposé à quelqu’un qui a la grippe, alors il a probablement la grippe. Si l’équipement fait un bruit de grincement et que le niveau d’huile est bas, alors le roulement est probablement en train de lâcher.

Les entreprises adoraient ça. Elles pouvaient capturer ce que leurs meilleurs employés savaient et le déployer à grande échelle dans l’organisation. Des ordinateurs spécialisés ont été construits uniquement pour exécuter des systèmes experts. Une entreprise appelée Symbolics vendait du matériel d’IA pour des centaines de milliers de dollars par machine.

L’investissement est revenu en masse. Les laboratoires d’IA d’entreprise ont ouvert. Le terme “artificial intelligence” est redevenu respectable. Au milieu des années 1980, l’industrie de l’IA valait des milliards de dollars.

Mais les systèmes experts avaient un problème fondamental. Ils ne pouvaient pas apprendre. Chaque morceau de connaissance devait être programmé à la main. Les maintenir était un cauchemar. À mesure que les règles s’accumulaient, ils devenaient fragiles et imprévisibles. Et quand des ordinateurs généralistes moins chers, de Sun et d’Apple, ont rattrapé leur performance, le marché du matériel spécialisé s’est effondré.

1987-1993 : le deuxième hiver

Le crash a été pire la deuxième fois. Les laboratoires d’IA d’entreprise ont fermé. Symbolics a fait faillite. Les chercheurs restants ont rebaptisé ce qu’ils faisaient en “machine learning” ou “neural networks” ou n’importe quoi qui évitait les mots toxiques “artificial intelligence”.

Si vous travailliez sur l’IA en 1990, vous ne l’auriez probablement pas admis en soirée.

Et pourtant, quelque chose d’important se produisait sous la surface. Une petite communauté de chercheurs a continué à travailler sur les réseaux neuronaux, une technologie écartée dans les années 1960. Ils ont amélioré les algorithmes. Ils ont attendu que les ordinateurs rattrapent leur retard. Et surtout, internet commençait à générer des quantités massives de texte et d’images numériques.

Les ingrédients du prochain saut étaient en train de s’assembler.

Pourquoi les hivers ont pris fin

Voilà la partie que la plupart des histoires de l’IA zappent : pourquoi les hivers ont-ils pris fin ? Qu’est-ce qui a changé ?

Trois choses ont changé.

D’abord, la puissance de calcul a continué de doubler. La loi de Moore signifiait qu’un ordinateur en 2010 était des millions de fois plus puissant qu’un ordinateur en 1970. Des problèmes informatiquement impossibles sont devenus abordables.

Ensuite, les données sont devenues abondantes. Internet a tout changé. Soudain, les chercheurs ont eu accès à des milliards de documents, des millions d’images, des enregistrements de milliers d’heures de parole. Les réseaux neuronaux ont besoin de données comme les plantes ont besoin de soleil. Internet a fourni assez de soleil pour faire pousser quelque chose de grand.

Enfin, les algorithmes se sont améliorés. La rétropropagation a rendu l’entraînement de réseaux neuronaux profonds praticable. Le dropout a évité le surapprentissage. De meilleures architectures, comme les réseaux neuronaux convolutionnels, ont bien fonctionné pour les images. Le progrès incrémental s’est accumulé jusqu’à devenir un changement qualitatif.

Aucun de ces facteurs, seul, n’était suffisant. Ensemble, ils ont créé les conditions d’une percée qui écraserait tout ce qui avait précédé.

2012 : l’année où tout a changé

En octobre 2012, une équipe de l’Université de Toronto a participé à l’ImageNet Large Scale Visual Recognition Challenge. La compétition demandait d’identifier des objets dans des photos. Un million d’images. Mille catégories.

L’équipe a utilisé un réseau neuronal profond appelé AlexNet. Geoffrey Hinton supervisait. Alex Krizhevsky a fait l’implémentation. Ilya Sutskever a apporté des idées clés.

Ils ont gagné. C’était attendu. Mais l’écart de victoire a choqué tout le monde.

AlexNet a obtenu un taux d’erreur top-5 de 15,3 %. La deuxième meilleure entrée avait 26,2 %. Ce n’est pas une petite amélioration. C’est une autre catégorie de performance. C’est la différence entre une technologie qui marche à peu près et une technologie qui marche vraiment.

Hinton a ensuite plaisanté sur la collaboration : “Ilya thought we should do it, Alex made it work, and I got the Nobel Prize.” Le Nobel est arrivé en 2024, mais le résultat d’AlexNet est ce qui a rendu tout le reste possible.

En quelques mois, toutes les grandes entreprises de la tech embauchaient des chercheurs en réseaux neuronaux. Google a racheté une startup qu’Hinton avait fondée. Facebook a ouvert un labo d’IA. Microsoft a élargi sa division de recherche. L’argent qui avait abandonné l’IA dans les années 1980 est revenu à flots.

Ce n’était pas un faux printemps. La technologie marchait réellement. Elle fonctionnait sur des problèmes réels, à une vraie échelle, avec une vraie valeur économique.

2017 : huit chercheurs changent le monde

Le point d’inflexion suivant est venu d’un article au titre étrange. Huit chercheurs de Google ont publié “Attention Is All You Need” en juin 2017. Le titre faisait référence à une chanson des Beatles. Le contenu a révolutionné le traitement automatique du langage naturel.

L’article a introduit l’architecture des transformers. Les modèles de langage précédents traitaient le texte séquentiellement, un mot à la fois. Les transformers traitent tout en parallèle, permettant à chaque mot de “prêter attention” à tous les autres, quelle que soit la distance. Cela a rendu l’entraînement bien plus rapide et a bien mieux capté les dépendances à longue portée dans le texte.

Aujourd’hui, tous les grands modèles de langage utilisent des transformers. GPT. Claude. Gemini. Llama. Tous descendent de cet article de 2017. C’est probablement la recherche la plus influente de la dernière décennie.

Les auteurs ne savaient pas ce qu’ils venaient de créer. L’article portait sur la traduction automatique. Il a fallu des années pour que les implications deviennent évidentes.

2020 : l’hypothèse de mise à l’échelle fait ses preuves

OpenAI a sorti GPT-3 en juin 2020. Il avait 175 milliards de paramètres. Il pouvait écrire des essais. Il pouvait déboguer du code. Il pouvait répondre à des questions sur presque tout. Parfois, il inventait. Mais quand ça marchait, ça marchait d’une manière presque magique.

La réaction des développeurs et des chercheurs a été intense. Un tweet viral a capturé l’instant : “Playing with GPT-3 feels like seeing the future.”

Le PDG d’OpenAI, Sam Altman, a essayé de calmer le jeu. “The GPT-3 hype is way too much,” a-t-il écrit. Mais le génie était sorti de la bouteille.

GPT-3 a prouvé quelque chose d’important. L’hypothèse de mise à l’échelle suggérait que si vous rendiez les réseaux neuronaux plus grands et que vous les entraîniez sur plus de données, ils deviendraient de plus en plus intelligents. Beaucoup de chercheurs étaient sceptiques. GPT-3 a montré que les sceptiques avaient tort.

30 novembre 2022 : le grand public découvre l’IA

ChatGPT a été lancé un mercredi. Cinq jours plus tard, le PDG d’OpenAI Sam Altman a tweeté : “ChatGPT launched on wednesday. today it crossed 1 million users!”

Deux mois après, il avait 100 millions d’utilisateurs. Aucune application grand public n’avait jamais grandi aussi vite. Ni Facebook. Ni TikTok. Ni Instagram. Rien.

Qu’est-ce qui rendait ChatGPT différent de GPT-3 ? Il était gratuit. Il était conversationnel. Il était optimisé pour être utile et inoffensif. Tout le monde pouvait l’essayer sans clé API ni carte bancaire.

C’est le moment où l’IA a cessé d’être une histoire de technologie. Vos collègues l’utilisaient. Vos parents vous en parlaient. Vos enfants faisaient leurs devoirs avec.

Le domaine qui avait failli mourir deux fois était désormais la technologie dont tout le monde parlait.

Où en sommes-nous ?

Début 2026, ChatGPT compte 800 millions d’utilisateurs actifs hebdomadaires. C’est environ 10 % de la population adulte mondiale qui utilise un seul outil d’IA. GPT-5 existe. Claude existe. Gemini existe. Les modèles open source de Meta et de Mistral ont rendu une IA puissante accessible à quiconque a du matériel correct.

L’argent qui afflue dans l’IA dépasse tout ce qu’on a vu lors des booms précédents. Des centaines de milliards de dollars. De nouveaux centres de données construits sur plusieurs continents spécifiquement pour entraîner des modèles d’IA.

Est-ce une autre bulle ? Y aura-t-il un troisième hiver ?

La réponse honnête : personne ne sait. Mais certaines choses sont différentes cette fois.

La technologie apporte une valeur réelle. ChatGPT n’est pas ELIZA. Il peut réellement aider à faire du vrai travail. Des entreprises utilisent l’IA pour écrire du code, analyser des données, résumer des documents, et des dizaines d’autres tâches qui font gagner du temps et de l’argent, pour de vrai.

Les capacités sont démontrables. Les booms précédents de l’IA reposaient sur des promesses. Celui-ci repose sur des produits que les gens peuvent utiliser aujourd’hui.

Les risques sont réels. Ces modèles hallucinent parfois. Ils peuvent être manipulés. Ils posent des questions sur l’emploi, la désinformation et la concentration du pouvoir que les systèmes d’IA précédents ne posaient pas.

Le schéma à retenir

Soixante-quinze ans d’histoire de l’IA enseignent une leçon constante. La percée mène à l’euphorie. L’euphorie mène aux promesses excessives. Les promesses excessives mènent à la déception. La déception mène à l’hiver.

Les percées depuis 2012 sont réelles. Les transformers ont changé ce qui est possible. ChatGPT a changé qui les utilise. Mais l’histoire suggère de l’humilité face aux prédictions.

Les chercheurs qui disaient, en 1965, que l’IA au niveau humain était à vingt ans se sont trompés. Les chercheurs qui disent des choses similaires aujourd’hui pourraient aussi se tromper. Ou ils pourraient avoir raison. La réponse honnête, c’est que personne ne sait.

Ce que nous savons : les outils d’IA sont utiles maintenant, pour des tâches spécifiques. Comprendre d’où ils viennent aide à séparer la réalité de l’euphorie. Cette séparation a de la valeur.

Le domaine qui est mort deux fois vaut désormais des milliers de milliards. Est-ce que ça va durer ? Cela dépend de la capacité de la technologie à continuer de livrer. Jusqu’ici, c’est le cas. Mais nous sommes déjà passés par là.