Em junho de 2018, a OpenAI publicou um artigo que quase ninguém notou. O título era seco: “Improving Language Understanding by Generative Pre-Training.” O modelo descrito tinha 117 milhões de parâmetros. Ele conseguia completar frases e responder a perguntas básicas sobre trechos de texto.

Cinco anos depois, o GPT-4 estava redigindo petições jurídicas, depurando software complexo e passando em provas profissionais em que a maioria das pessoas reprova. A progressão daquele artigo de 2018 até o sistema multimodal de 2023 representa um dos saltos de capacidade mais rápidos da história da computação.

Mas o caminho não foi reto. Incluiu uma polêmica sobre “IA perigosa” que hoje parece absurda, uma aposta em escala que muitos pesquisadores achavam errada e um lançamento de produto que ninguém previu que viraria o aplicativo de consumo que mais cresceu na história.

GPT-1: a prova que ninguém viu

O artigo original do GPT saiu num momento relativamente silencioso da pesquisa em IA. Os transformers tinham sido apresentados um ano antes. Os pesquisadores ainda estavam tentando entender do que aquela arquitetura era capaz.

A contribuição da OpenAI foi conceitual. Eles mostraram que era possível treinar um modelo de linguagem em grandes volumes de texto não rotulado e, depois, fazer o ajuste fino para tarefas específicas com pequenas quantidades de dados rotulados. Treine primeiro. Especialize depois.

Isso importa porque dados rotulados são caros. Alguém precisa ler cada exemplo e marcar se ele expressa sentimento positivo ou negativo, se contém uma entidade nomeada, se responde corretamente a uma pergunta. Conseguir milhões de exemplos rotulados custa dinheiro de verdade e leva tempo de verdade.

Texto não rotulado é, na prática, grátis. A internet o produz o tempo todo. O GPT-1 provou que dá para extrair conhecimento útil de texto bruto e, depois, aplicar esse conhecimento em tarefas posteriores com treinamento adicional mínimo.

O modelo marcou 72,8 no GLUE, um benchmark de compreensão de linguagem. O recorde anterior era 68,9. Uma melhoria significativa, mas não uma que sugerisse que a tecnologia remodelaria setores inteiros em menos de meia década.

Na época, a maioria dos pesquisadores de IA estava focada em outras abordagens. O GPT-1 era interessante. Não era, de forma óbvia, algo que mudaria o mundo.

GPT-2: a controvérsia que envelheceu mal

A OpenAI lançou o GPT-2 em fevereiro de 2019. Ele tinha 1,5 bilhão de parâmetros. Isso é, aproximadamente, treze vezes maior do que o GPT-1. O modelo conseguia gerar parágrafos coerentes sobre quase qualquer assunto.

Então aconteceu algo incomum. A OpenAI anunciou que não publicaria o modelo completo. O motivo: preocupações com mau uso. A cobertura da imprensa foi imediata. Uma IA perigosa demais para ser divulgada? As manchetes praticamente se escreveram sozinhas.

A reação da comunidade técnica foi mista e, olhando para trás, anos depois, o ceticismo se mostrou justificável. No Hacker News, o usuário empiko captou o que muita gente passou a sentir: “I remember when GPT-2 was ‘too dangerous’ to release. I am confused why people still take these clown claims seriously.”

Outros suspeitaram que o enquadramento era estratégico. O usuário sva_ observou: “The GPT2 weights have later been released which made some people suspect the ‘too dangerous to release’ stuff was mostly hype/marketing.”

A OpenAI acabou lançando o modelo completo em novembro de 2019, nove meses depois do anúncio inicial. A esperada enxurrada de desinformação gerada por IA não se materializou. Pelo menos não vinda do GPT-2.

O que importa no GPT-2 não é a controvérsia. A controvérsia envelheceu mal. O que importa é que a OpenAI demonstrou que escalar funcionava. Um modelo treze vezes maior teve desempenho dramaticamente melhor. Isso era dado, não teoria. E isso orientaria tudo o que veio depois.

GPT-3: quando os céticos estavam errados

O GPT-3 chegou em junho de 2020. Os números eram estonteantes. 175 bilhões de parâmetros. Treinado em 570 gigabytes de texto. O modelo era mais de cem vezes maior do que o GPT-2.

Muitos pesquisadores achavam isso um desperdício. Modelos maiores são caros para treinar e caros para operar. A suposição era que os retornos diminuiriam. Você não pode simplesmente continuar aumentando tudo e esperar melhorias proporcionais.

O GPT-3 provou que essa suposição estava errada.

O modelo demonstrou o que se chama de “few-shot learning” de um jeito que surpreendeu até os próprios criadores. Você podia dar a ele alguns exemplos de uma tarefa, e ele deduzia o padrão sem nenhum ajuste fino. Mostre três exemplos de frases em inglês traduzidas para o francês, e ele traduz a quarta. Mostre três perguntas com respostas, e ele responde a quarta.

Quando a OpenAI abriu a API para desenvolvedores, as reações se dividiram de forma nítida. No Hacker News, o usuário denster captou o entusiasmo: “we were just blown away. Very cool!!”

Mas nem todo mundo ficou impressionado. O usuário Barrin92 rebateu: “All GPT-3 does is generate text…it doesn’t actually understand anything.”

O CEO da OpenAI, Sam Altman, tentou moderar as expectativas. “The GPT-3 hype is way too much,” ele escreveu. “It’s impressive but it still has serious weaknesses.”

Ele tinha razão sobre as fraquezas. O modelo alucinava com confiança. Não conseguia fazer aritmética básica de forma confiável. Não tinha memória persistente entre sessões. Às vezes, gerava conteúdo tóxico ou enviesado.

Mas a aposta em escala tinha dado certo. Modelos maiores eram modelos mais inteligentes. Esse insight guiaria os três anos seguintes de desenvolvimento em IA e bilhões de dólares em investimento.

O ingrediente que faltava: tornar isso usável

O GPT-3 existiu por dois anos e meio antes do lançamento do ChatGPT. O modelo subjacente não era dramaticamente diferente. O que mudou foi a interface.

O GPT-3 exigia uma chave de API. Você precisava saber o que era um prompt. Tinha que entender que o modelo precisava de contexto e exemplos para performar bem. A barreira de entrada era real.

O ChatGPT removeu tudo isso. Grátis. Conversacional. Otimizado por aprendizado por reforço com feedback humano para ser útil e inofensivo. Você só digitava e ele respondia.

Cinco dias após o lançamento, um milhão de usuários. Dois meses depois, cem milhões. Nada na tecnologia de consumo tinha crescido tão rápido.

O modelo que as pessoas realmente conseguiam usar mudou tudo sobre como elas pensavam em IA. Antes do ChatGPT, IA era algo com que especialistas trabalhavam. Depois do ChatGPT, era algo sobre o qual sua tia te perguntava no Dia de Ação de Graças.

Isso importa para entender o GPT-4. O salto tecnológico foi real, mas o salto de adoção veio de tornar a IA avançada acessível a pessoas comuns, não apenas de capacidade bruta.

GPT-4: o salto que provou o ponto

A OpenAI anunciou o GPT-4 em 14 de março de 2023. O modelo agora conseguia processar imagens junto com texto. Você podia enviar uma foto e fazer perguntas sobre ela. Podia mostrar um diagrama e pedir uma explicação.

As melhorias de capacidade foram substanciais. O GPT-4 passou no bar exam com uma pontuação no percentil 90. O GPT-3.5 tinha ficado no percentil 10. Isso não é melhoria incremental. Isso é uma mudança qualitativa de capacidade.

No Hacker News, o usuário hooande observou o que empolgou os desenvolvedores: “The ability to dump 32k tokens into a prompt (25.000 words) seems like it will drastically expand the reasoning capability.”

A adoção nas empresas acelerou imediatamente. A Stripe integrou o GPT-4 para resumir sites de negócios para atendimento ao cliente. O Duolingo o colocou em uma nova faixa de assinatura. O Morgan Stanley criou um sistema para atender analistas financeiros. A Khan Academy desenvolveu um tutor automatizado.

A capacidade multimodal era genuinamente nova. Modelos de linguagem anteriores processavam apenas texto. O GPT-4 conseguia olhar para uma fotografia e descrever o que estava acontecendo, identificar objetos, ler texto em imagens e raciocinar sobre relações visuais.

A OpenAI reteve detalhes técnicos sobre a arquitetura e os dados de treino do GPT-4. A empresa que um dia temeu que o GPT-2 fosse perigoso demais para ser divulgado se tornou muito mais secreta sobre uma tecnologia muito mais poderosa. A ironia não passou despercebida.

O que de fato mudou entre as versões

A progressão do GPT-1 ao GPT-4 envolveu três mudanças fundamentais.

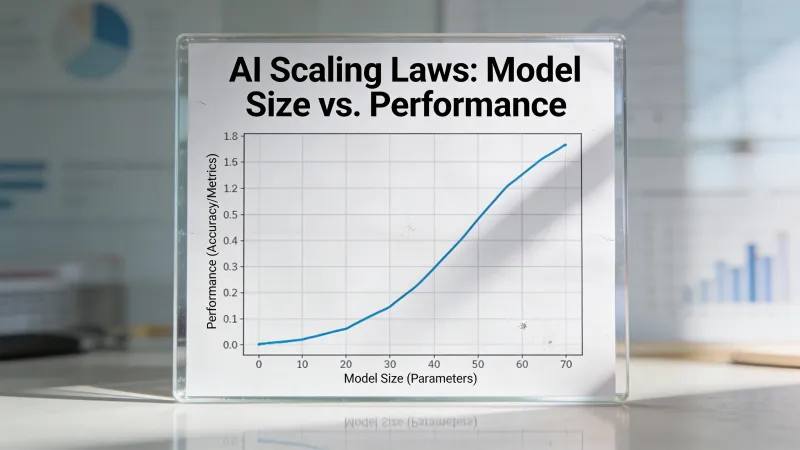

Escala. O GPT-1 tinha 117 milhões de parâmetros. A contagem de parâmetros do GPT-4 nunca foi confirmada oficialmente, mas estimativas confiáveis a colocam acima de um trilhão. Isso é, aproximadamente, um aumento de dez mil vezes em seis anos. Cada salto de escala produziu capacidades que não podiam ser previstas a partir de modelos menores.

Dados de treino. O GPT-1 treinou em livros. O GPT-3 adicionou o Common Crawl, uma raspagem massiva da web. Os dados de treino do GPT-4 continuam não divulgados, mas o modelo demonstra conhecimento que só poderia vir de uma exposição extensa a código, artigos acadêmicos e domínios especializados.

Técnicas de alinhamento. Modelos de linguagem brutos otimizam para previsão. Eles geram o texto que parece estatisticamente provável, dado o prompt. O aprendizado por reforço com feedback humano, introduzido entre o GPT-3 e o ChatGPT, ensinou os modelos a otimizar para utilidade e inocuidade. Isso tornou a tecnologia usável por pessoas comuns que não tinham ideia de como escrever prompts.

As mudanças arquiteturais foram menos dramáticas do que muita gente imagina. O GPT-4 ainda usa transformers. O mecanismo de atenção é reconhecível a partir do artigo de 2017 que começou tudo. A revolução veio de escala, dados e metodologia de treino, não de inovações arquiteturais fundamentais.

Os números contam a história

Aqui vai o que cada versão conseguia fazer, medido pelos benchmarks que importam:

O GPT-1 marcou 72,8 no GLUE. Isso superou o recorde anterior de 68,9. Progresso significativo. Não transformador.

O GPT-2 gerava texto coerente o bastante para enganar leitores casuais. Não conseguia seguir instruções de forma confiável nem manter contexto ao longo de conversas longas.

O GPT-3 introduziu a aprendizagem com poucos exemplos. Dê exemplos, e ele descobre o padrão. Foi a primeira versão que parecia genuinamente útil para trabalho real, mesmo que as saídas exigissem muita edição.

O GPT-4 passou em provas profissionais. Bar exam: percentil 90. GRE verbal: percentil 90. Provas AP em várias disciplinas: notas de aprovação. Foi a primeira versão que, de forma consistente, superou o humano médio em benchmarks cognitivos.

A distância entre “pesquisa interessante” e “ferramenta útil” aconteceu em algum ponto entre o GPT-2 e o GPT-3. A distância entre “ferramenta útil” e “potencial substituto para parte do trabalho cognitivo humano” aconteceu em algum ponto entre o GPT-3 e o GPT-4.

Por que o GPT-2 ganha mais destaque do que o GPT-1

Repare que o GPT-1 mal aparece na maioria dos relatos. Ninguém debate se o GPT-1 deveria ter sido lançado. Ninguém lembra o que pensou quando viu pela primeira vez as saídas do GPT-1.

O GPT-2 é diferente. O enquadramento do “perigoso demais” criou uma narrativa. As pessoas tinham opiniões. A controvérsia gerou cobertura que o feito técnico, sozinho, não teria gerado.

Isso importa porque revela algo sobre como a tecnologia entra na consciência pública. O GPT-1 foi importante pelo que provou tecnicamente. O GPT-2 foi importante pelo debate que iniciou. O GPT-3 foi importante por ser útil. O GPT-4 foi importante por ser bom o bastante para que as pessoas começassem a se preocupar com empregos.

Cada versão importou por razões diferentes. Entender essas razões ajuda a entender o que realmente impulsiona adoção e preocupação com IA.

O padrão que vale entender

Cada versão do GPT seguiu um padrão. A capacidade técnica saltava. A reação pública se dividia entre empolgação e ceticismo. Os danos previstos ou não se materializavam, ou se materializavam de formas inesperadas. Aplicações reais surgiam e ninguém antecipava.

Os medos de fake news em torno do GPT-2 parecem quase ingênuos hoje. O modelo que era “perigoso demais para ser divulgado” é facilmente superado por sistemas que qualquer pessoa pode acessar de graça.

As opiniões de que “GPT-3 não é tão impressionante” envelheceram mal. O modelo que alguns descartaram como um autocompletar glorificado virou a base de produtos que centenas de milhões de pessoas usam diariamente.

As preocupações sobre o GPT-4 ainda não foram resolvidas. Se ele representa progresso rumo a uma IA benéfica ou um passo rumo a sistemas que não conseguimos controlar depende de quem você pergunta e do horizonte de tempo que você considera.

O que parece claro é que cada versão deixou a IA mais capaz e mais acessível. A tecnologia que começou como uma curiosidade de pesquisa em 2018 agora está embutida em como milhões de pessoas trabalham. A distância entre o GPT-1 e o GPT-4 é a distância entre uma prova de conceito acadêmica e uma infraestrutura da qual organizações dependem.

O que vem depois

Entender essa progressão importa porque ela continua. O GPT-5 existe. Modelos concorrentes da Anthropic, do Google e da Meta empurraram as capacidades ainda mais para frente. O ritmo de melhoria não dá sinais de desacelerar.

O histórico sugere que apostar contra melhorias de capacidade é imprudente. O histórico também sugere que os impactos, positivos e negativos, vão diferir das previsões.

A única previsão que se manteve de forma consistente: a próxima versão será melhor do que a última. Quão melhor, e o que isso significa para como trabalhamos e vivemos, segue genuinamente desconhecido.

Seis anos nos levaram de um artigo que ninguém leu a uma tecnologia que 10% dos adultos usam semanalmente. Os próximos seis anos provavelmente trarão mudanças tão dramáticas quanto. Entender de onde viemos é a melhor preparação para descobrir para onde estamos indo.