En juin 2018, OpenAI publie un article que presque personne ne remarque. Le titre est aride : “Improving Language Understanding by Generative Pre-Training.” Le modèle décrit compte 117 millions de paramètres. Il peut compléter des phrases et répondre à des questions basiques sur des passages de texte.

Cinq ans plus tard, GPT-4 rédige des mémoires juridiques, débogue des logiciels complexes et réussit des examens professionnels que la plupart des humains ratent. La progression entre ce papier de 2018 et le système multimodal de 2023 représente l’un des sauts de capacités les plus rapides de l’histoire de l’informatique.

Mais le chemin n’a pas été linéaire. Il y a eu une controverse autour d’une « IA dangereuse » qui paraît absurde rétrospectivement, un pari sur l’augmentation d’échelle que beaucoup de chercheurs pensaient mauvais, et un lancement produit que personne n’imaginait devenir l’application grand public à la croissance la plus rapide jamais construite.

GPT-1 : la preuve que personne n’a vue

L’article d’origine sur GPT arrive à un moment plutôt calme de la recherche en IA. Les transformers ont été introduits un an plus tôt. Les chercheurs sont encore en train de comprendre ce que l’architecture peut faire.

La contribution d’OpenAI est surtout conceptuelle. Ils montrent qu’on peut entraîner un modèle de langage sur des quantités massives de texte non annoté, puis l’affiner pour des tâches spécifiques avec de petites quantités de données annotées. D’abord entraîner. Ensuite spécialiser.

C’est important parce que les données annotées coûtent cher. Quelqu’un doit lire chaque exemple et indiquer s’il exprime un sentiment positif ou négatif, s’il contient une entité nommée, s’il répond correctement à une question. Obtenir des millions d’exemples annotés coûte de l’argent et prend du temps.

Le texte non annoté, lui, est pratiquement gratuit. Internet en produit en continu. GPT-1 prouve qu’on peut extraire des connaissances utiles à partir de texte brut, puis appliquer ces connaissances à des tâches en aval avec un minimum d’entraînement supplémentaire.

Le modèle obtient 72.8 sur GLUE, un test de référence pour la compréhension du langage. Le record précédent était 68.9. Une amélioration significative, mais pas de quoi penser que la technologie allait remodeler des industries entières en moins d’une demi-décennie.

À l’époque, la plupart des chercheurs en IA se concentrent sur d’autres approches. GPT-1 est intéressant. Il n’a pas, à première vue, l’air de changer le monde.

GPT-2 : la polémique qui a mal vieilli

OpenAI sort GPT-2 en février 2019. Il a 1,5 milliard de paramètres. C’est environ treize fois plus que GPT-1. Le modèle peut générer des paragraphes cohérents sur à peu près n’importe quel sujet.

Puis il se passe quelque chose d’inhabituel. OpenAI annonce qu’ils ne publieront pas le modèle complet. Motif : le risque de mésusage. La presse s’empare immédiatement de l’histoire. Une IA trop dangereuse pour être publiée ? Les gros titres s’écrivent tout seuls.

La réaction de la communauté technique est partagée et, des années plus tard, on peut dire que le scepticisme était justifié. Sur Hacker News, l’utilisateur empiko résume ce que beaucoup finiront par penser : “I remember when GPT-2 was ‘too dangerous’ to release. I am confused why people still take these clown claims seriously.”

D’autres soupçonnent une mise en scène stratégique. L’utilisateur sva_ note : “The GPT2 weights have later been released which made some people suspect the ‘too dangerous to release’ stuff was mostly hype/marketing.”

OpenAI finit par publier le modèle complet en novembre 2019, neuf mois après l’annonce initiale. Le flot attendu de désinformation générée par IA ne se matérialise pas. En tout cas, pas avec GPT-2.

Ce qui compte avec GPT-2, ce n’est pas la polémique. La polémique a mal vieilli. Ce qui compte, c’est qu’OpenAI démontre que l’augmentation d’échelle fonctionne. Un modèle treize fois plus grand se comporte nettement mieux. C’est un fait, pas une théorie. Ça va guider tout ce qui suit.

GPT-3 : quand les sceptiques ont eu tort

GPT-3 arrive en juin 2020. Les chiffres donnent le vertige. 175 milliards de paramètres. Entraîné sur 570 gigaoctets de texte. Le modèle est plus de cent fois plus grand que GPT-2.

Beaucoup de chercheurs pensent que c’est du gaspillage. Les gros modèles coûtent cher à entraîner et cher à exécuter. L’hypothèse : les gains allaient s’essouffler. On ne peut pas juste continuer à grossir et s’attendre à des améliorations proportionnelles.

GPT-3 prouve que cette hypothèse est fausse.

Le modèle montre un « apprentissage à partir de quelques exemples » d’une manière qui surprend même ses créateurs. On peut lui donner quelques exemples d’une tâche, et il comprend le schéma sans aucun affinage. Montrez-lui trois exemples de phrases anglaises traduites en français, et il traduira la quatrième. Montrez-lui trois questions avec leurs réponses, et il répondra à la quatrième.

Quand OpenAI ouvre l’API aux développeurs, les réactions se polarisent. Sur Hacker News, l’utilisateur denster capte l’enthousiasme : “we were just blown away. Very cool!!”

Mais tout le monde n’est pas convaincu. L’utilisateur Barrin92 réplique : “All GPT-3 does is generate text…it doesn’t actually understand anything.”

Le PDG d’OpenAI, Sam Altman, essaie de calmer le jeu. “The GPT-3 hype is way too much,” écrit-il. “It’s impressive but it still has serious weaknesses.”

Il a raison sur les faiblesses. Le modèle hallucine avec assurance. Il ne sait pas faire de l’arithmétique basique de façon fiable. Il n’a pas de mémoire persistante d’une session à l’autre. Il génère parfois du contenu toxique ou biaisé.

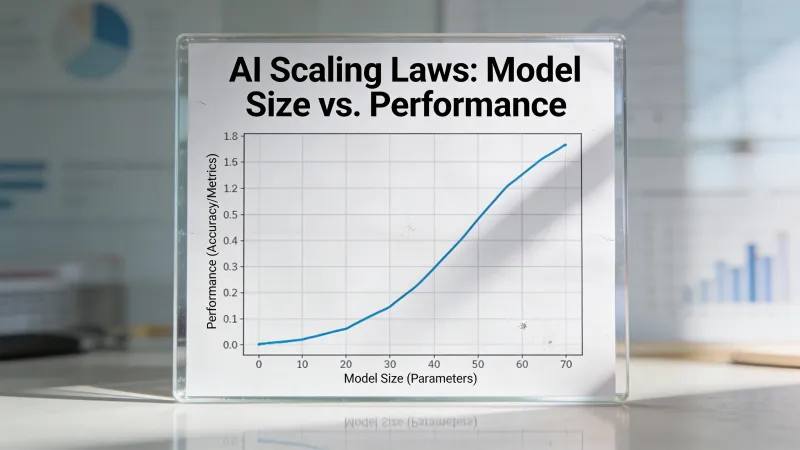

Mais le pari sur la taille a payé. Des modèles plus gros sont des modèles plus intelligents. Cette idée va alimenter les trois années suivantes de développement de l’IA et des milliards de dollars d’investissement.

L’ingrédient manquant : le rendre utilisable

GPT-3 existe pendant deux ans et demi avant le lancement de ChatGPT. Le modèle sous-jacent n’est pas radicalement différent. Ce qui change, c’est l’interface.

GPT-3 exige une clé API. Il faut savoir ce qu’est une consigne (un « prompt »). Il faut comprendre que le modèle a besoin de contexte et d’exemples pour bien fonctionner. La barrière à l’entrée est réelle.

ChatGPT supprime tout ça. Gratuit. En mode conversation. Optimisé, via un apprentissage par renforcement à partir de retours humains, pour être utile et inoffensif. On tape, il répond.

Cinq jours après le lancement : un million d’utilisateurs. Deux mois plus tard : cent millions. Rien, dans la technologie grand public, n’a grandi aussi vite.

Le modèle que les gens peuvent réellement utiliser change tout dans la façon dont ils pensent l’IA. Avant ChatGPT, l’IA est quelque chose avec quoi travaillent des spécialistes. Après ChatGPT, c’est quelque chose dont votre tante vous parle à Thanksgiving.

C’est important pour comprendre GPT-4. Le saut technologique est réel, mais le saut d’adoption vient du fait d’avoir rendu une IA avancée accessible à des gens ordinaires, pas de la capacité brute à elle seule.

GPT-4 : le saut qui a donné raison

OpenAI annonce GPT-4 le 14 mars 2023. Le modèle peut désormais traiter des images en plus du texte. On peut envoyer une photo et poser des questions dessus. On peut lui montrer un diagramme et demander une explication.

Les améliorations de capacité sont substantielles. GPT-4 réussit l’examen du barreau avec un score dans le 90e percentile. GPT-3.5 avait obtenu un score dans le 10e percentile. Ce n’est pas une progression incrémentale. C’est un changement qualitatif de capacité.

Sur Hacker News, l’utilisateur hooande note ce qui excite les développeurs : “The ability to dump 32k tokens into a prompt (25 000 words) seems like it will drastically expand the reasoning capability.”

L’adoption en entreprise s’accélère immédiatement. Stripe intègre GPT-4 pour résumer des sites d’entreprise au support client. Duolingo l’intègre dans un nouveau palier d’abonnement. Morgan Stanley crée un système pour servir les analystes financiers. Khan Academy développe un tuteur automatisé.

La capacité multimodale est vraiment nouvelle. Les modèles de langage précédents ne traitent que du texte. GPT-4 peut regarder une photo et décrire ce qui se passe, identifier des objets, lire du texte dans des images et raisonner sur des relations visuelles.

OpenAI retient les détails techniques de l’architecture et des données d’entraînement de GPT-4. L’entreprise qui, autrefois, craignait que GPT-2 soit trop dangereux pour être publié devient bien plus secrète à propos d’une technologie bien plus puissante. L’ironie n’échappe à personne.

Ce qui a vraiment changé entre les versions

La progression de GPT-1 à GPT-4 implique trois bascules fondamentales.

Échelle. GPT-1 a 117 millions de paramètres. Le nombre de paramètres de GPT-4 n’a jamais été confirmé officiellement, mais des estimations crédibles le placent au-delà d’un trillion. C’est environ un facteur dix mille en six ans. Chaque saut d’échelle produit des capacités qu’on ne pouvait pas prédire à partir de modèles plus petits.

Données d’entraînement. GPT-1 s’entraîne sur des livres. GPT-3 ajoute Common Crawl, une énorme collecte du web. Les données d’entraînement de GPT-4 restent inconnues, mais le modèle montre des connaissances qui ne peuvent venir que d’une exposition massive au code, aux articles académiques et à des domaines spécialisés.

Techniques d’alignement. Les modèles de langage bruts optimisent la prédiction. Ils génèrent le texte qui paraît statistiquement le plus probable compte tenu de la consigne. L’apprentissage par renforcement à partir de retours humains, introduit entre GPT-3 et ChatGPT, apprend aux modèles à optimiser plutôt l’aide et l’innocuité. C’est ce qui rend la technologie utilisable par des gens ordinaires qui n’ont aucune idée de comment formuler des consignes.

Les changements d’architecture sont moins dramatiques qu’on ne le pense souvent. GPT-4 utilise toujours des transformers. Le mécanisme d’attention est reconnaissable depuis l’article de 2017 qui a tout déclenché. La révolution vient de l’échelle, des données et de la méthodologie d’entraînement, pas d’innovations architecturales fondamentales.

Les chiffres racontent l’histoire

Voici ce que chaque version sait faire, mesuré par les tests de référence qui comptent :

GPT-1 obtient 72.8 sur GLUE. Ça bat le record précédent de 68.9. Un progrès réel. Pas une transformation.

GPT-2 génère un texte suffisamment cohérent pour tromper un lecteur distrait. Il ne suit pas des instructions de façon fiable et ne maintient pas bien le contexte sur de longues conversations.

GPT-3 introduit l’apprentissage à partir de quelques exemples. Donnez-lui des exemples, et il comprend le schéma. C’est la première version qui semble vraiment utile pour du travail réel, même si les sorties demandent beaucoup de retouches.

GPT-4 réussit des examens professionnels. Examen du barreau : 90e percentile. GRE verbal : 90e percentile. Examens AP dans plusieurs matières : scores de réussite. C’est la première version qui surpasse de façon constante l’humain moyen sur des tests de référence cognitifs.

L’écart entre « recherche intéressante » et « outil utile » se situe quelque part entre GPT-2 et GPT-3. L’écart entre « outil utile » et « remplaçant potentiel d’une partie du travail cognitif humain » se situe quelque part entre GPT-3 et GPT-4.

Pourquoi on parle plus de GPT-2 que de GPT-1

Remarquez que GPT-1 apparaît à peine dans la plupart des récits. Personne ne débat de la question de savoir si GPT-1 aurait dû être publié. Personne ne se souvient de ce qu’il pensait en voyant les premières sorties de GPT-1.

GPT-2 est différent. Le cadrage « trop dangereux » crée une histoire. Les gens ont des opinions. La polémique produit une couverture médiatique que la prouesse technique seule n’aurait pas obtenue.

Et c’est révélateur de la façon dont une technologie entre dans la conscience du public. GPT-1 est important pour ce qu’il prouve techniquement. GPT-2 est important pour le débat qu’il déclenche. GPT-3 est important parce qu’il est utile. GPT-4 est important parce qu’il est assez bon pour que les gens commencent à s’inquiéter pour les emplois.

Chaque version compte pour des raisons différentes. Comprendre ces raisons aide à comprendre ce qui pousse vraiment à l’adoption de l’IA… et à l’inquiétude.

Le schéma à comprendre

Chaque version de GPT suit un schéma. Les capacités techniques bondissent. La réaction du public se scinde entre excitation et scepticisme. Les dégâts annoncés ne se matérialisent pas, ou se matérialisent d’une manière inattendue. Des applications réelles apparaissent que personne n’avait anticipées.

Les peurs de fausses informations autour de GPT-2 paraissent presque naïves aujourd’hui. Le modèle « trop dangereux pour être publié » est ridiculement dépassé par des systèmes auxquels tout le monde peut accéder gratuitement.

Les avis du type « GPT-3 n’est pas si impressionnant » ont mal vieilli. Le modèle que certains réduisaient à un simple autocompléteur est devenu la base de produits que des centaines de millions de personnes utilisent chaque jour.

Les inquiétudes autour de GPT-4, elles, ne sont pas tranchées. Qu’il s’agisse d’un pas vers une IA bénéfique ou d’un pas vers des systèmes qu’on ne peut pas contrôler dépend de qui vous demandez… et de l’horizon temporel que vous choisissez.

Ce qui semble clair, c’est que chaque version rend l’IA plus capable et plus accessible. La technologie qui commence comme une curiosité de recherche en 2018 est maintenant intégrée dans la façon dont des millions de personnes travaillent. L’écart entre GPT-1 et GPT-4, c’est l’écart entre une preuve de concept académique et une infrastructure dont les organisations dépendent.

Ce qui vient ensuite

Comprendre cette progression compte parce qu’elle continue. GPT-5 existe. Des modèles concurrents d’Anthropic, Google et Meta ont poussé les capacités plus loin. Le rythme d’amélioration ne montre aucun signe de ralentissement.

L’historique suggère qu’il est imprudent de parier contre des améliorations de capacité. Il suggère aussi que les impacts, positifs comme négatifs, seront différents des prédictions.

La seule prédiction qui s’est tenue de façon constante : la prochaine version sera meilleure que la dernière. À quel point, et ce que cela signifie pour notre façon de travailler et de vivre, reste franchement inconnu.

En six ans, on est passé d’un papier que personne ne lisait à une technologie que 10 % des adultes utilisent chaque semaine. Les six prochaines années apporteront probablement des changements tout aussi dramatiques. Comprendre d’où l’on vient est la meilleure préparation pour savoir où l’on va.