A história da inteligência artificial não é uma linha reta de começos primitivos até um presente brilhante. É uma história de fracassos espetaculares. Duas vezes, pesquisadores declararam vitória. Duas vezes, estavam errados. O campo quase morreu nas duas.

O que foi que finalmente funcionou? Essa pergunta importa mais do que qualquer linha do tempo.

A promessa que ninguém conseguia cumprir

Antes de entrar na cronologia, entenda o que torna a história da IA incomum entre histórias de tecnologia. Os primeiros pesquisadores não estavam melhorando, pouco a pouco, uma ferramenta já existente como o telefone ou o automóvel. Eles estavam afirmando que pensar — a coisa que torna humanos humanos — podia ser fabricado. E que isso ia acontecer logo.

Em 1970, a revista Life publicou um artigo citando Marvin Minsky: “In from three to eight years we will have a machine with the general intelligence of an average human being.” Minsky depois contestou ter dito isso. Mas a frase circulou. Criou expectativas. E quando se passaram oito anos sem nada sequer perto de inteligência em nível humano, as pessoas perceberam.

Esse padrão se repetiu por décadas. Afirmações ousadas. Financiamento. Decepção. Reação contrária. Repetir.

Por que isso importa agora? Porque você está ouvindo afirmações parecidas hoje. Entender o que deu errado antes ajuda você a avaliar o que pode dar errado de novo.

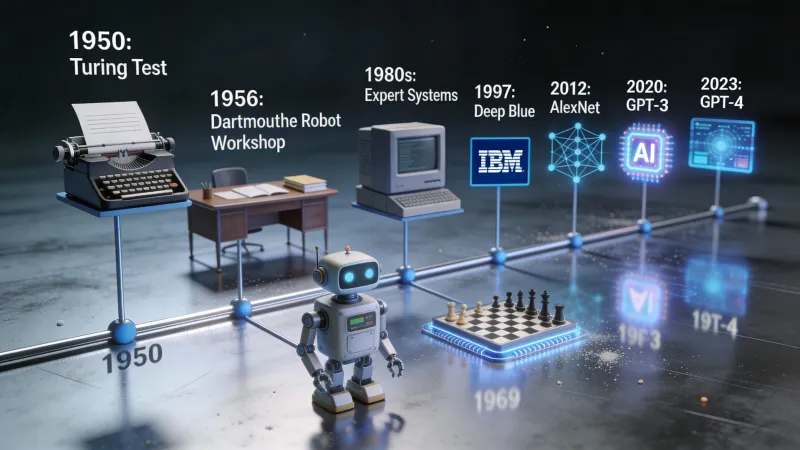

1950: uma pergunta muda tudo

Alan Turing publicou, em 1950, um artigo que moldou todo o campo antes mesmo de o campo existir. O artigo se chamava “Computing Machinery and Intelligence.” A linha de abertura era simples: “I propose to consider the question, ‘Can machines think?’”

Turing sabia que definições seriam um problema. O que “pensar” sequer significa? Então ele propôs um atalho. Esqueça tentar definir pensamento. Em vez disso, jogue um jogo.

Um juiz humano tem conversas por texto com dois participantes ocultos. Um é humano. Um é uma máquina. Se o juiz não consegue distinguir com confiabilidade qual é qual, importa se a máquina “realmente” pensa?

Isso virou o teste de Turing. Ele deslocou o debate da filosofia para a engenharia. Dá para construir algo que passa? Essa pergunta, de fato, podia ser respondida com experimentos: construir, testar e iterar.

Turing morreu em 1954. Ele não viu a pesquisa em IA virar um campo. Mas o enquadramento dele ainda influencia como avaliamos sistemas de IA hoje.

1956: um acampamento de verão do futuro

Seis anos depois do artigo de Turing, um grupo de pesquisadores se reuniu no Dartmouth College, em New Hampshire, para um workshop de verão. John McCarthy organizou. Marvin Minsky estava lá. Claude Shannon também, o inventor da teoria da informação.

A proposta que eles escreveram contém a frase que definiu tudo que veio depois: “The study is to proceed on the basis of the conjecture that every aspect of learning or any other feature of intelligence can in principle be so precisely described that a machine can be made to simulate it.”

Leia de novo. Todo aspecto de aprendizagem. Toda característica de inteligência. Pode ser descrita com precisão. Pode ser simulada por uma máquina.

Isso não era uma afirmação modesta. Era uma aposta de que a inteligência humana, seja lá o que ela for, podia ser reduzida a regras e cálculos. E de que nada em pensar estava, por princípio, além do que máquinas poderiam fazer.

O termo “inteligência artificial” foi cunhado nesse workshop. Os pesquisadores que participaram viraram os líderes do campo pelos quarenta anos seguintes. Eram brilhantes. E também tinham um otimismo totalmente fora da realidade com prazos.

Anos 1960: o otimismo sai do controle

A década depois de Dartmouth foi produtiva e empolgante e, no fim, preparou o terreno para a primeira queda. Pesquisadores construíram programas que provavam teoremas matemáticos, jogavam damas, resolviam problemas de palavras e mantinham conversas simples.

ELIZA apareceu em 1966. Joseph Weizenbaum, no MIT, criou um chatbot que fingia ser um psicoterapeuta. Funcionava por correspondência de padrões. O usuário diz “Estou triste.” ELIZA responde: “Por que você diz que está triste?” Sem compreensão. Só manipulação de texto.

Algo inesperado aconteceu. Usuários criaram vínculos emocionais com ELIZA. Confidenciavam coisas a ela. Alguns acreditavam estar falando com algo que se importava. Weizenbaum ficou perturbado com isso. Ele passou o resto da carreira alertando sobre os perigos de atribuir qualidades humanas a máquinas.

No fim dos anos 1960, pesquisadores faziam previsões que hoje parecem absurdas. Herbert Simon disse que máquinas fariam qualquer trabalho que um humano pudesse fazer dentro de vinte anos. Minsky afirmou que o problema da inteligência artificial estaria “substantially solved” dentro de uma geração.

O financiamento continuava chegando. A DARPA despejava dinheiro em laboratórios de IA. O futuro parecia garantido.

1973-1980: chega a era do gelo

Aí a realidade bateu.

Em 1973, o governo do Reino Unido encomendou ao matemático James Lighthill uma avaliação da pesquisa em IA. O relatório foi devastador. A conclusão-chave: “In no part of the field have the discoveries made so far produced the major impact that was then promised.”

Lighthill argumentou que a pesquisa em IA tinha esbarrado em barreiras fundamentais. O problema da “explosão combinatória” significava que tarefas do mundo real tinham possibilidades demais para vasculhar. Os truques inteligentes que funcionavam em problemas de brinquedo falhavam em qualquer coisa que parecesse uma aplicação de verdade.

A Grã-Bretanha cortou o financiamento de IA. Laboratórios de pesquisa que prosperavam viram seus orçamentos sumirem quase do dia para a noite. A DARPA, observando do outro lado do Atlântico, ficou nervosa. Passou a exigir aplicações militares práticas em vez de pesquisa pura. O dinheiro também secou nos Estados Unidos.

Esse foi o primeiro inverno da IA. Não uma desaceleração. Um colapso.

Por que aconteceu? As promessas eram grandes demais. Os problemas eram difíceis demais. Os computadores eram lentos demais. Pesquisadores confundiram sucessos iniciais em problemas restritos com evidência de que a inteligência geral estava perto.

O inverno durou aproximadamente sete anos. IA virou um risco de carreira. Usar o termo em pedidos de financiamento podia afundar a sua proposta. Pesquisadores que permaneceram no campo o fizeram em silêncio, trabalhando em problemas mais estreitos com nomes menos glamorosos.

1980-1987: falsa primavera

A IA voltou. O motor foram os “sistemas especialistas”. Eram programas que codificavam conhecimento humano como regras. Se o paciente tem febre e tosse e contato com alguém com gripe, então o paciente provavelmente tem gripe. Se o equipamento faz um barulho de moagem e o nível de óleo está baixo, então o rolamento provavelmente está falhando.

Empresas adoraram isso. Negócios podiam capturar o que seus melhores funcionários sabiam e escalar isso pela organização. Computadores especializados foram construídos só para rodar sistemas especialistas. Uma empresa chamada Symbolics vendia hardware de IA por centenas de milhares de dólares por máquina.

O investimento voltou com força. Laboratórios corporativos de IA abriram. O termo “inteligência artificial” voltou a ser respeitável. Em meados dos anos 1980, a indústria de IA valia bilhões de dólares.

Mas sistemas especialistas tinham um problema fundamental. Eles não conseguiam aprender. Cada pedaço de conhecimento precisava ser programado à mão. Manter aquilo era um pesadelo. À medida que as regras se acumulavam, os sistemas ficavam frágeis e imprevisíveis. E quando computadores mais baratos, de uso geral, da Sun e da Apple alcançaram desempenho semelhante, o mercado de hardware especializado colapsou.

1987-1993: o segundo inverno

A queda foi pior na segunda vez. Laboratórios corporativos de IA fecharam. A Symbolics faliu. Os pesquisadores de IA que restaram rebatizaram o que faziam como “aprendizado de máquina” ou “redes neurais” ou qualquer coisa que evitasse as palavras tóxicas “inteligência artificial”.

Se você trabalhava com IA em 1990, provavelmente não admitia isso em festas.

Ainda assim, algo importante estava acontecendo por baixo da superfície. Uma pequena comunidade de pesquisadores continuou trabalhando com redes neurais, uma tecnologia descartada nos anos 1960. Eles melhoraram os algoritmos. Esperaram os computadores alcançarem. E, o mais importante, a internet estava começando a gerar quantidades gigantescas de texto e imagens digitais.

Os ingredientes para a próxima virada estavam se juntando sozinhos.

Por que os invernos acabaram

Aqui está a parte que a maioria das histórias de IA pula: por que os invernos acabaram? O que mudou?

Três coisas mudaram.

Primeiro, o poder de computação continuou dobrando. A Lei de Moore significava que um computador em 2010 era milhões de vezes mais poderoso do que um em 1970. Problemas que eram computacionalmente impossíveis viraram viáveis.

Segundo, dados ficaram abundantes. A internet mudou tudo. De repente, pesquisadores tinham acesso a bilhões de documentos, milhões de imagens, gravações de milhares de horas de fala. Redes neurais precisam de dados como plantas precisam de luz do sol. A internet forneceu luz suficiente para crescer algo grande.

Terceiro, os algoritmos melhoraram. A retropropagação tornou viável treinar redes neurais profundas. Dropout evitou o sobreajuste. Arquiteturas melhores, como redes neurais convolucionais, funcionaram bem para imagens. O progresso incremental foi se acumulando até virar mudança qualitativa.

Nenhum desses fatores sozinho bastava. Juntos, criaram as condições para um avanço que ofuscaria tudo o que veio antes.

2012: o ano em que tudo mudou

Em outubro de 2012, uma equipe da Universidade de Toronto entrou no ImageNet Large Scale Visual Recognition Challenge. A competição exigia identificar objetos em fotografias. Um milhão de imagens. Mil categorias.

A equipe usou uma rede neural profunda chamada AlexNet. Geoffrey Hinton supervisionou. Alex Krizhevsky fez a implementação. Ilya Sutskever contribuiu com ideias-chave.

Eles venceram. Isso era esperado. Mas a margem de vitória chocou todo mundo.

O AlexNet alcançou uma taxa de erro top-5 de 15,3%. O segundo melhor ficou em 26,2%. Isso não é uma melhora pequena. Isso é outra categoria de desempenho. É a diferença entre uma tecnologia que meio que funciona e uma que realmente funciona.

Hinton depois brincou sobre a colaboração: “Ilya thought we should do it, Alex made it work, and I got the Nobel Prize.” O Nobel veio em 2024, mas o resultado do AlexNet foi o que tornou todo o resto possível.

Em poucos meses, toda grande empresa de tecnologia estava contratando pesquisadores de redes neurais. A Google comprou uma startup que Hinton tinha fundado. O Facebook abriu um laboratório de IA. A Microsoft ampliou sua divisão de pesquisa. O dinheiro que tinha abandonado a IA nos anos 1980 voltou correndo.

Isso não era uma falsa primavera. A tecnologia realmente funcionou. Funcionou em problemas reais, em escala real, com valor econômico real.

2017: oito pesquisadores mudam o mundo

O próximo ponto de inflexão veio de um artigo com um título estranho. Oito pesquisadores do Google publicaram “Attention Is All You Need” em junho de 2017. O título fazia referência a uma música dos Beatles. O conteúdo revolucionou o processamento de linguagem natural.

O artigo introduziu a arquitetura transformer. Modelos de linguagem anteriores processavam texto sequencialmente, uma palavra por vez. Transformers processam tudo em paralelo, permitindo que cada palavra “preste atenção” em todas as outras independentemente da distância. Isso tornou o treinamento muito mais rápido e capturou dependências de longo alcance no texto muito melhor.

Hoje, todo grande modelo de linguagem usa transformers. GPT. Claude. Gemini. Llama. Todos descendem daquele artigo de 2017. Provavelmente é a pesquisa em IA mais influente da última década.

Os autores não sabiam o que tinham criado. O artigo era sobre tradução automática. Levou anos para as implicações ficarem claras.

2020: a hipótese de escala se prova

A OpenAI lançou o GPT-3 em junho de 2020. Ele tinha 175 bilhões de parâmetros. Conseguia escrever redações. Conseguia depurar código. Conseguia responder perguntas sobre quase qualquer coisa. Às vezes inventava coisas. Mas quando funcionava, funcionava de um jeito que parecia quase mágico.

A reação de desenvolvedores e pesquisadores foi intensa. Um tweet viral capturou o momento: “Playing with GPT-3 feels like seeing the future.”

O CEO da OpenAI, Sam Altman, tentou diminuir as expectativas. “The GPT-3 hype is way too much,” ele escreveu. Mas o gênio já tinha saído da garrafa.

O GPT-3 provou algo importante. A hipótese de escala sugeria que, se você fizesse redes neurais maiores e as treinasse com mais dados, elas continuariam ficando mais inteligentes. Muitos pesquisadores eram céticos. O GPT-3 mostrou que os céticos estavam errados.

30 de novembro de 2022: o público descobre a IA

O ChatGPT foi lançado numa quarta-feira. Cinco dias depois, o CEO da OpenAI, Sam Altman, tweetou: “ChatGPT launched on wednesday. today it crossed 1 million users!”

Dois meses depois disso, ele tinha 100 milhões de usuários. Nenhum aplicativo de consumo jamais cresceu tão rápido. Nem o Facebook. Nem o TikTok. Nem o Instagram. Nada.

O que tornava o ChatGPT diferente do GPT-3? Era grátis. Era conversacional. Era otimizado para ser útil e inofensivo. Qualquer pessoa podia testar sem uma chave de API ou um cartão de crédito.

Esse foi o momento em que a IA deixou de ser uma história de tecnologia. Seus colegas de trabalho estavam usando. Seus pais estavam perguntando. Seus filhos estavam fazendo a lição de casa com isso.

O campo que quase tinha morrido duas vezes agora era a tecnologia mais comentada do mundo.

Onde estamos agora?

No começo de 2026, o ChatGPT tem 800 milhões de usuários ativos semanais. Isso é algo como 10% da população adulta do mundo usando uma ferramenta de IA. O GPT-5 existe. O Claude existe. O Gemini existe. Modelos de código aberto da Meta e da Mistral tornaram a IA poderosa acessível a qualquer pessoa com um hardware decente.

O dinheiro entrando em IA faz qualquer coisa de booms anteriores parecer pequena. Centenas de bilhões de dólares. Novos centros de dados sendo construídos em múltiplos continentes especificamente para treinar modelos de IA.

Isso é mais uma bolha? Vai haver um terceiro inverno?

A resposta honesta: ninguém sabe. Mas algumas coisas são diferentes desta vez.

A tecnologia entrega valor real. O ChatGPT não é o ELIZA. Ele pode de fato ajudar com trabalho de verdade. Empresas estão usando IA para escrever código, analisar dados, resumir documentos e dezenas de outras tarefas que economizam tempo e dinheiro de verdade.

As capacidades são demonstráveis. Booms anteriores de IA viviam de promessas. Este vive de produtos que as pessoas podem usar hoje.

Os riscos são reais. Esses modelos às vezes alucinam. Podem ser manipulados. Levantam questões sobre empregos, desinformação e concentração de poder que sistemas anteriores de IA nunca colocaram.

O padrão que vale lembrar

Setenta e cinco anos de história da IA ensinam uma lição consistente. Avanço leva à euforia. Euforia leva a prometer demais. Prometer demais leva à decepção. Decepção leva ao inverno.

Os avanços desde 2012 são reais. Transformers mudaram o que é possível. O ChatGPT mudou quem usa. Mas a história sugere humildade com previsões.

Os pesquisadores que diziam, em 1965, que IA em nível humano estava a vinte anos de distância estavam errados. Os pesquisadores dizendo coisas parecidas hoje podem estar errados também. Ou podem estar certos. A resposta honesta é que ninguém sabe.

O que sabemos: ferramentas de IA são úteis agora para tarefas específicas. Entender de onde elas vieram ajuda a separar realidade de euforia. Essa separação tem valor.

O campo que morreu duas vezes agora vale trilhões. Se vai continuar assim depende de a tecnologia continuar entregando. Até agora, entregou. Mas já estivemos aqui antes.