Die Geschichte der künstlichen Intelligenz ist keine gerade Linie von primitiven Anfängen bis zur glanzvollen Gegenwart. Sie ist eine Geschichte spektakulärer Fehlschläge. Zweimal erklärten Forschende den Sieg. Zweimal lagen sie falsch. Zweimal wäre das Feld beinahe gestorben.

Was hat am Ende funktioniert? Diese Frage ist wichtiger als jede Zeitachse.

Das Versprechen, das niemand einlösen konnte

Bevor wir in die Chronologie eintauchen, lohnt sich ein Blick darauf, was die KI-Geschichte unter Technikgeschichten so ungewöhnlich macht. Die frühen Forschenden verbesserten nicht schrittweise ein bestehendes Werkzeug wie das Telefon oder das Auto. Sie behaupteten, Denken, das, was Menschen zu Menschen macht, könne hergestellt werden. Und sie behaupteten, das werde bald passieren.

1970 veröffentlichte das Life Magazine einen Artikel, in dem Marvin Minsky zitiert wurde: “In from three to eight years we will have a machine with the general intelligence of an average human being.” Minsky bestritt später, das je gesagt zu haben. Aber das Zitat kursierte. Es setzte Erwartungen. Und als acht Jahre vergingen, ohne dass auch nur etwas in die Nähe von menschenähnlicher Intelligenz kam, fiel es auf.

Dieses Muster wiederholte sich über Jahrzehnte. Große Behauptungen. Geld. Enttäuschung. Gegenreaktion. Wieder von vorn.

Warum ist das heute wichtig? Weil Sie heute ähnliche Behauptungen hören. Wer versteht, was damals schiefging, kann besser einschätzen, was wieder schiefgehen könnte.

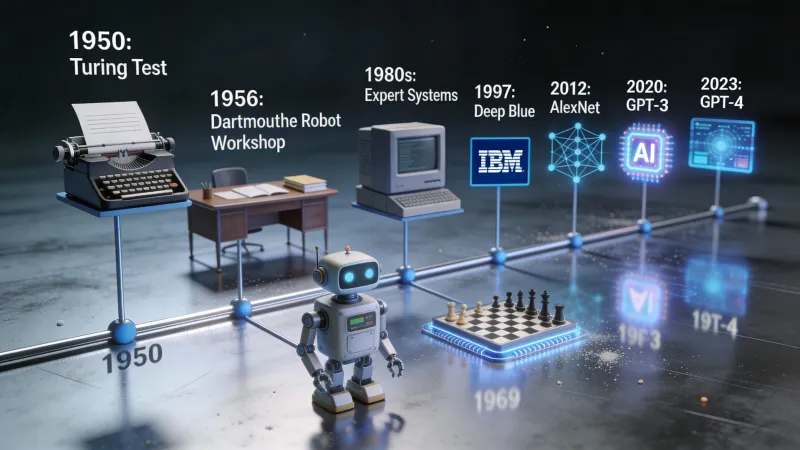

1950: Eine Frage verändert alles

Alan Turing veröffentlichte 1950 eine Arbeit, die das gesamte Feld rahmte, bevor es das Feld überhaupt gab. Die Arbeit hieß “Computing Machinery and Intelligence.” Die opening line war schlicht: “I propose to consider the question, ‘Can machines think?’”

Turing wusste, dass Definitionen zum Problem werden würden. Was heißt “denken” überhaupt? Also schlug er einen Umweg vor. Vergessen wir den Versuch, Denken zu definieren. Stattdessen: ein Spiel.

Ein menschlicher Richter führt Textgespräche mit zwei versteckten Teilnehmenden. Einer ist ein Mensch. Einer ist eine Maschine. Wenn der Richter nicht zuverlässig sagen kann, wer wer ist: spielt es dann eine Rolle, ob die Maschine “wirklich” denkt?

Das wurde zum Turing-Test. Er verschob die Debatte von der Philosophie in die Ingenieurskunst. Können wir etwas bauen, das besteht? Diese Frage lässt sich tatsächlich beantworten: durch Experimente, durch Bauen und Testen und Iterieren.

Turing starb 1954. Er erlebte nicht mehr, wie KI-Forschung zu einem Feld wurde. Aber seine Rahmung prägt bis heute, wie wir KI-Systeme bewerten.

1956: Sommerlager für die Zukunft

Sechs Jahre nach Turings Arbeit traf sich eine Gruppe von Forschenden am Dartmouth College in New Hampshire zu einem Sommer-Workshop. John McCarthy organisierte ihn. Marvin Minsky war da. Claude Shannon auch, der die Informationstheorie erfunden hatte.

Der Vorschlag, den sie verfassten, enthält den Satz, der alles definierte, was danach kam: “The study is to proceed on the basis of the conjecture that every aspect of learning or any other feature of intelligence can in principle be so precisely described that a machine can be made to simulate it.”

Lesen Sie das noch einmal. Jeder Aspekt des Lernens. Jedes Merkmal von Intelligenz. Kann präzise beschrieben werden. Kann von einer Maschine simuliert werden.

Das war keine bescheidene Behauptung. Das war eine Wette darauf, dass menschliche Intelligenz, was auch immer sie ist, auf Regeln und Berechnungen reduzierbar ist. Dass am Denken nichts grundsätzlich außerhalb dessen liegt, was Maschinen können.

Der Begriff “artificial intelligence” wurde in diesem Workshop geprägt. Die Teilnehmenden wurden für die nächsten vierzig Jahre die Köpfe des Feldes. Sie waren brillant. Und sie waren auch wild optimistisch, was Zeitpläne anging.

Die 1960er: Optimismus dreht durch

Das Jahrzehnt nach Dartmouth war produktiv und aufregend und bereitete am Ende den ersten Absturz vor. Forschende bauten Programme, die mathematische Sätze beweisen, Dame spielen, Wortprobleme lösen und einfache Gespräche führen konnten.

ELIZA erschien 1966. Joseph Weizenbaum am MIT baute einen Chatbot, der vorgab, Psychotherapeut zu sein. Er funktionierte über Musterabgleich. Nutzer sagt “Ich bin traurig.” ELIZA antwortet: “Warum sagen Sie, dass Sie traurig sind?” Kein Verständnis. Nur Textmanipulation.

Dann passierte etwas Unerwartetes. Menschen bauten emotionale Bindungen zu ELIZA auf. Sie vertrauten sich ihm an. Manche glaubten, sie sprächen mit etwas, das sich um sie kümmert. Weizenbaum war davon beunruhigt. Den Rest seiner Karriere warnte er vor den Gefahren, Maschinen menschliche Eigenschaften zuzuschreiben.

Ende der 1960er machten Forschende Vorhersagen, die heute absurd wirken. Herbert Simon sagte, Maschinen würden innerhalb von zwanzig Jahren jede Arbeit erledigen, die ein Mensch erledigen kann. Minsky behauptete, das Problem der künstlichen Intelligenz sei innerhalb einer Generation “substantially solved”.

Das Geld floss weiter. DARPA pumpte Mittel in KI-Labore. Die Zukunft schien garantiert.

1973–1980: Die Eiszeit bricht an

Dann schlug die Realität zu.

1973 beauftragte die britische Regierung den Mathematiker James Lighthill damit, KI-Forschung zu bewerten. Sein Bericht war vernichtend. Das zentrale Ergebnis: “In no part of the field have the discoveries made so far produced the major impact that was then promised.”

Lighthill argumentierte, die Forschung sei an grundlegende Grenzen gestoßen. Das Problem der “combinatorial explosion” bedeutete, dass reale Aufgaben zu viele Möglichkeiten haben, um sie durchzusuchen. Die cleveren Tricks, die bei Spielzeugproblemen funktionierten, versagten bei allem, was nach echter Anwendung aussah.

Großbritannien strich KI-Förderung. Forschungslabore, die geblüht hatten, sahen ihre Budgets fast über Nacht verschwinden. DARPA, auf der anderen Seite des Atlantiks, wurde nervös. Man verlangte praktische militärische Anwendungen statt Grundlagenforschung. Auch in den USA trocknete das Geld aus.

Das war der erste KI-Winter. Keine Abkühlung. Ein Kollaps.

Warum passierte das? Die Versprechen waren zu groß. Die Probleme waren zu schwer. Die Computer waren zu langsam. Forschende hatten frühe Erfolge auf eng begrenzten Problemen für ein Zeichen gehalten, dass allgemeine Intelligenz nahe ist.

Der Winter dauerte ungefähr sieben Jahre. KI wurde zum Karriererisiko. Den Begriff in Förderanträgen zu benutzen, konnte Ihren Antrag versenken. Wer im Feld blieb, tat es leise, arbeitete an engeren Problemen mit weniger glamourösen Namen.

1980–1987: Falscher Frühling

KI kam zurück. Der Treiber waren “Expertensysteme.” Das waren Programme, die menschliches Wissen als Regeln kodierten. Wenn der Patient Fieber und Husten hat und Kontakt zu jemandem mit Grippe hatte, dann hat der Patient vermutlich Grippe. Wenn das Gerät schleifende Geräusche macht und der Ölstand niedrig ist, dann ist das Lager vermutlich dabei zu versagen.

Unternehmen liebten das. Betriebe konnten festhalten, was ihre besten Mitarbeitenden wussten, und es über die Organisation skalieren. Es wurden Spezialcomputer gebaut, nur um Expertensysteme zu betreiben. Eine Firma namens Symbolics verkaufte KI-Hardware für Hunderttausende Dollar pro Maschine.

Investitionen fluteten zurück. Unternehmenslabore öffneten. Der Begriff “artificial intelligence” war wieder salonfähig. Mitte der 1980er war die KI-Industrie Milliarden wert.

Aber Expertensysteme hatten ein Grundproblem. Sie konnten nicht lernen. Jedes Wissensstück musste von Hand einprogrammiert werden. Ihre Pflege war ein Albtraum. Mit zunehmender Zahl der Regeln wurden sie spröde und unberechenbar. Und als billigere Universalrechner von Sun und Apple in der Leistung aufschlossen, brach der Markt für Spezialhardware zusammen.

1987–1993: Der zweite Winter

Der Absturz war beim zweiten Mal schlimmer. Unternehmenslabore schlossen. Symbolics ging bankrott. Die verbleibenden KI-Forschenden nannten das, was sie taten, lieber “Maschinelles Lernen” oder “Neuronale Netze” oder irgendetwas, das die toxischen Worte “artificial intelligence” vermied.

Wenn Sie 1990 an KI gearbeitet haben, hätten Sie es auf Partys wahrscheinlich nicht zugegeben.

Und doch passierte unter der Oberfläche etwas Wichtiges. Eine kleine Gemeinschaft arbeitete weiter an neuronalen Netzen, einer Technologie, die in den 1960ern abgetan worden war. Sie verbesserten die Algorithmen. Sie warteten, bis Computer nachzogen. Und vor allem begann das Internet, riesige Mengen digitalen Textes und digitaler Bilder zu erzeugen.

Die Zutaten für den nächsten Durchbruch setzten sich zusammen.

Warum die Winter endeten

Hier ist der Teil, den die meisten KI-Geschichten auslassen: Warum endeten die Winter? Was änderte sich?

Drei Dinge änderten sich.

Erstens: Rechenleistung verdoppelte sich weiter. Moores Gesetz bedeutete, dass ein Computer im Jahr 2010 millionenfach leistungsfähiger war als einer im Jahr 1970. Probleme, die rechnerisch unmöglich waren, wurden machbar.

Zweitens: Daten wurden reichlich. Das Internet änderte alles. Plötzlich hatten Forschende Zugriff auf Milliarden Dokumente, Millionen Bilder, Aufnahmen von Tausenden Stunden Sprache. Neuronale Netze brauchen Daten so, wie Pflanzen Sonnenlicht brauchen. Das Internet lieferte genug Licht, um etwas Großes wachsen zu lassen.

Drittens: Algorithmen wurden besser. Backpropagation machte das Training tiefer neuronaler Netze praktikabel. Dropout verhinderte Überanpassung. Bessere Architekturen wie faltungsneuronale Netze funktionierten gut für Bilder. Schrittweiser Fortschritt sammelte sich zu qualitativem Wandel.

Keiner dieser Faktoren allein reichte aus. Zusammen schufen sie Bedingungen für einen Durchbruch, der alles zuvor Dagewesene in den Schatten stellen würde.

2012: Das Jahr, das alles veränderte

Im Oktober 2012 trat ein Team der University of Toronto bei der ImageNet Large Scale Visual Recognition Challenge an. Der Wettbewerb verlangte, Objekte in Fotos zu erkennen. Eine Million Bilder. Tausend Kategorien.

Das Team nutzte ein tiefes neuronales Netz namens AlexNet. Geoffrey Hinton betreute. Alex Krizhevsky implementierte. Ilya Sutskever steuerte zentrale Ideen bei.

Sie gewannen. Das war zu erwarten. Aber der Abstand schockierte alle.

AlexNet erreichte eine Top-5-Fehlerrate von 15,3 %. Der nächstbeste Beitrag hatte 26,2 %. Das ist keine kleine Verbesserung. Das ist eine andere Leistungsklasse. Das ist der Unterschied zwischen einer Technologie, die irgendwie funktioniert, und einer, die wirklich funktioniert.

Hinton machte später einen Witz über die Zusammenarbeit: “Ilya thought we should do it, Alex made it work, and I got the Nobel Prize.” Der Nobelpreis kam 2024, aber das AlexNet-Ergebnis war es, das alles andere möglich machte.

Binnen Monaten stellte jedes große Tech-Unternehmen Forschende für neuronale Netze ein. Google kaufte ein Startup, das Hinton gegründet hatte. Facebook eröffnete ein KI-Labor. Microsoft baute seine Forschung aus. Das Geld, das KI in den 1980ern verlassen hatte, strömte zurück.

Das war kein falscher Frühling. Die Technologie funktionierte tatsächlich. Sie funktionierte bei echten Problemen in echter Größenordnung mit echtem wirtschaftlichem Wert.

2017: Acht Forschende verändern die Welt

Der nächste Wendepunkt kam aus einer Arbeit mit einem seltsamen Titel. Acht Google-Forschende veröffentlichten im Juni 2017 “Attention Is All You Need”. Der Titel spielte auf einen Beatles-Song an. Der Inhalt revolutionierte die Verarbeitung natürlicher Sprache.

Die Arbeit führte die Transformer-Architektur ein. Frühere Sprachmodelle verarbeiteten Text sequentiell, Wort für Wort. Transformer verarbeiten alles parallel und erlauben jedem Wort, auf jedes andere unabhängig von der Distanz zu “attend”. Das machte das Training viel schneller und erfasste lange Abhängigkeiten in Text deutlich besser.

Jedes große Sprachmodell heute nutzt Transformer. GPT. Claude. Gemini. Llama. Alle stammen von dieser Arbeit aus 2017 ab. Es ist vermutlich die einflussreichste KI-Forschung der letzten Dekade.

Die Autorinnen und Autoren wussten nicht, was sie geschaffen hatten. Die Arbeit ging um maschinelle Übersetzung. Es dauerte Jahre, bis die Konsequenzen klar wurden.

2020: Die Skalierungshypothese bestätigt sich

OpenAI veröffentlichte GPT-3 im Juni 2020. Es hatte 175 Milliarden Parameter. Es konnte Essays schreiben. Es konnte Code debuggen. Es konnte Fragen zu fast allem beantworten. Manchmal erfand es Dinge. Aber wenn es funktionierte, funktionierte es auf eine Art, die fast magisch wirkte.

Die Reaktion von Entwicklerinnen, Entwicklern und Forschenden war heftig. Ein viraler Tweet traf den Moment: “Playing with GPT-3 feels like seeing the future.”

OpenAIs CEO Sam Altman versuchte, die Erwartungen zu dämpfen. “The GPT-3 hype is way too much,” schrieb er. Aber der Geist war aus der Flasche.

GPT-3 bewies etwas Wichtiges. Die Skalierungshypothese besagte, dass neuronale Netze, wenn man sie größer macht und auf mehr Daten trainiert, weiter klüger werden. Viele Forschende waren skeptisch. GPT-3 zeigte, dass die Skeptiker falsch lagen.

30. November 2022: Die Öffentlichkeit entdeckt KI

ChatGPT startete an einem Mittwoch. Fünf Tage später tweetete OpenAI-CEO Sam Altman: “ChatGPT launched on wednesday. today it crossed 1 million users!”

Zwei Monate danach hatte es 100 Millionen Nutzer. Keine Verbraucher-App war jemals so schnell gewachsen. Nicht Facebook. Nicht TikTok. Nicht Instagram. Nichts.

Was machte ChatGPT anders als GPT-3? Es war kostenlos. Es war dialogorientiert. Es war darauf optimiert, hilfreich und harmlos zu sein. Jeder konnte es ausprobieren, ohne API-Schlüssel und ohne Kreditkarte.

Das war der Moment, in dem KI aufhörte, nur eine Technikgeschichte zu sein. Ihre Kolleginnen und Kollegen nutzten es. Ihre Eltern fragten danach. Ihre Kinder machten Hausaufgaben damit.

Das Feld, das beinahe zweimal gestorben wäre, war jetzt die meistdiskutierte Technologie der Welt.

Wo stehen wir jetzt?

Anfang 2026 hat ChatGPT 800 Millionen wöchentlich aktive Nutzer. Das sind grob 10 % der erwachsenen Weltbevölkerung, die ein KI-Werkzeug nutzt. GPT-5 existiert. Claude existiert. Gemini existiert. Open-Source-Modelle von Meta und Mistral haben leistungsfähige KI für alle zugänglich gemacht, die ordentliche Hardware haben.

Das Geld, das in KI fließt, überragt alles aus früheren Booms. Hunderte Milliarden Dollar. Neue Rechenzentren, auf mehreren Kontinenten gebaut, ausdrücklich, um KI-Modelle zu trainieren.

Ist das noch ein Boom oder schon eine Blase? Wird es einen dritten Winter geben?

Die ehrliche Antwort: niemand weiß es. Aber ein paar Dinge sind diesmal anders.

Die Technologie liefert echten Wert. ChatGPT ist nicht ELIZA. Es kann tatsächlich bei echter Arbeit helfen. Unternehmen nutzen KI, um Code zu schreiben, Daten zu analysieren, Dokumente zusammenzufassen und Dutzende anderer Aufgaben zu erledigen, die echte Zeit und echtes Geld sparen.

Die Fähigkeiten sind demonstrierbar. Frühere KI-Booms liefen auf Versprechen. Dieser läuft auf Produkten, die Menschen heute nutzen können.

Die Risiken sind real. Diese Modelle halluzinieren manchmal. Sie können manipuliert werden. Sie werfen Fragen zu Jobs, Desinformation und Machtkonzentration auf, die frühere KI-Systeme nie gestellt haben.

Das Muster, das man sich merken sollte

Fünfundsiebzig Jahre KI-Geschichte lehren eine konstante Lektion. Durchbruch führt zu Hype. Hype führt zu Überversprechen. Überversprechen führt zu Enttäuschung. Enttäuschung führt zu Winter.

Die Durchbrüche seit 2012 sind real. Transformer haben verändert, was möglich ist. ChatGPT hat verändert, wer es nutzt. Aber die Geschichte legt Demut bei Vorhersagen nahe.

Die Forschenden, die 1965 sagten, menschenähnliche KI sei zwanzig Jahre entfernt, lagen falsch. Die Forschenden, die heute Ähnliches sagen, könnten auch falsch liegen. Oder sie könnten recht haben. Die ehrliche Antwort ist: niemand weiß es.

Was wir wissen: KI-Werkzeuge sind heute für bestimmte Aufgaben nützlich. Zu verstehen, woher sie kommen, hilft dabei, Realität von Hype zu trennen. Diese Trennung hat Wert.

Das Feld, das zweimal starb, ist heute Billionen wert. Ob das so bleibt, hängt davon ab, ob die Technologie weiter liefert. Bisher tut sie es. Aber wir waren schon einmal hier.