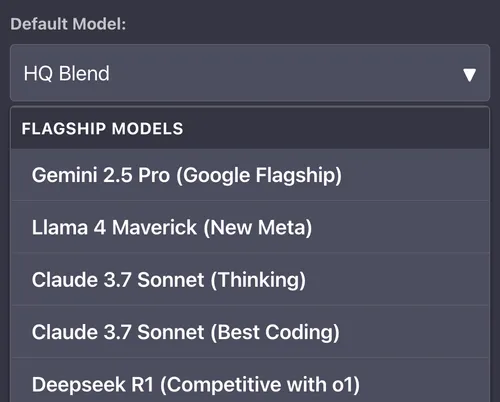

DatBot Blends

- Fast Blend: Un mélange de modèles incroyables qui retournent >200 tokens/seconde minimum de nos partenaires, visant le niveau de qualité de ChatGPT.

- HQ Blend: Notre blend plus lent, mais de qualité incroyablement élevée, incluant quelques-uns des meilleurs modèles disponibles à tout moment.

- Thinking Blend: Modèles de réflexion de haute qualité de différents laboratoires de pointe pour s’assurer que différentes architectures collaborent sur vos réponses.

- Cascade (Cascade de Perspectives): Plusieurs modèles explorant différentes perspectives, synthétisant une sortie finale plus précieuse qu’un seul modèle pourrait.

- DB-1 (Raisonnement Profond): Raisonnement à sortie longue - capable de gérer des projets plus longs avec des besoins plus complexes.

- DB-1 Flash (Raisonnement Profond Flash): Version ultra-rapide du Raisonnement Profond, combinant raisonnement à sortie longue avec rapidité.

Les DatBot Blends et Cascade de Perspectives sont, à ma connaissance, la première fois que des modèles “de pointe” ont été mis dans une capacité de génération mélangée pour améliorer leur performance. Vous pouvez en lire plus dans le post DatBot sur les blends, ici. Pas d’origine unique ici!

Deep Reasoning et Deep Reasoning Flash ont été parmi les premiers vrais succès à générer des sorties longues plus fortes - maintenant les modèles de raisonnement s’améliorent nativement, et cela pousse les meilleurs modèles à un autre niveau encore.

Modèles OpenAI

Modèles de Réflexion:

- GPT-5.1: Le modèle de réflexion le plus récent et avancé d’OpenAI, avec un raisonnement adaptatif qui ajuste dynamiquement le temps de réflexion selon la complexité de la tâche

- GPT-5.1 Codex: Modèle de réflexion pleine taille axé sur le code, nativement entraîné pour les flux de travail de code agentique

- GPT-5.1 Codex Mini: Version plus petite et plus rapide de GPT-5.1 axée sur le code

- GPT-5.1 Low: Variante à faible effort de raisonnement pour des réponses plus rapides

- GPT-5.1 High: Variante à effort de raisonnement élevé pour les problèmes complexes

- GPT-OSS-120b: Modèle de réflexion open-source d’OpenAI avec 120 milliards de paramètres

- GPT-5 Mini: Version plus petite et plus rapide de GPT-5

- GPT-5 Nano: La plus petite variante de GPT-5, excellente pour les tâches simples

Modèles Sans Réflexion:

- GPT-5.1 Chat (Version ChatGPT): Variante sans réflexion de GPT-5.1, exactement comme ChatGPT

- GPT-4o: Le modèle que ChatGPT utilisait (maintenant obsolète, utilisez GPT-5.1 Chat à la place)

Les modèles d’OpenAI sont à la pointe de la technologie IA, repoussant les limites de ce que l’IA peut accomplir. Ils ont prouvé ce qui est possible. Étroitement partenaires de Microsoft.

Modèles Anthropic

Modèles de Réflexion:

- Claude Opus 4.5 (Thinking): Le modèle le plus avancé de Claude avec des capacités de réflexion/raisonnement

- Claude Sonnet 4.5 (Thinking): Sonnet 4.5 avec capacités de réflexion pour un raisonnement complexe

- Claude Haiku 4.5 (Thinking): Modèle de réflexion ultra-rapide, offre des performances de code similaires à Claude Sonnet 4 à un tiers du coût et plus du double de la vitesse

Modèles Sans Réflexion:

- Claude Opus 4.5: Variante sans réflexion, excellente pour l’écriture créative

- Claude Sonnet 4.5: Variante sans réflexion, excellente pour le code et les tâches générales

Les modèles ‘Sonnet’ tendent à être les meilleurs en rapport qualité-prix - Sonnet 4.5 est un modèle de code incroyable, par exemple (je l’utilise tout le temps). Opus est souvent le meilleur écrivain, à n’importe quel prix. Haiku 4.5 offre maintenant une capacité remarquable à une vitesse fulgurante - il y a seulement six mois, ce niveau de performance aurait été l’état de l’art.

Modèles Google

Modèles de Réflexion:

- Gemini 3 Pro (Thinking): Le modèle de raisonnement le plus avancé de Google, avec plus de 50 % d’amélioration dans les tâches de benchmark résolues vs Gemini 2.5 Pro, avec une fenêtre de contexte de 1M tokens

- Gemini 2.5 Flash (Thinking): Modèle de réflexion haute vitesse de Google

Modèles Sans Réflexion:

- Gemini 2.5 Flash: Le meilleur modèle haute vitesse de Google sans réflexion

- Gemini 2.0 Flash: Excellent rapport qualité-prix

Google c’est… eh bien, Google. Ils font à la fois des modèles Gemini à code fermé qui compètent à la pointe, et des modèles à poids ouverts (Gemma) que n’importe qui peut exécuter. Gemini 3 Pro représente un grand bond dans la compréhension multimodale à travers le texte, les images, l’audio et la vidéo.

Modèles xAI

- Grok 4 (Thinking): Le modèle de réflexion phare de xAI, entraîné avec l’apprentissage par renforcement pour utiliser des outils comme l’interpréteur de code et la navigation web. Premier modèle à obtenir 50 % sur l’Examen Final de l’Humanité.

- Grok 4 Fast: Version rentable avec des performances similaires à Grok 4 mais 40 % moins de tokens de réflexion et une fenêtre de contexte de 2 millions de tokens

xAI et Elon Musk ont une rivalité avec OpenAI qui s’intensifie. Avec xAI achetant X (anciennement Twitter), ils ont une source unique de données d’entraînement comme Facebook où Google ont, et ils investissent rapidement dans les GPUs. Grok 4 à atteint des scores révolutionnaires sur ARC-AGI-2, presque doublant l’état de l’art commercial précédent.

Modèles Meta

(Meta possède Facebook, Instagram, Threads, WhatsApp, Oculus, etc. C’est comme Google qui fait techniquement partie d’Alphabet avec Waymo etc.)

- Llama 4 Maverick: Meilleur concurrent livre pour livre - rapide, prix raisonnable, comparable à DeepSeek V3

- Llama 3.3 70b: Excellence livre pour livre de la génération précédente (maintenant obsolète mais toujours disponible)

Meta est le porte-étendard de l’IA quasi-open source (il y a quelques limites dans leur licence, mais pas significatives sauf si vous êtes une entreprise de plusieurs milliards de dollars).

Modèles Deepseek

- Deepseek Chat V3.1 (Thinking): Le dernier modèle de réflexion de DeepSeek avec d’excellentes capacités de raisonnement. Nous utilisons des fournisseurs plus chers qui n’entraînent pas sur la sortie, au lieu de DeepSeek lui-même (qui entraîne sur votre sortie).

- Deepseek Chat V3.1: Excellent et peu coûteux modèle sans réflexion de DeepSeek. Nous utilisons des fournisseurs plus chers qui n’entraînent pas sur les sorties, pour des raisons de confidentialité.

DeepSeek est un laboratoire d’IA chinois incroyable produisant d’excellents modèles à des coûts remarquablement bas. Nous priorisons votre vie privée en utilisant des fournisseurs qui n’entraînent pas sur vos conversations.

Modèles Qwen

- Qwen 3 235b (Thinking): Le plus grand modèle de réflexion d’Alibaba avec 235 milliards de paramètres

- Qwen 3 235b Instruct: Variante sans réflexion du modèle 235b

Les modèles Qwen d’Alibaba fournissent d’excellentes performances dans diverses tailles, avec la série Qwen 3 représentant leurs dernières avancées dans les grands modèles de langage.

Modèles MiniMax

- MiniMax M2: Le dernier modèle phare de MiniMax, un MoE de 230B paramètres avec seulement 10B paramètres actifs. Construit pour des performances d’élite en code et tâches agentiques. Modèle à poids ouverts avec le score le plus élevé mondialement, suivant de près GPT-5 (high) et Grok 4. À seulement 8 % du prix de Claude Sonnet et deux fois la vitesse.

MiniMax est une entreprise d’IA chinoise soutenue par Alibaba et Tencent, faisant des modèles exceptionnels. M2 a atteint un score sans précédent pour un modèle ouvert sur les benchmarks d’intelligence, dépassant Gemini 2.5 Pro de Google DeepMind.

Modèles Z-AI (Zhipu AI)

- GLM 4.6 (Thinking): Le modèle de réflexion phare de Z-AI avec 355B paramètres (35B actifs), avec une fenêtre de contexte de 200K tokens. Quasi-parité avec Claude Sonnet 4 sur les tâches de code du monde réel tout en utilisant ~15 % moins de tokens.

Z-AI (Zhipu AI) est une entreprise d’IA chinoise faisant des modèles de grande valeur avec un raisonnement fort. GLM 4.6 est entièrement à poids ouverts avec licence MIT, permettant aux entreprises de l’auto-héberger et de le personnaliser.

Modèles Moonshot AI

- Kimi K2 (Thinking): Le modèle de réflexion phare de Moonshot, l’un des meilleurs LLMs ouverts disponibles avec des capacités agentiques qui battent GPT-5 et Claude Sonnet 4.5 dans certaines tâches. Peut sélectionner automatiquement 200-300 outils pour compléter des tâches de manière autonome.

- Kimi K2 0905: Variante sans réflexion mise à jour avec des performances de code améliorées et une fenêtre de contexte de 256K tokens, pensez à ChatGPT par défaut

Kimi K2 de Moonshot AI est un modèle MoE de 1 billion de paramètres (32B actifs) soutenu par Alibaba. La variante K2 Thinking est actuellement le modèle de réflexion open source le plus puissant disponible.

Modèles Image, Audio et Vidéo

Nous utilisons une combinaison de modèles qui se mettent à jour au fur et à mesure que nous trouvons de nouveaux champions prix/performance pour différents aspects du site. Ceux-ci peuvent inclure:

- Flux (Kontext, Krea etc.)

- SeeDance/SeeDream

- Veo/Imagen

- GPT-Image

- Modèles ElevenLabs

- Modèles de pointe de parole vers texte et texte vers parole

Ceux-ci sont fréquemment mis à jour, comme nos blends.

Vous cherchez des Intégrations non-LLM?

- Nous avons un scraper web intégré, et pouvons extraire n’importe quel site web que vous voulez, soit via notre implémentation RAG de carte de connaissances - soit via notre interface de chat.

Modèles Retirés

Ces modèles ont été retirés de nos offres principales. Ils peuvent encore être disponibles sur demande mais ont été remplacés par des versions plus récentes.

OpenAI: GPT-5, GPT-5 Low/High, GPT-5 Chat, GPT-OSS-20b, o3, o4-mini, GPT-4.1 Mini, GPT-4.1 Nano, GPT-4o mini, GPT-3.5 Turbo

Anthropic: Claude Opus 4 / Sonnet 4, Claude 3.5 Haiku

Google: Gemini 2.5 Pro (Thinking), Gemini 2.0 Flash Lite

Meta: Llama 4 Scout, Llama 3.1 8b, Llama 3.1 405b

xAI: Grok 3 Mini (Thinking)

Qwen: Qwen 3 32b (Thinking), Qwen 3 30b MoE

Deepseek: Deepseek Chat V3, Deepseek R1

Z-AI: GLM 4.5 / GLM 4.5 Air

MiniMax: MiniMax-01

Mistral AI: Mistral Small V3.2

Cohere: Command-A